Map Side Join与Reduce Side Join:深度比较与实战选择

发布时间: 2024-10-31 13:31:42 阅读量: 16 订阅数: 18

# 1. Map Side Join与Reduce Side Join概念解析

Map Side Join与Reduce Side Join是大数据处理中常见的两种数据连接策略,它们在Hadoop和Spark等大数据处理框架中扮演着重要角色。Map Side Join侧重于在Map阶段完成数据连接,这要求部分数据能够预先加载到各个Mapper节点上。而Reduce Side Join则在Reduce阶段执行数据连接操作,数据通常在网络传输到Reducer节点上进行合并。

在解析这两种技术之前,需要先了解它们的基本概念。Map Side Join适合于特定场景,例如:其中一个数据集足够小,可以将其广播到所有Mapper节点上。另一方面,Reduce Side Join适用于一般情况,不需要额外的数据分配策略,但可能会增加网络负载和磁盘I/O。

接下来,我们将深入探讨这两种Join策略的理论框架、实际应用和性能优化,以便更全面地理解它们的运作机制和适用环境。

# 2. 理论框架下的Map Side Join与Reduce Side Join

### 2.1 Map Side Join理论解析

#### 2.1.1 Map Side Join的工作原理

Map Side Join是基于MapReduce框架的一种连接方法,它通过优化数据的预处理和合理的数据分组,使得多个数据集在Map阶段就已经位于同一台机器上,从而避免了在Reduce阶段进行连接操作。其核心思想是利用Map阶段的输入数据来避免Shuffle阶段的开销。

在Map Side Join中,通常会有一个较大的数据集和一个较小的数据集。这个较小的数据集(通常被称为“小表”)会被复制到所有处理数据的节点上,这样在Map任务执行时,小表已经处于本地,可以与大表进行局部连接,从而加速处理过程。

```java

// 伪代码示例

void map(String key, String value) {

// value是大表的数据

// 小表数据已经在Map任务节点上预加载

for each small_table_record in small_table_records {

emit(new KeyJoinPair(value, small_table_record));

}

}

```

在上述伪代码中,`KeyJoinPair`是自定义的数据结构,用于存储两个数据集的记录。Map任务将大表的数据和小表的数据进行局部连接,并以合适的Key值进行输出。

#### 2.1.2 Map Side Join的适用场景和限制

Map Side Join适用于以下场景:

- 小表数据量小,可以预加载到每个节点的内存中。

- 大表数据量很大,但每个节点处理的数据量需要合理控制,避免内存溢出。

- 需要高效处理数据连接,对性能要求较高。

然而,Map Side Join也存在一些限制:

- 需要额外的预处理步骤来复制小表数据到所有节点。

- 如果小表数据量大,可能不适合Map Side Join,因为复制小表到每个节点可能消耗大量网络带宽和内存资源。

- 如果数据分布不均匀,可能会导致某些节点处理的数据量远大于其他节点,造成负载不均衡。

### 2.2 Reduce Side Join理论解析

#### 2.2.1 Reduce Side Join的工作机制

Reduce Side Join是MapReduce框架中最常见的连接方法,其工作原理较为简单。在这个方法中,Map阶段只是简单地读取数据并输出,然后按照一定的规则将数据进行Shuffle,使得相同Key的数据会发送到同一个Reduce任务中去进行连接操作。

Reduce Side Join的流程一般如下:

1. Map阶段读取数据并提取Key。

2. 根据Key,数据被分配到不同的Reduce任务。

3. Reduce任务读取所有相关的数据并进行连接操作。

```java

// 伪代码示例

void map(String key, String value) {

emit(new KeyRecordPair(key, value));

}

void reduce(String key, Iterator<Record> values) {

// 将所有相同Key的数据进行连接操作

for each record in values {

join(record);

}

}

```

在上述伪代码中,`KeyRecordPair`是自定义的数据结构,它将每个数据记录与其Key值一起输出。Reduce任务接收到相同Key的所有记录后,遍历这些记录并执行连接操作。

#### 2.2.2 Reduce Side Join的优势与不足

Reduce Side Join的优势主要包括:

- 灵活性高,适用于不同大小和分布的数据集。

- 易于实现,不需要对数据进行预处理。

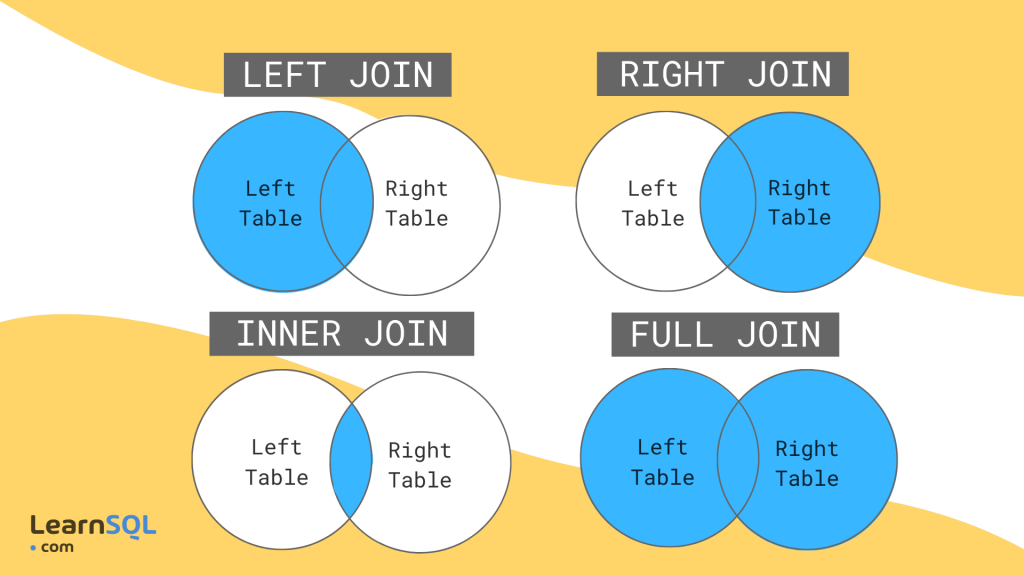

- 可以处理各种复杂的数据连接逻辑,如外连接、内连接等。

然而,Reduce Side Join也存在以下不足:

- 由于涉及到大量数据的Shuffle,其性能开销较大。

- 如果数据分布不均匀,会造成某些Reduce任务负载过重。

- 对于大数据集,Shuffle过程可能会成为系统的瓶颈。

### 2.3 理论对比分析

#### 2.3.1 理论上两者的数据处理对比

在数据处理方面,Map Side Join和Reduce Side Join有明显的对比:

- Map Side Join通过预加载小表到每个节点,减少了Shuffle的数据量,而Reduce Side Join则需要Shuffle所有参与连接的数据。

- Map Side Join在Map阶段就完成连接操作,而Reduce Side Join在Reduce阶段才开始连接。

- Map Side Join要求小表能够适合内存大小,而Reduce Side Join没有这种限制。

#### 2.3.2 理论上性能考量和选择依据

性能考量方面,Map Side Join通常优于Reduce Side Join,因为它减少了网络传输和数据Shuffle的开销。然而,选择依据需要考虑以下因素:

- 数据量大小:小表足够小,适合Map Side Join;否则可能需要采用Reduce Side Join。

- 数据分布:Map Side Join要求数据分布均匀;而Reduce Side Join对数据分布的要求不严。

- 系统资源:考虑内存和网络资源的限制,合理选择连接策略。

- 执行效率:根据具体的业务需求和系统资源,选择能够提供最佳执行效率的方法。

通过上述对比和考量,我们可以更有针对性地选择合适的连接策略,以满足不同的数据处理需求。

# 3. Map Side Join实战演练

在这一章节中,我们将深入探讨Map Side Join在实际应用中的具体操作流程,以及如何在面对实际问题时进行优化。我们会从环境搭建、实战操作,一直到性能优化等方面,详细展示Map Side Join的完整使用过程。

## 3.1 实战环境搭建

为了能够顺利进行Map Side Join的实战演练,首先需要搭建一个符合要求的环境。这涉及到一系列的配置工作,以及数据的准备。

### 3.1.1 环境准备和依赖配置

在开始操作之前,确保已经搭建了适合MapReduce作业执行的环境。这通常意味着需要一个Hadoop集群,节点之间网络通畅,同时安装了必要的库和依赖。

```sh

# 安装Hadoop

sudo apt-get install hadoop

# 配置Hadoop环境变量

export JAVA_HOME=/path/to/java

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/path/to/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

# 格式化Hadoop文件系统(首次运行需要)

hadoop namenode -format

```

### 3.1.2 实战案例的选择和数据准备

选择一个适合Map Side Join的案例至关重要,它需要具备能够通过Map Side Join显著提高效率的特征,例如小表数据量远小于大表。

```text

# 假设案例:关联商品详情和订单信息

# 商品详情表(小表)

product_id, product_name, product_price

1, "Laptop", 900

2, "Phone", 400

# 订单信息表(大表)

order_id, product_id, customer_id

1001, 1, A123

1002, 2, B345

```

### 3.1.3 数据格式准备

数据需要被转换为适合MapReduce处理的格式,通常为文本文件或CSV文件,存储在HDFS中。

```sh

# 上传数据到HDFS

hadoop fs -put /path/to/local/product.csv /path/to/hdfs/product

hadoop fs -put /path/to/local/order.csv /path/to/hdfs/order

```

## 3.2 Map Side Join实战操作

在准备好了环境和数据之后,我们来到操作实战部分,展示如何执行Map Side Join操作。

### 3.2.1 Map Side Join的操作步骤

下面是一个Map Side Join操作的简要示例代码。

```java

public static class MapSideJoinMapper extends Mapper<LongWritable, Text, Text, Text> {

private Map<String, String> productMap = new HashMap<>();

@Override

protected void setup(Context context) throws IOException, InterruptedException {

// 读取商品详情表数据,加载到内存

// 注意:这里假设商品详情表数据量不大,可以全部加载到内存

FileSplit split = (FileSplit) context.getInputSplit();

String fileName = split.getPath().getName();

if (fileName.startsWith("product")) {

// 处理商品详情表数据

// ...

productMap.put(product_id, product_name + "," + product_price);

}

}

@Override

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String line = value.toString();

String[] fields = line.split(",");

// 订单信息

String product_id = fields[1];

// 如果内存中有这个产品的详情,则输出

if (productMap.containsKey(product_id)) {

context.write(new Text(product_id), new Text(productMap.get(product_id) + "," + fields[0]));

}

}

}

```

### 3.2.2 实战中遇到的问题及解决办法

在实际操作中,可能会遇到诸如内存溢出等问题,因为Map Side Join将小表加载到内存中。一种解决方案是使用`-Xmx`参数增加JVM的最大堆内存。

```sh

# 增加最大堆内存

hadoop jar MapSideJoin.jar MapSideJoinMapper MapSideJoinReducer /path/to/hdfs/input/product /path/to/hdfs/input/order /path/to/hdfs/output

-D mapreduce.job.maps=10 -Xmx4g

```

## 3.3 性能优化策略

由于Map Side Join将数据加载到内存,优化策略通常围绕着内存管理展开。

### 3.3.1 针对Map Side Join的性能调优

为了优化Map Side Join的性能,可以采取以下策略:

- **选择合适的数据格式**:比如使用高效的序列化框架(如Avro或Protocol Buffers)减少内存占用和网络传输。

- **分区策略**:合理分配内存分区,避免数据倾斜导致的内存过载。

- **内存管理**:通过调整JVM参数合理分配内存,确保不会有内存溢出的情况发生。

### 3.3.2 案例中性能测试和评估

在特定案例中,性能测试和评估是必要的。可以通过测试Map Side Join的执行时间、内存占用等指标来评估性能。

```sh

# 性能测试示例命令

time hadoop jar MapSideJoin.jar MapSideJoinMapper MapSideJoinReducer /path/to/hdfs/input/product /path/to/hdfs/input/order /path/to/hdfs/output

```

### 3.3.3 实际案例性能优化

基于实际案例进行优化,例如调整内存设置、使用压缩数据等,能显著提高Map Side Join的性能。

```sh

# 使用压缩数据格式,比如Snappy

hadoop jar MapSideJoin.jar MapSideJoinMapper MapSideJoinReducer /path/to/hdfs/input/product /path/to/hdfs/input/order /path/to/hdfs/output

-D mapreduce.input.fileinputformat.input.dir.recursive=true -D mapred.map.tasks.speculative.execution=***press=***pression.type=BLOCK

```

## 3.4 本章小结

在本章中,我们深入探讨了Map Side Join实战演练的各个方面,包括环境搭建、操作步骤、遇到的问题及其解决方案,以及性能优化策略。通过本章内容,读者应能够独立执行Map Side Join操作,并在实践中遇到的问题上做出有效应对。下一章我们将转向Reduce Side Join的实战演练,对比两种技术的优劣,并提供具体的实战案例。

# 4. Reduce Side Join实战演练

## 4.1 实战环境搭建

### 4.1.1 环境准备和依赖配置

为了进行Reduce Side Join的实战演练,我们需要配置一个合适的环境。通常这包括一个支持MapReduce计算模型的分布式处理框架,比如Apache Hadoop。以下步骤用于准备和配置环境:

1. **安装Hadoop**: 确保你的系统中已经安装了Hadoop,并且版本兼容MapReduce任务的执行。如果尚未安装,可访问[Apache Hadoop官网](***进行下载和安装。

2. **配置Hadoop环境**: 编辑`$HADOOP_HOME/etc/hadoop/hadoop-env.sh`文件,设置JAVA_HOME环境变量。

3. **验证安装**: 运行`hadoop version`命令验证Hadoop是否正确安装。你应当看到版本信息和一些配置信息。

4. **准备数据**: 准备适合进行Reduce Side Join的两个数据集。这些数据集应该包含需要连接的键值对。

5. **配置HDFS**: 将你的输入数据上传到HDFS(Hadoop分布式文件系统)中,确保MapReduce作业可以访问它们。

### 4.1.2 实战案例的选择和数据准备

为演示Reduce Side Join,我们使用以下案例:

假设有两个数据集:一个销售记录表(`sales.csv`),包含订单ID和产品ID;另一个产品信息表(`products.csv`),包含产品ID和产品名称。目标是将这两个表连接起来,以获得包含订单ID、产品ID和产品名称的完整列表。

**数据准备步骤**:

1. **准备销售记录表**(`sales.csv`):

```

order_id,product_id

101,ABC001

102,ABC002

103,ABC003

```

2. **准备产品信息表**(`products.csv`):

```

product_id,product_name

ABC001,Widget

ABC002,Doohickey

ABC003,Gadget

```

3. **将数据上传至HDFS**:

```bash

hadoop fs -put sales.csv /data/sales.csv

hadoop fs -put products.csv /data/products.csv

```

## 4.2 Reduce Side Join实战操作

### 4.2.1 Reduce Side Join的操作步骤

执行Reduce Side Join主要包含以下步骤:

1. **编写Mapper类**: Mapper读取两个输入数据集,并将键值对输出。键是连接键(在我们的案例中是`product_id`),值是一个包含记录名和连接键的中间值。

2. **编写Reducer类**: Reducer接收所有具有相同键的记录值,然后执行连接操作。因为所有来自相同键的值都会到达同一个Reducer,所以可以在这里合并它们。

以下是简化的Java代码示例:

```java

public class ReduceSideJoinMapper extends Mapper<LongWritable, Text, Text, Text> {

private Text outKey = new Text();

private Text outValue = new Text();

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] fields = value.toString().split(",");

// 假设第一行是标题,从第二行开始读取

if (fields.length > 1) {

outKey.set(fields[1]); // 设置连接键

outValue.set("1#" + fields[0]); // "1#" 是标记,表示数据来自第一个文件

context.write(outKey, outValue);

}

}

}

public class ReduceSideJoinReducer extends Reducer<Text, Text, Text, Text> {

private Text result = new Text();

public void reduce(Text key, Iterable<Text> values, Context context) throws IOException, InterruptedException {

String productInfo = null;

List<String> salesRecords = new ArrayList<>();

for (Text val : values) {

if (val.toString().startsWith("1#")) {

salesRecords.add(val.toString().substring(2)); // 去掉标记,保留销售记录ID

} else {

productInfo = val.toString().substring(2); // 去掉标记,保留产品信息

}

}

for (String record : salesRecords) {

result.set(record + "#" + productInfo);

context.write(null, result);

}

}

}

```

### 4.2.2 实战中遇到的问题及解决办法

在实际的MapReduce作业执行过程中,可能会遇到性能瓶颈,内存溢出,以及数据倾斜等问题。针对这类问题,可以采取以下解决策略:

- **性能瓶颈**: 调整Map和Reduce任务的并行度(通过设置`mapreduce.job.maps`和`mapreduce.job.reduces`参数)。

- **内存溢出**: 优化Reducer的内存使用,如设置合理的内存限制和优化内存中的数据处理逻辑。

- **数据倾斜**: 通过抽样预估数据分布,进行键值范围划分,避免数据在某一Reducer集中。

## 4.3 性能优化策略

### 4.3.1 针对Reduce Side Join的性能调优

性能优化包括调整作业的配置参数和优化MapReduce编程逻辑:

- **调整MapReduce配置**: 如设置`mapreduce.job.maps`和`mapreduce.job.reduces`等参数来优化作业并行度。

- **使用Combiner**: 对中间结果进行局部聚合,减少数据在网络中的传输量。

- **输入数据预处理**: 通过合理预分区(partitioning)减少数据倾斜。

### 4.3.2 案例中性能测试和评估

在进行了上述优化后,可以使用Hadoop内置的计数器和监控工具来追踪作业执行情况。例如,使用`mapreduce.job.reduce.inputbytes`和`mapreduce.job.reduce.inputrecords`来评估输入数据的大小和数量。通过这些信息,可以量化性能提升并针对性地进行进一步优化。

在实际场景中,优化策略的选择和应用将直接影响作业执行的效率和结果质量。因此,在生产环境中,需要根据作业的特性进行量身定制的优化。

# 5. Map Side Join与Reduce Side Join选择指南

## 5.1 数据量和数据分布的影响

### 5.1.1 数据量大小对选择的影响

在大数据处理中,数据量的大小是选择Join策略的一个关键因素。Map Side Join更适合于处理较小的数据集,因为它依赖于将小数据集完整地加载到每个Mapper的内存中。当数据量适中或较大时,由于内存的限制,Map Side Join可能无法执行或者效率很低。

具体来说,如果小数据集可以被有效压缩,其内存占用量可能远远小于原始大小。此外,在Map Side Join中,小数据集在内存中的查找操作比磁盘I/O要快得多,这进一步增加了这种策略的吸引力。不过,如果小数据集太大,以至于无法装入内存,使用Map Side Join就会变得不切实际。

### 5.1.2 数据分布特性对选择的影响

数据分布特性也对Join策略的选择产生重要影响。例如,如果小数据集中的数据是均匀分布的,Map Side Join的效果可能更好,因为这样可以更均匀地分摊数据到各个Mapper节点,使得处理更加平衡。相反,如果数据倾斜,即一些key拥有比其他key多得多的记录,那么某些Mapper节点可能会被过度加载,而其他节点则可能比较空闲,造成资源利用不均衡。

在Map Side Join中,数据倾斜问题可以通过数据预处理阶段的Shuffle操作来减少,但在某些情况下,如果预处理不能有效地解决倾斜问题,则可能需要考虑使用Reduce Side Join或其他策略。

## 5.2 系统资源和执行效率的权衡

### 5.2.1 系统资源限制下的选择

系统资源的可用性和限制对选择Join策略具有决定性作用。如果集群的内存资源非常丰富,那么使用Map Side Join的可行性更高,因为有足够的内存空间来处理数据集。反之,如果内存资源紧张,尤其是当小数据集无法被整个装入内存时,使用Reduce Side Join可能更为合适。

另外,Map Side Join可能会产生较高的CPU开销,因为它在每个Mapper中都执行了内存中的查找操作。因此,如果CPU资源有限,而内存资源充足,那么即使数据集大小合适,也可能需要考虑资源的总体配置。

### 5.2.2 执行效率和成本的考虑

执行效率和成本是企业实施大数据处理时经常考虑的因素。Map Side Join由于减少了数据在网络中的传输和在Reducer上的处理,因此在执行效率上往往具有优势。但是,这需要以足够的内存资源为前提。反之,Reduce Side Join虽然在数据传输和处理上开销更大,但它在资源受限的情况下提供了一种可行的替代方案。

在选择策略时,需要根据实际业务需求和成本效益分析来平衡效率和成本。例如,在对实时性要求较高的场景中,可能会优先考虑执行效率,而在成本敏感的场景中,则可能更倾向于成本较低的解决方案。

## 5.3 实际应用场景分析

### 5.3.1 典型应用场景的适用性分析

Map Side Join和Reduce Side Join各自适用于不同的典型场景。例如,在数据仓库的星型模式中,通常有一张小维表和一张大事实表需要进行关联。在这种情况下,Map Side Join是较为理想的选项,因为可以将维表加载到每个Mapper的内存中,并在Map阶段直接与事实表的数据进行合并。

另一方面,在数据预处理或ETL任务中,数据量可能非常巨大,而且难以均匀分布在不同的Mapper中。这种场景下,Reduce Side Join更能适应数据的多样性和不稳定性。

### 5.3.2 选择Map Side Join与Reduce Side Join的实战建议

在实际选择Join策略时,需要综合考虑数据特性、系统资源以及业务需求。通常情况下,Map Side Join适用于以下几种场景:

- 数据集较小,能够完全加载到每个Mapper节点的内存中。

- 数据集数据分布均匀,不会引起处理节点之间的负载不均衡。

- 集群内存资源充足,可以支持内存中的数据操作。

而Reduce Side Join更适合于以下情况:

- 数据集较大,无法完全加载到内存中。

- 数据分布不均匀,存在严重的数据倾斜问题。

- 集群内存资源有限,需要将数据分片到不同的Reducer节点上进行处理。

在实际操作中,建议先对数据进行评估,了解数据的大小和分布特性,以及集群的资源状况。如果可能,进行小规模的测试,比较不同Join策略的性能和资源使用情况,从而做出最合适的选择。

# 6. 展望与未来

## 6.1 大数据框架的演进对Join策略的影响

随着大数据技术的不断发展,新的大数据框架不断涌现,它们带来了更多优化的Join策略和数据处理方法。在未来,我们可以预见一些主要趋势:

### 6.1.1 新兴大数据框架的特点

新兴的大数据框架,例如Apache Flink和Apache Beam,正在改变数据处理的传统观念。这些框架具有以下特点:

- **更高效的流处理能力**:像Flink这样的框架提供了强大的流处理能力,可以实现实时数据处理。这为实时Join操作带来了新的可能性。

- **容错性与状态管理**:新的框架通常集成了更健壮的容错机制,如检查点(checkpointing)和状态管理,确保了即使在故障情况下也能保证数据处理的一致性和可靠性。

- **简化操作的API**:为了提高开发效率,新框架提供的API往往更简洁易用,例如Beam的Pipeline API,使得复杂的Join操作也可以通过简单的API调用完成。

### 6.1.2 对Map Side Join与Reduce Side Join策略的影响预估

- **对Map Side Join的影响**:在具备强大内存管理和优化的数据框架中,Map Side Join可以更加高效地执行,尤其适用于需要处理大量小文件的场景。

- **对Reduce Side Join的影响**:具有改进的排序和分组操作的新框架,将使*** Side Join在处理大规模数据集时更具有优势,尤其是那些需要复杂聚合操作的场景。

## 6.2 机器学习与数据处理的结合

机器学习技术正在逐渐融合到数据处理和存储系统中,这可能会为Join策略带来深远的影响。

### 6.2.1 机器学习在数据处理中的应用前景

机器学习算法在预测数据模式和决策过程中的应用,为数据处理提供了新的途径。在Join操作中,这可能意味着:

- **动态调整Join策略**:通过分析历史数据和实时数据,机器学习算法可以预测最有效的Join策略,动态调整Map和Reduce任务。

- **自动化选择Join方法**:机器学习模型可以学习不同数据集特征和历史执行结果,自动选择最优的Join方法,从而减少人为干预并优化性能。

### 6.2.2 机器学习对优化Join策略的潜在作用

通过机器学习技术,可以对数据处理流程进行深入的洞察和优化,例如:

- **性能优化**:通过机器学习模型预测数据分布和热点,为数据分区和缓存策略提供依据,提高Join操作的效率。

- **异常检测与调整**:机器学习模型可以监测并识别数据处理过程中的异常模式,并建议或自动执行性能调整措施。

## 6.3 结论与展望

在本文中,我们深入探讨了Map Side Join与Reduce Side Join的工作机制和应用案例,并针对如何在实践中选择和优化这些Join策略提供了实用的指南。

### 6.3.1 文章总结

- 我们回顾了两种Join策略的基本概念和适用场景。

- 分析了它们在不同环境下的性能表现,并提供了相应的优化建议。

- 通过实战演练,加深了对两种Join操作的理解,并展示了在现实情况下如何解决遇到的问题。

### 6.3.2 对未来技术趋势的预测与展望

未来,在大数据技术和机器学习算法的双重推动下,我们预计Join策略将变得更加智能和高效。自动化决策、实时优化和数据驱动的执行将使数据处理更加接近“实时”和“智能化”的理想状态。

这将为数据工程师和IT专业人士带来新的挑战和机遇,要求他们不断学习和适应新的技术和方法。最终,这些进步将有助于更有效地挖掘数据的潜在价值,推动企业业务增长和创新。

0

0