Map Side Join工作原理与适用场景:大数据处理的高效策略

发布时间: 2024-10-31 13:50:29 阅读量: 17 订阅数: 18

# 1. Map Side Join简介与基础概念

## 1.1 Map Side Join简介

Map Side Join是分布式计算框架中一种优化的Join操作方法。它通过在Map阶段完成数据的关联操作,避免了数据在网络中的传输以及不必要的排序过程,从而大幅提高了处理效率,特别是当涉及到大表和小表的关联时效果尤为显著。在处理大量数据时,Map Side Join可以减少资源消耗和提高整体处理速度。

## 1.2 基础概念

在Map Side Join中,小表(也称作lookup表)的数据会被载入到每个Map任务中,这个过程通常通过分布式缓存实现。Map任务在读取大表数据的同时,直接利用内存中的小表数据完成Join操作。这使得Map任务可以几乎不经过任何网络传输,直接在内存中处理,减少了Join操作的延迟和提高了吞吐量。

## 1.3 应用场景

Map Side Join适用于以下几种情况:

- 当需要关联的小表数据量适中且可以完全载入内存时。

- 在数据预处理和分析任务中,当关联操作是性能瓶颈时。

- 当系统设计倾向于减少对磁盘I/O操作和网络传输时。

接下来的章节会深入探讨Map Side Join的理论基础、实践应用和优化策略,为读者提供更为全面的理解。

# 2. Map Side Join的理论基础

## 2.1 大数据处理与分布式计算框架

### 2.1.1 分布式计算的基本原理

分布式计算是一种将计算任务分布到多个计算单元上的方法。在大数据处理的背景下,分布式计算框架允许在大规模集群上并行处理数据。这种方法特别适合于处理海量数据集,可以有效提高数据处理的吞吐量和速度。分布式计算的基本原理包括:

- **数据分割**:大数据集被分割成小的数据块,并分布存储在集群中的不同节点上。

- **任务分配**:计算任务被分解成多个子任务,这些子任务被分发到各个节点上并行执行。

- **状态同步**:节点间需要同步计算结果,以确保整个计算过程的一致性。

- **容错机制**:处理过程中遇到节点故障时,系统能够自动恢复并重新调度任务。

分布式计算框架如Hadoop和Spark等,不仅提供数据存储和处理能力,还提供了容错和资源管理的功能。

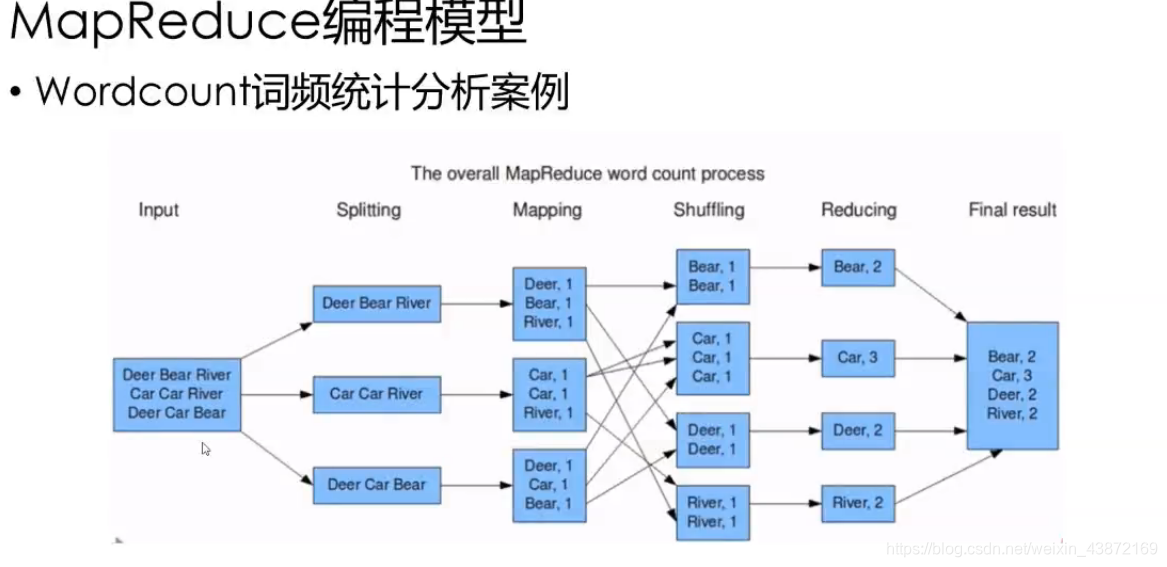

### 2.1.2 Hadoop和MapReduce模型概述

Hadoop是一个开源的分布式存储和计算框架,它包括HDFS(Hadoop Distributed File System)和MapReduce两个核心组件。MapReduce是一种编程模型,用于在Hadoop上处理大规模数据集。

- **HDFS**:Hadoop的分布式文件系统,设计用来存储大量数据并提供高吞吐量的数据访问。HDFS将大文件分割成固定大小的块,这些块由数据节点(DataNode)管理,元数据由名称节点(NameNode)管理。

- **MapReduce**:处理过程分为Map阶段和Reduce阶段。Map阶段处理输入数据,生成中间键值对;Reduce阶段对这些键值对进行汇总处理。MapReduce编程模型抽象了并行处理过程,开发者只需关注Map和Reduce两个函数。

Hadoop MapReduce适用于批处理作业,它可以处理大量的、结构化的数据集。尽管Hadoop MapReduce在大数据处理领域有着广泛的应用,但它在处理某些类型的任务,如需要小数据集与大数据集进行Join操作时,可能会面临效率低下的问题。

## 2.2 Map Side Join的工作机制

### 2.2.1 Join操作在Map Side的处理流程

Map Side Join是MapReduce编程模型中的一种优化技术,用于在Map阶段完成数据的Join操作,从而减少对Reduce阶段的依赖。其基本流程如下:

1. **数据准备**:将需要Join的小表数据加载到每个Map任务的内存中。

2. **数据读取**:Map任务从输入文件读取数据块,这个数据块是待Join的大表数据。

3. **执行Join**:对于大表中的每条记录,Map任务会遍历内存中的小表数据,执行Join操作。

4. **结果输出**:执行完所有Join操作后,Map任务将结果输出到HDFS。

这种机制极大地提高了处理效率,尤其是当小表数据足够小,可以完全加载到内存中时。

### 2.2.2 与Reduce Side Join的对比分析

Reduce Side Join是在Map阶段后,所有数据被传递到Reduce阶段进行处理。它的基本流程包括:

1. **数据分组**:在Map阶段,对每个输入记录进行分组,通常是基于Join键。

2. **数据排序和合并**:Map输出的结果在传递到Reduce之前,会根据Join键进行排序和合并。

3. **执行Join**:Reduce任务接收所有Map的输出数据,执行Join操作。

4. **结果输出**:将最终的Join结果写入到输出文件中。

Map Side Join与Reduce Side Join相比,具有以下几个优势:

- **减少数据移动**:Map Side Join不需要在Map和Reduce之间移动小表数据,减少了网络I/O。

- **降低Shuffle开销**:在Reduce Side Join中,需要对大表数据进行排序和Shuffle,而Map Side Join避免了这些操作。

- **提高效率**:对于小表和大表的Join操作,Map Side Join可以显著提高处理速度。

然而,Map Side Join也有局限性,主要是小表必须足够小,以保证可以加载到内存中。如果小表数据过大,则可能造成内存溢出,导致任务失败。

## 2.3 Map Side Join的数据模型

### 2.3.1 分布式文件系统中的数据组织

分布式文件系统中的数据组织方式对Map Side Join性能有着直接的影响。HDFS中的数据块通常会有副本存储在不同的DataNode上,以提高数据的可靠性和容错性。对于Map Side Join来说,数据组织方式需要考虑以下几点:

- **数据局部性**:在数据存储时尽量保证数据的局部性,这样在Map任务执行时可以更快地读取到数据。

- **数据分布**:数据需要被平均地分布在整个集群中,以避免数据倾斜问题,确保各个Map任务的负载均衡。

### 2.3.2 数据倾斜和数据量的考量

数据倾斜和数据量是影响Map Side Join性能的关键因素。

- **数据倾斜**:当小表中的数据分布极度不均匀时,某些Map任务可能会处理更多的数据,导致它们成为瓶颈。在Map Side Join中,需要特别注意小表数据的分布,避免数据倾斜。

- **数据量考量**:Map Side Join要求小表能够完全加载到内存中。如果小表数据量过大,将会导致内存溢出问题。设计Map Side Join时,需要评估小表数据量,确保其在可接受的内存范围内。

解决数据倾斜和数据量问题通常需要对数据进行预处理,比如重新分布数据或对数据进行分区。

继续下一章内容:第三章:Map Side Join的实践应用

# 3. Map Side Join的实践应用

## 3.1 数据预处理与分区

### 3.1.1 数据的清洗和格式化

在准备Map Side Join之前,数据预处理是关键的一步。数据清洗确保了参与Join的数据质量,避免了脏数据影响最终的计算结果。在Hadoop生态圈中,数据清洗通常涉及去除无效记录、转换数据格式、处理缺失值以及过滤不必要字段等。格式化数据则要求统一字段类型和格式,如日期、数字等。

**代码块示例:**

```shell

# 使用Hive进行数据清洗和格式化

INSERT OVERWRITE TABLE clean_data

SELECT

CAST(date AS DATE) AS formatted_date,

CAST(amount AS DECIMAL(10,2)) AS formatted_amount,

CASE

WHEN customer_id IS NULL THEN 'Unknown'

ELSE customer_id

END AS clean_customer_id

FROM raw_data

WHERE

date IS NOT NULL AND

amount IS NOT NULL;

```

**逻辑分析及参数说明:**

- 通过Hive的SQL语句对原始数据表`raw_data`进行处理。

- `CAST`函数用于将日期和金额字段转换为统一格式。

- `CASE`语句用于处理可能存在的缺失`customer_id`值,将其标记为'Unknown'。

- 最终清洗后的数据被存储在`clean_data`表中。

### 3.1.2 自定义分区策略以优化Join效率

自定义分区策略是影响Map Side Join效率的关键因素。适当的分

0

0