Map Side Join实战应用:大数据处理中的优势与挑战破解

发布时间: 2024-10-31 13:55:08 阅读量: 28 订阅数: 28

19、Join操作map side join 和 reduce side join

# 1. 大数据背景下的Map Side Join概述

大数据的爆发式增长对数据处理技术提出了新的挑战和要求。Map Side Join作为大数据处理中的一项关键技术,在提高查询效率和优化资源使用方面扮演了重要角色。在本章中,我们将介绍Map Side Join在大数据背景下的意义,以及它如何帮助解决大规模数据集处理中遇到的问题。通过理解Map Side Join的概念和优势,读者可以为后续章节深入探讨其原理、实践应用和优化策略打下良好的基础。

# 2. Map Side Join理论基础

### 2.1 Map Side Join的原理

#### 2.1.1 Map Side Join的工作机制

Map Side Join是大数据处理中的一种优化技术,主要应用于两个或多个数据集通过Map阶段即可完成join操作的场景。工作原理是利用分布式文件系统中的数据分布特性,将需要join的数据集通过Map任务并行处理。其核心在于,对于join操作,数据不需要通过网络传送给Reducer,直接在Map任务中完成,从而大大减少了数据在网络中的传输量,提高了处理效率。

在Map Side Join中,通常需要将参与join的小数据集作为驱动数据集(Driver Dataset),在Map任务中对它进行广播(Broadcast)。对于大数据集中的每个key,Map任务从广播的小数据集中查找对应的值,然后将结果输出。这种方式的优势在于可以并行处理,避免了网络瓶颈,并且缩短了处理时间。

一个典型的Map Side Join的流程如下:

1. 预处理阶段:将需要join的小数据集加载到内存中(通常是广播到所有节点的内存中)。

2. Map任务执行:对于大数据集中的每个key-value对,Map任务并行地在内存中的小数据集里查询对应的key,并进行join操作。

3. 输出结果:Map任务将join后的结果输出。

在Hadoop生态系统中,Map Side Join的一个常用场景是在Hive中通过Map Join实现表的join操作。

```java

// 示例:Hive中Map Join的简单SQL语句

SELECT /*+ MAPJOIN(small_table) */ a.key, a.value, b.other_column

FROM big_table a

JOIN small_table b

ON a.key = b.key;

```

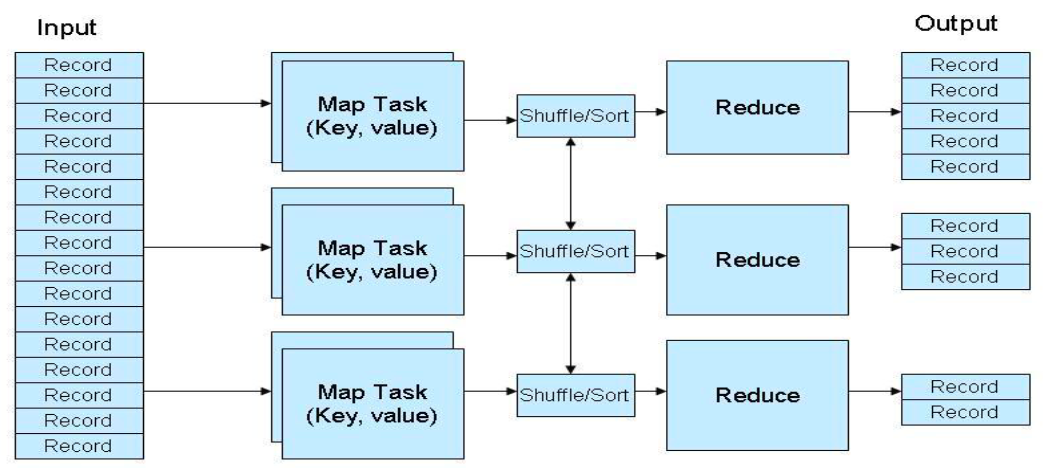

#### 2.1.2 与Reduce Side Join的对比分析

与Map Side Join相对应的是Reduce Side Join,它是一种更为传统的join方法,通常用于不满足Map Side Join条件的场景,比如两个大数据集之间的join操作。Reduce Side Join的工作流程包含以下几个步骤:

1. Map任务执行:每个Map任务处理输入的数据集,将key-value对按键进行分区和排序。

2. Shuffle阶段:Map任务的输出通过网络传输到Reducer节点,并按键进行分组。

3. Reduce任务执行:Reducer接收到相同key的所有value,执行join操作,并输出最终结果。

通过对比可以看出,Map Side Join与Reduce Side Join的主要区别在于数据处理的位置和网络传输的需求。Map Side Join不需要网络传输小数据集,因为它是预先加载到内存中的,而Reduce Side Join则需要Shuffle阶段来传输和分组数据。因此,Map Side Join在性能上往往优于Reduce Side Join,特别是在处理大数据集和小数据集join的场景中。

### 2.2 Map Side Join的关键技术

#### 2.2.1 分布式文件系统中的数据分布

分布式文件系统(如HDFS)是Map Side Join能够高效执行的关键。在这种文件系统中,数据被切分成多个块(block),并分布存储在集群的不同节点上。每个数据块都通过冗余复制来确保高可用性和容错性。这种数据分布对于Map Side Join来说,可以利用数据本地性原理,即尽可能地在数据所在的节点上执行计算任务,从而降低数据传输的开销。

为了实现Map Side Join,分布式文件系统需要保证数据能够均匀分布,避免数据倾斜。数据倾斜是指在Map任务中,部分节点处理的数据量远大于其他节点,导致计算资源分配不均。这会导致Map Side Join的性能优势被抵消,因为一部分节点可能因为数据量过大而成为瓶颈。

为了优化数据分布,可以采用数据预处理手段,比如数据分桶(bucketing)技术,将数据集分成多个桶,每个桶通过某个属性值进行哈希,以保证在join操作时,相同桶内的数据能够在同一个节点上进行处理。

#### 2.2.2 Map Side Join的适用场景

Map Side Join最适合的场景是大数据集与小数据集的join操作。小数据集可以被高效地广播到每个节点的内存中,避免了Shuffle阶段的数据传输。此外,小数据集的更新频率通常较低,保证了广播后的数据在一段时间内是稳定的,减少了广播的成本。

在实际应用中,Map Side Join的适用性受到以下因素的限制:

1. 数据量限制:小数据集必须足够小,以至于可以被完全加载到每个节点的内存中。

2. 更新频率:小数据集更新频率不能太高,否则频繁的广播会导致资源浪费和性能下降。

3. 数据一致性:对于要求实时一致性join操作,Map Side Join可能不太适用,因为小数据集可能无法及时更新。

此外,数据的预处理和清洗也是Map Side Join成功实施的重要环节。数据需要被正确地划分和预处理,以确保join操作的准确性。

### 2.3 Map Side Join的优势探讨

#### 2.3.1 性能优化的理论基础

在大数据处理中,性能优化的核心目标是减少数据处理时间和提高资源利用效率。Map Side Join通过减少数据传输量和避免Shuffle阶段,有效地提升了性能。其理论基础可以从以下几个方面进行分析:

1. **I/O优化**:Map Side Join减少了磁盘I/O和网络I/O的次数。在大数据环境下,I/O操作往往是性能瓶颈,通过在内存中完成join操作,极大地提升了处理速度。

2. **网络带宽优化**:通过避免Shuffle阶段,Map Side Join减少了对网络带宽的需求。在网络带宽受限的环境中,这一点尤为重要。

3. **并行计算优化**:Map Side Join允许数据集并行处理,充分利用集群的计算资源,实现了线性的扩展性。

4. **延迟优化**:由于数据传输量的减少,延迟也得到了显著降低,这对于实时数据处理场景尤为重要。

#### 2.3.2 大数据处理中的实际优势

Map Side Join在实际的大数据处理场景中具有明显的优势。以下是Map Side Join在实际应用中的一些优势:

1. **处理速度**:在大数据集与小数据集join的场景中,Map Side Join可以显著提升处理速度。例如,在大数据分析和报告生成中,Map Side Join可以加速报告的生成时间,使数据分析师能够更快地获取洞察。

2. **资源利用效率**:通过减少不必要的数据传输,Map Side Join在资源利用效率上更加高效,尤其是在CPU和网络资源的使用上。

3. **稳定性提升**:在稳定的数据环境中,一旦小数据集被加载到内存中,就可以在多次Map Side Join任务中重复使用,避免了在每次join操作时重新加载数据,从而提升了整体稳定性。

4. **系统扩展性**:Map Side Join的性能优势在系统扩展时更加明显。当数据量成倍增长时,由于其避免了Shuffle阶段,处理速度的下降通常小于传统join方法。

综上所述,Map Side Join为大数据处理带来了实际的性能和效率提升,特别是在处理大数据集与小数据集join的场景下。然而,为了充分利用Map Side Join的优势,需要充分理解其适用场景和限制,并在实际应用中进行适当的数据预处理和系统配置。

# 3. Map Side Join实践应用

## 3.1 实战准备:环境搭建与数据准备

### 3.1.1 选择合适的大数据处理框架

在进行Map Side Join的实践应用之前,选择一个合适的大数据处理框架是至关重要的步骤。当前流行的大数据框架包括Apache Hadoop、Apache Spark等,每个框架都有其独特的特点和适用场景。

Apache Hadoop的MapReduce编程模型非常适合于处理大规模数据集,提供了高度的可扩展性和容错能力,适用于批处理操作。而Apache Spark以其强大的内存计算能力、简洁的API和高效的处理速度,更适合于需要迭代计算的场景,以及需要快速进行数

0

0