Map Side Join在实时数据处理中的应用:即时分析的优势

发布时间: 2024-10-31 14:13:32 阅读量: 35 订阅数: 36

19、Join操作map side join 和 reduce side join

# 1. Map Side Join简介及原理

## 1.1 Map Side Join的定义

Map Side Join是一种分布式计算中的优化技术,它允许在Map阶段就完成数据的连接操作,这在处理大量数据时可以显著提升效率。在传统的MapReduce框架中,数据处理分为Map和Reduce两个阶段,其中Join操作通常在Reduce阶段执行,这有时会受到数据倾斜和网络传输开销的影响,导致效率低下。通过Map Side Join,可以在读取输入数据时就进行连接,减少不必要的Shuffle过程,从而加快数据处理速度。

## 1.2 Map Side Join的工作原理

Map Side Join的核心思想是利用内存来缓存较小的数据集,从而避免Shuffle过程。在数据读入Map阶段时,如果数据集比较小,可以将其全部加载到内存中,而数据流中的每条记录都会与内存中数据集进行匹配,完成Join操作。这种方法特别适合于其中一个数据集远小于另一个数据集的场景,因为它减少了需要在Map阶段进行数据交换的数据量。

```java

// 伪代码示例

map(key, value) {

// 加载较小的数据集到内存

loadSmallerDatasetToMemory()

for each key, value pair in input {

// 将内存中的数据集与输入数据进行Join操作

join(value, memoryDataset)

}

}

```

在下一章节中,我们将探讨实时数据处理与Map Side Join的关联,包括实时数据处理的基本概念以及如何在实时数据流中应用Map Side Join来提升处理速度和优化系统性能。

# 2. 实时数据处理与Map Side Join的关联

## 2.1 实时数据处理的基本概念

### 2.1.1 实时数据处理的定义与特点

实时数据处理指的是系统对于输入数据的处理和分析能够在几乎与数据输入同时发生,其输出结果具有极低的延迟性,确保数据处理的速度与数据产生的速度相匹配。与传统的批量数据处理相比,实时数据处理在数据到达时立即进行处理,而不是等待所有数据收集完毕后进行批量处理。

实时数据处理的特点包括:

- **低延迟**:数据处理和输出之间的时间差极小,通常要求在毫秒到秒级范围内。

- **高吞吐量**:系统能够持续处理高数据流率,确保在大量数据输入时仍能保持稳定性能。

- **可扩展性**:实时数据处理系统需要能够水平扩展,以应对数据流量的增加。

- **容错性**:系统设计应具备高容错性,能够应对组件故障而不影响整体数据处理流程。

### 2.1.2 实时数据流的捕获与传输技术

为了实现高效的实时数据处理,需要高效的机制来捕获和传输数据流。这一过程通常涉及以下技术:

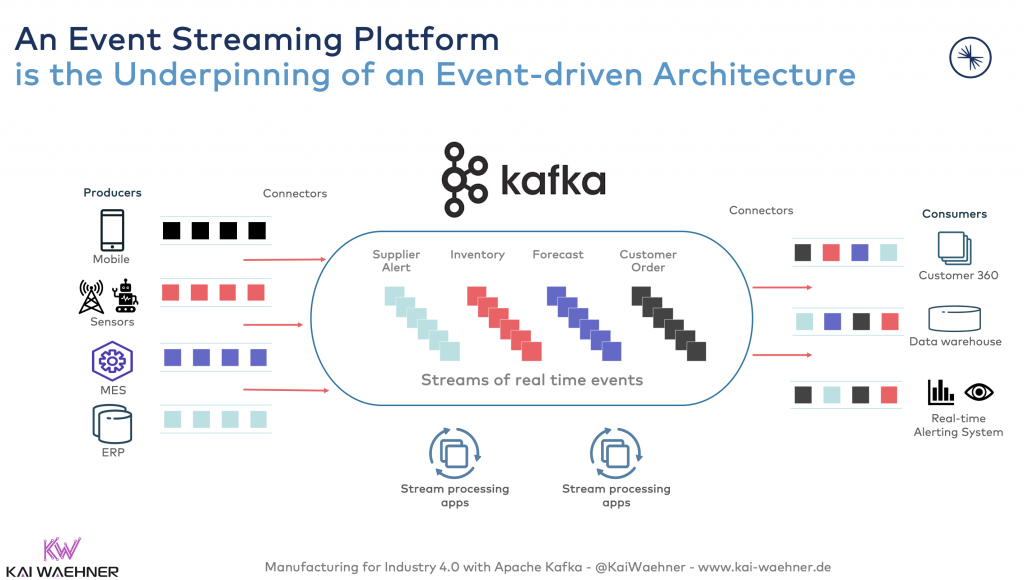

- **消息队列**:使用如Kafka、RabbitMQ等消息队列,允许生产者发布消息到队列中,消费者可以从队列中读取消息进行处理。这种机制有助于解耦数据生产和数据消费过程,并且可以缓冲数据流,平衡负载。

- **数据流处理框架**:例如Apache Storm、Apache Flink和Apache Samza等,这些框架专门设计用来处理实时数据流,提供流式计算功能。

- **流数据传输协议**:如Apache Kafka的Kafka协议、Google的Pub/Sub等,支持高效的数据流传输。

## 2.2 Map Side Join的工作机制

### 2.2.1 Map Side Join的执行流程

Map Side Join是在Map阶段完成数据的Join操作,相比传统的MapReduce模式,在Reduce阶段进行Join可以大幅减少数据的传输量,提高处理速度。以下是Map Side Join执行的基本流程:

1. **预处理**:在Map Side Join开始之前,需要确保所有要Join的数据集都在Hadoop的文件系统HDFS上。对于需要Join的表,通常需要将其中的一个表复制到各个节点上,这样每个节点在Map阶段就可以直接访问到。

2. **数据读取**:Map任务开始时,从HDFS读取数据。其中,主表直接从HDFS读取,而需要复制的表则在Map任务启动时从HDFS复制到本地文件系统。

3. **数据缓存**:Map任务将复制的表加载到内存中。对于大型数据集,也可以使用磁盘或分布式缓存机制,比如Hadoop的`DistributedCache`。

4. **Join操作**:Map任务读取主表中的记录,并使用内存中的数据与之进行Join操作。

5. **输出结果**:执行完Join操作后,将结果输出到HDFS上。

### 2.2.2 与Reduce Side Join的对比分析

与Map Side Join相比,Reduce Side Join在执行时的数据流处理有明显的差异。在Reduce Side Join中,所有的Map任务输出的数据都会被发送到Reduce任务,这导致了大量数据在集群中移动,增加了网络负载和磁盘I/O,从而影响整体性能。

Map Side Join的优势在于:

- **减少数据传输**:由于在Map阶段就完成了数据的合并,避免了大量数据在集群节点间移动。

- **提高处理速度**:减少了数据在网络中的传输时间,加快了整体处理速度。

- **减轻网络和I/O压力**:避免了数据在Reduce阶段的大量传输,减轻了集群的网络和I/O的压力。

然而,Map Side Join也有局限性,比如需要大量内存来存储数据,如果数据集太大,则可能不适合使用Map Side Join。此外,Map Side Join更适合于两个数据集之间存在一定的大小差异,较小的数据集适合复制到每个节点上进行Join操作。

## 2.3 实时数据处理中的Map Side Join优势

### 2.3.1 优化数据处理速度的方法

实时数据处理的场景下,使用Map Side Join可以极大地优化数据处理速度,其核心在于将数据处理前移至Map阶段,避免了数据在网络中的传输和在Reduce阶段的处理。以下是一些优化数据处理速度的方法:

- **数据预处理**:在实时数据处理之前,对数据进行适当的预处理,例如数据清洗和格式化,可以确保Map Side Join操作时减少处理时间。

- **使用高效的Map Side Join策略**:例如在Hadoop环境中,利用`DistributedCache`来缓存小的数据集,或者使用Map Join优化器。

- **并行处理优化**:合理设计并行处理的Map任务数量,利用资源调度器进行资源合理分配。

### 2.3.2 减少系统开销的策略

实时数据处理系统往往资源有限,减少系统开销对于提升处理效率至关重要。Map Side Join通过在Map阶段完成所有操作,减少了对集群资源的需求,特别是减少了对网络和磁盘I/O的依赖。除此之外,以下是一些减少系统开销的策略:

- **内存管理**:优化内存使用,确保内存被高效利用,避免内存溢出或不合理的内存浪费。

- **缓存优化**:合理利用缓存,确保频繁访问的数据能够缓存于快速访问的内存中,减少对磁盘的依赖。

- **任务分配**:合理规划任务分配,避免资源竞争,确保Map任务均匀分配到各个节点上,避免数据倾斜和资源浪费。

在下一章节,我们将深入了解Map Side Join的理论基础和它在分布式计算框架中的应用。

# 3. Map Side Join的理论基础

在深入探讨Map Side Join的理论基础之前,需要对分布式计算框架有所了解。这为理解Map Side Join提供了一个技术背景和理论支持。接着,将讨论Map Side Join在分布式计算环境下的理论模型以及在实践中可能遇到的理论限制。

## 3.1 分布式计算框架简述

### 3.1.1 Hadoop架构及其组件

Hadoop是一个开源的分布式存储和计算框架,它允许用户存储和处理大规模数据集。Hadoop的主要组件包括:

- **HDFS(Hadoop Distributed File System)**:负责存储数据,它可以跨多个物理机器分发数据,保证了数据的高可靠性和高容错性。

- **MapReduce**:这是一种编程模型,用于在Hadoop上进行大规模数据处理。MapReduce的流程包括Map阶段和Reduce阶段,它允许开发者编写Map函数处理输入数据,然后Reduce函数将结果合并。

- **YARN(Yet Another Resource Negotiator)**:YARN是资源管理和作业调度的核心组件,它允许Hadoop集群同时运行多种任务和应用。

### 3.1.2 MapReduce模型的工作原理

MapReduce模型遵循两个主要阶段:Map阶段和Reduce阶段。

- **Map阶段**:这一阶段将输入

0

0