Map Side Join与外部数据整合:高效整合的策略与实践

发布时间: 2024-10-31 14:31:40 阅读量: 48 订阅数: 28

19、Join操作map side join 和 reduce side join

# 1. Map Side Join 的原理和优势

在分布式计算领域,Map Side Join 是一种优化技术,它在 Map 阶段完成数据的合并,从而避免了 Shuffle 过程中的大量数据传输。这种技术特别适用于处理具有相同键值对的小数据集和大数据集的连接操作,能够显著提升执行效率。

## Map Side Join 的工作原理

Map Side Join 通常通过预加载一个小的数据集到每个 Map 任务的内存中实现。Map 任务在处理大数据集时,直接与内存中的数据集进行连接操作。由于不需要将数据发送到 Reducer 阶段,Map Side Join 从而减少了网络I/O开销和磁盘I/O开销,大幅度提升了处理速度。

## Map Side Join 的优势

相对于传统的 Shuffle-based Join,Map Side Join 有以下几个明显优势:

- **减少网络传输**:避免了数据在网络中的传输,降低了延迟。

- **提升运算效率**:由于没有复杂的Shuffle过程,整体运算时间被缩短。

- **优化资源利用**:减轻了网络和磁盘的I/O压力,提高了集群资源的利用率。

接下来,我们将深入探讨外部数据整合的基础知识,并分析如何在复杂的数据环境中,利用Map Side Join实现高效的外部数据整合。

# 2. 外部数据整合的基础知识

### 2.1 外部数据源的分类和特点

外部数据源的分类和特点对数据整合流程的理解至关重要。我们需要明确结构化、半结构化和非结构化数据源之间的区别,以及它们各自的特点。

#### 2.1.1 结构化数据源

结构化数据源是指数据存储在一个预先定义好的模型中,通常是行和列的表格形式。这些数据通常存储在关系型数据库管理系统中,如MySQL、Oracle或SQL Server。由于其高度规范化的格式,结构化数据源便于查询和分析,但其灵活性较弱,很难容纳非标准格式的数据。

```sql

-- 一个简单的SQL查询例子,假设我们要从结构化数据库中查询客户数据:

SELECT * FROM customers WHERE age > 18;

```

这个查询检索所有年龄超过18岁的客户的记录。注意,结构化查询语言(SQL)为我们提供了精确控制数据获取的能力。

#### 2.1.2 半结构化和非结构化数据源

半结构化数据没有严格的模型定义,但内部包含有关数据如何组织的标记信息。典型的例子包括XML和JSON文件。非结构化数据则是完全无格式的,如文本、图片、音频和视频等。这些数据通常存放在NoSQL数据库或者文件系统中。

```json

// 一个JSON格式的示例,展示了半结构化数据的特点:

{

"name": "John Doe",

"email": "john.***",

"contact": {

"address": "123 Main St",

"phone": "+***"

}

}

```

半结构化数据通过标记(如JSON中的键值对)来描述数据的结构,而无需预先定义模式。

### 2.2 数据整合的常见方法

在了解了数据源类型后,我们讨论如何将这些不同类型的外部数据源整合在一起。数据整合常见方法包括使用数据仓库和ETL、实时数据流处理和分布式文件系统整合。

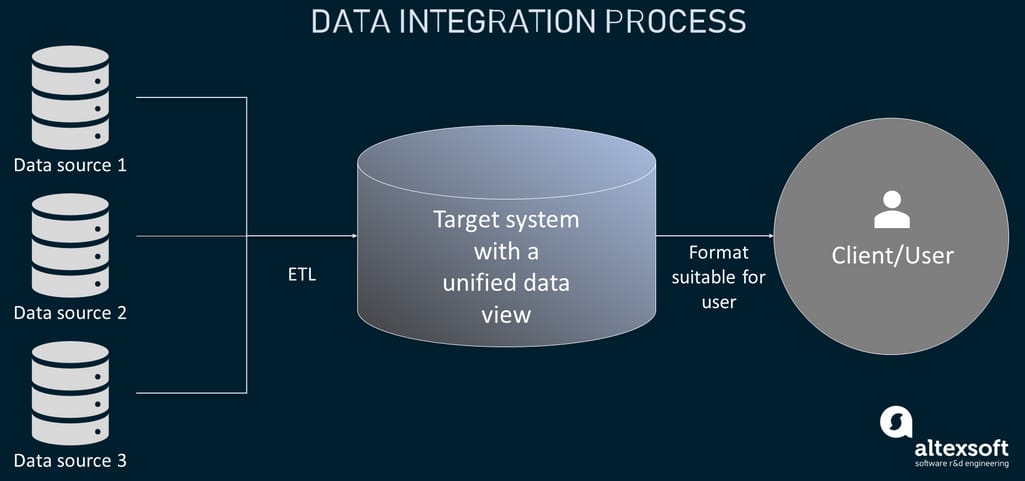

#### 2.2.1 数据仓库和ETL

数据仓库是一种技术,用于将来自不同源的数据集中和整合到一个中心位置进行分析。ETL(提取、转换、加载)是数据仓库的核心过程,涉及将数据从源系统中提取出来,转换成适合分析的格式,然后加载到数据仓库中。

```mermaid

graph LR

A[源数据] -->|提取| B[ETL过程]

B -->|转换| C[数据仓库]

C -->|分析| D[报告和决策]

```

#### 2.2.2 实时数据流处理

实时数据流处理涉及在数据生成的同时对其进行处理和分析。这种处理方式要求高度的可扩展性和低延迟,通常用于需要即时响应的场景。

```mermaid

graph LR

A[数据源] -->|实时流| B[流处理引擎]

B -->|分析结果| C[输出/响应]

```

#### 2.2.3 分布式文件系统整合

分布式文件系统如HDFS或云存储服务,能够存储和整合大规模的数据集。它们常用于整合大量非结构化或半结构化数据,并为数据处理提供存储基础。

```markdown

- HDFS的高容错性和水平扩展能力使其成为大规模数据处理的理想选择。

- 在分布式文件系统中整合数据通常涉及数据的上传、存储管理和数据访问优化。

```

### 2.3 数据整合的挑战与对策

整合不同类型的外部数据源时会面临多种挑战。我们讨论数据一致性、安全和隐私保护以及整合效率的优化策略。

#### 2.3.1 数据一致性问题

数据一致性问题是数据整合的常见挑战之一。要解决这一问题,可以采取多种策略,包括数据同步、版本控制和冲突解决机制。

```markdown

- 数据同步可以确保数据在多个源和目标之间保持最新状态。

- 版本控制有助于跟踪数据变更历史,并在必要时恢复到先前状态。

- 冲突解决机制则是在数据同步过程中处理数据差异的关键。

```

#### 2.3.2 数据安全和隐私保护

在整合数据时,保护数据安全和遵守隐私法规是非常重要的。这通常包括数据加密、访问控制列表(ACL)和数据匿名化等技术。

```markdown

- 数据加密能够保证数据在传输和存储过程中的安全性。

- ACL有助于限制对敏感数据的访问,确保只有授权用户可以访问。

- 数据匿名化是处理个人隐私数据时的一个重要手段,例如通过脱敏处理敏感信息。

```

#### 2.3.3 整合效率的优化策略

为了提高数据整合的效率,可以通过多种策略优化整合过程。包括数据预处理、批处理和流处理的合理选择、以及性能监控和调整。

```markdown

- 数据预处理可以提高整合效率,通过清洗和转换提升数据质量。

- 批处理适合处理大规模数据集,而流处理则适合实时数据分析。

- 性能监控有助于了解整合过程中的瓶颈,从而对

```

0

0