【减少数据溢写】:深入探索MapReduce Shuffle的Spill优化技术

发布时间: 2024-10-30 21:32:29 阅读量: 33 订阅数: 34

电信数据清洗案例:基于MapReduce框架的数据预处理方法

# 1. MapReduce Shuffle机制解析

MapReduce Shuffle是大数据处理中一个非常核心的概念,它负责在Map阶段和Reduce阶段之间传输数据。理解其机制对于优化Hadoop作业性能至关重要。Shuffle过程涉及到数据的排序、合并和传输,它保证了数据在从Map端到Reduce端的传输过程中是有序且高效的。

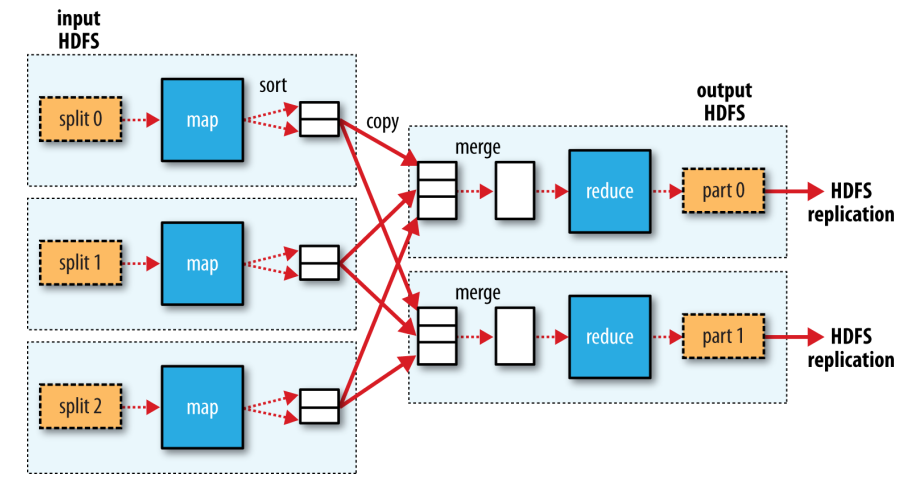

## 1.1 Shuffle流程的基本概念

Shuffle过程可以分为两个主要阶段:Map端的数据处理和Reduce端的数据接收。在Map端,处理过的数据会经过初步排序后写入磁盘。在Reduce端,数据通过网络传输,排序合并后再交由Reduce函数处理。

## 1.2 Shuffle机制的重要性

Shuffle的效率直接影响到整个MapReduce作业的性能。如果Shuffle阶段执行得当,可以显著减少不必要的磁盘I/O操作,降低网络传输压力,并且提升数据处理速度。因此,深入分析并优化Shuffle流程是大数据优化中的一个关键步骤。

# 2. Shuffle阶段数据溢写原理

## 2.1 Shuffle流程概览

### 2.1.1 Map阶段的数据处理

MapReduce的Map阶段是Shuffle过程的起点,它负责读取输入数据并进行处理。Map任务通常会涉及到数据的读取、解析、过滤、映射和局部聚合等操作。每个Map任务会处理输入数据的一部分,并将结果输出到一个内存缓冲区中。这一阶段对性能优化至关重要,因为它直接影响到数据传输到Reduce阶段的效率。

在Map阶段,开发者可以采用一些策略来优化数据处理过程。例如,可以在Map阶段加入数据过滤逻辑,仅保留对后续计算有用的数据字段,减少数据在网络传输和磁盘I/O上的开销。此外,Map函数可以实现局部聚合,减少Shuffle阶段需要传输的数据量。

### 2.1.2 Reduce阶段的数据接收

Reduce阶段开始于Map阶段输出的数据经过Shuffle传输到各个Reduce任务。在Reduce阶段,数据会根据键值进行排序和分组,每个Reduce任务处理一组具有相同键值的数据。在这一过程中,系统会先将数据写入磁盘,再读取进行排序和分组。

Reduce任务会从所有的Map任务中拉取数据,这一步骤称为Shuffle。为了平衡网络负载,Map任务输出的数据会被分片存储,因此Reduce任务需要从多个Map任务中拉取数据。数据的这一拉取过程对最终性能有着极大影响,通常需要对数据分片的大小和网络传输性能进行优化。

## 2.2 数据溢写前的缓冲机制

### 2.2.1 内存缓冲与磁盘缓冲的区别

在MapReduce框架中,Map任务输出的数据首先被存储在内存缓冲区中。当内存缓冲区中的数据量达到一定阈值时,这些数据会被写入磁盘中以释放内存空间。这个过程被称为溢写(Spill)。

内存缓冲机制利用快速的内存访问速度,可以快速地处理数据。但当数据量过大,超出内存缓冲区的容量时,必须将部分数据溢写到磁盘上。磁盘缓冲区一般比内存缓冲区要大,但写入速度较慢。通过合理配置内存和磁盘缓冲区的大小,可以实现内存和磁盘之间的平衡,保证数据处理效率。

### 2.2.2 缓冲区大小对性能的影响

缓冲区大小是影响MapReduce作业性能的关键因素之一。如果缓冲区设置过小,会导致频繁的溢写操作,过多的磁盘I/O将影响作业的整体性能。相反,如果缓冲区设置过大,则可能会导致内存溢出,甚至影响到作业运行时的稳定性。

优化策略包括动态调整缓冲区大小,以适应不同的工作负载。一些框架支持根据历史数据流的大小自动调整缓冲区大小,这可以作为提高整体性能的手段。此外,某些时候通过增加节点的内存资源,可以允许更大的缓冲区,从而减少磁盘的I/O操作。

## 2.3 溢写触发条件分析

### 2.3.1 内存溢写触发阈值

内存溢写触发阈值是当内存缓冲区中数据量达到此阈值时,系统会启动溢写过程。这一阈值是由MapReduce框架的配置参数决定的,通常有一个默认值,但是根据不同的工作负载,开发者可以调整这一阈值。

调整内存溢写阈值需要权衡内存使用和磁盘I/O开销。如果设置得太高,虽然可以减少溢写次数,但也可能导致内存不足,引发频繁的垃圾回收(GC),从而影响Map任务的执行速度。如果设置得太低,会增加溢写次数,增加磁盘的I/O消耗。

### 2.3.2 磁盘溢写触发策略

磁盘溢写触发策略是指当数据溢写到磁盘时采取的具体策略。策略的制定往往依赖于Map任务的进度和缓冲区的使用情况。当Map任务即将完成时,系统会开始执行磁盘溢写,确保所有数据都准备好传输给Reduce任务。

磁盘溢写策略的优化通常包括调整溢写数据的块大小和数据的整理方式。通过调整这些参数,可以减少磁盘I/O操作的次数,提高溢写效率。例如,可以采用异步I/O操作,使多个溢写操作并行执行,提高磁盘使用率。

本章的第二部分将深入探讨数据溢写前的缓冲机制,以及如何通过配置和调整相关参数来优化这一过程,从而提升整体的MapReduce作业性能。接下来的内容将详细解释内存缓冲区与磁盘缓冲区的不同作用、对性能的影响,以及溢写触发条件的分析,为读者提供Shuffle过程优化的具体实施策略。

# 3. Shuffle Spill优化技术

## 3.1 基础Spill优化技术

### 3.1.1 数据压缩

在分布式计算中,网络带宽往往是瓶颈,尤其是在处理大规模数据时。通过压缩数据,可以显著减少网络传输和磁盘I/O的数据量,从而提升整体Shuffle性能。常见的数据压缩算法有LZ4、Snappy和Deflate等,它们通过各种算法压缩数据以减小其大小,但也引入了额外的CPU开销来执行压缩和解压缩操作。优化选择依赖于数据的特点和计算集群的硬件能力。

**示例代码块:**

```python

# 示例:使用Snappy压缩算法进行数据压缩

import snappy

# 假设data是需要压缩的数据块

data = b"This is the original data block"

compressed_data = ***press(data)

# 检查压缩后的数据大小

print(f"Original size: {len(data)} bytes")

print(f"Compressed size: {len(compressed_data)} bytes")

# 在Shuffle过程中,应当在溢写磁盘之前进行数据压缩

```

在上述代码中,我们导入了Python的`snappy`模块,并演示了如何将原始数据块压缩。压缩数据的大小会小于原始数据大小,节省了磁盘和网络资源。值得注意的是,压缩和解

0

0