【网络通信优化】:如何通过MapReduce Shuffle提升大数据处理速度

发布时间: 2024-10-30 21:15:51 阅读量: 3 订阅数: 13

# 1. 网络通信优化的基本原理

## 1.1 网络通信优化的重要性

在大数据处理中,网络通信优化是提升数据处理效率、保障数据稳定传输的关键。优秀的网络通信优化不仅能降低延迟,还能提升吞吐量,对于确保大数据处理的高效性至关重要。通信优化涉及数据传输的各个环节,包括数据传输协议的选择、网络路径的规划、以及数据流的管理等。

## 1.2 网络通信优化的基本策略

优化网络通信主要围绕三个层面展开:首先是协议层面,包括选择合适的传输协议和对协议进行参数调整;其次是硬件层面,比如使用高速网络硬件和进行网络结构优化;最后是软件层面,涉及软件内部逻辑优化和算法调整。通过这些策略的综合运用,可以实现通信资源的合理配置和效率最大化。

## 1.3 从经典案例学习优化策略

深入研究一些经典的网络通信优化案例,如Google的Spanner系统和Apache Hadoop生态中的MapReduce,可以发现,这些系统在设计之初就考虑了通信优化的需求,并在后续的发展中不断迭代更新,以适应不断增长的性能要求。总结这些案例的共性,有助于我们更好地理解网络通信优化的原理和应用。

# 2. MapReduce Shuffle机制详解

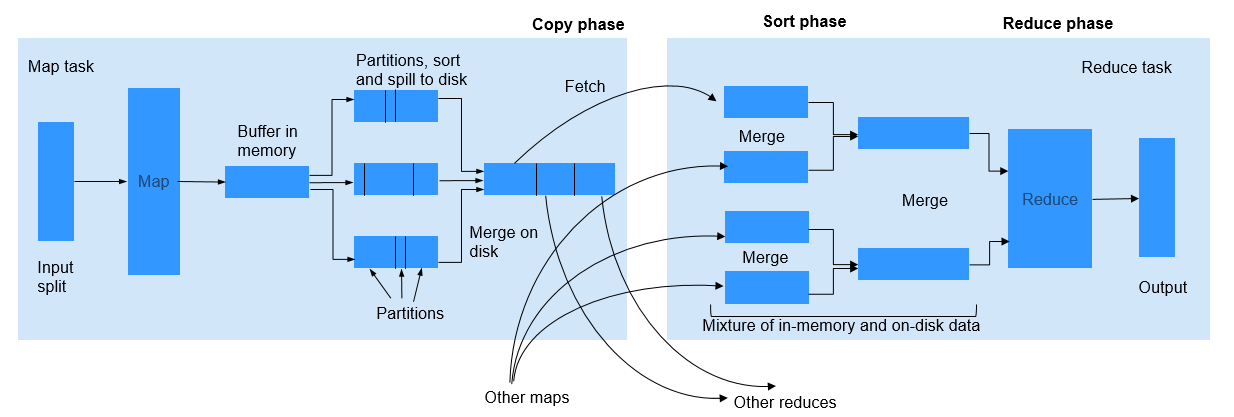

MapReduce编程模型的核心在于如何高效地处理和分析大规模数据集。Shuffle过程是MapReduce框架中最为关键的环节之一,它负责将Map任务的输出数据安全、有序地传输到Reduce任务。为了深入理解并优化Shuffle过程,本章将对Shuffle机制的运行流程、关键组件的作用以及性能优化策略进行详细分析。

## 2.1 MapReduce Shuffle的运行流程

### 2.1.1 Map阶段的Shuffle过程

Map阶段Shuffle的起点是Map任务对输入数据集的处理。Map任务通常会读取HDFS中的数据块,执行自定义的Map函数对数据进行处理,并输出键值对(key-value pairs)。在这个过程中,Shuffle的主要任务是将所有Map任务输出的键值对进行分区、排序,并准备发送给对应的Reduce任务。

**键值对分区**:Map任务输出的键值对首先经过Partitioner组件,根据key的值进行分区,确保相同key的键值对会发送到同一个Reduce任务中。Partitioner的选择通常依赖于MapReduce作业的具体需求,系统默认使用哈希分区器。

**局部排序**:分区后的键值对会进行局部排序,也就是对每个分区内的数据按键进行排序。这一过程是在Map端完成的,它有助于降低网络传输压力,因为只需要传输排序后的数据。

### 2.1.2 Reduce阶段的Shuffle过程

当所有Map任务完成之后,Shuffle过程进入Reduce阶段。Reduce阶段的工作开始于拉取各个Map任务输出的数据。Shuffle的主要任务是在Reduce任务开始执行之前,将所有必要的数据拉取到本地,并进行合并排序,然后输入给Reduce函数进行处理。

**数据拉取(Fetch)**:Reduce任务启动时,首先确定自己需要拉取数据的Map任务列表,然后通过RPC调用从这些Map任务中拉取数据。这一步骤需要高效地完成,避免网络带宽成为瓶颈。

**合并排序(Merge-Sort)**:从各个Map任务拉取的数据首先被存储到Reduce任务节点的磁盘上,接着进行合并排序,确保所有数据按键有序。这是整个Shuffle过程中最耗时的一步,特别是当数据量非常大时。

## 2.2 Shuffle过程中关键组件的作用

### 2.2.1 Combiner的功能与优化

Combiner组件在Shuffle过程中是一个可选步骤,它的主要作用是在Map阶段对中间数据进行局部合并,以减少数据量和网络传输。Combiner函数与Reduce函数通常执行相同的操作,但仅作用于Map任务的输出。

**Combiner优化**:使用Combiner可以显著提高MapReduce作业的性能。尤其是在数据倾斜的情况下,Combiner可以减少网络传输的数据量,但需要注意的是,不是所有MapReduce作业都适合使用Combiner。Combiner的使用取决于作业的特性,比如是否满足交换律和结合律。

### 2.2.2 Partitioner的定制与性能影响

Partitioner组件负责将Map任务的输出按键进行分区,以便所有相同键值对的数据会被发送到同一个Reduce任务进行处理。

**定制Partitioner**:在一些复杂的数据处理场景中,可能需要定制Partitioner来优化性能。例如,在进行Top N问题求解时,可以设计特定的Partitioner,将Top N的数据发送到同一个Reduce任务中,从而减少Reduce阶段的数据量。

### 2.2.3 Sort和Merge的内部机制

排序(Sort)和合并(Merge)是Shuffle过程中的核心机制之一,它们负责在Map端进行局部排序,在Reduce端进行全局合并排序。

**Sort机制**:排序操作确保了在Shuffle过程中,相同key的键值对被紧密排列在一起,为之后的数据传输和处理奠定了基础。

**Merge机制**:合并操作则在Reduce端将来自不同Map任务的数据有序合并在一起,为Reduce函数提供输入。这一过程通常涉及内存和磁盘的交互,需要精心设计算法来平衡效率和资源使用。

## 2.3 Shuffle性能优化策略

### 2.3.1 缓存机制的优化

在MapReduce中,缓存机制可以用来优化数据处理性能。利用作业配置,开发者可以指定需要缓存到每个Map任务节点的文件或数据集,这使得Map任务可以直接访问这些数据,减少了从HDFS读取的开销。

### 2.3.2 网络带宽的合理配置

网络带宽是Shuffle过程中的另一个瓶颈,优化网络配置可以显著提升大数据处理效率。合理分配带宽资源,例如采用优先级队列等技术,可以确保关键任务的网络传输不受其他任务干扰。

### 2.3.3 硬件资源的充分利用

硬件资源的优化利用也是性能提升的关键。例如,通过优化HDFS的数据块大小,可以减少Map任务读取数据时的开销;而合理配置CPU核心和内存,可以提升Map和Reduce任务的处理速度。

以上为第二章的核心内容。在后续的章节中,我们将探讨如何通过具体的操作来提升Shuffle过程的效率,从而加速大数据处理,以及如何在实际应用中应用这些优化策略,并评估其效果。

# 3. 优化Shuffle以加速大数据处理

## 3.1 提升Map阶段效率

MapReduce作为大数据处理的关键技术,其性能在很大程度上取决于Map阶段的效率。通过对Map阶段的优化,可以有效减少数据处理的时间和提高计算资源的利用率。以下是几个能够提升Map阶段效率的具体策略。

### 3.1.1 输入数据的优化预处理

在Map阶段开始之前,对输入数据进行预处理可以大幅提高处理速度。预处理步骤包括数据压缩、数据清洗和数据分区。数据压缩能够减少磁盘I/O操作和网络传输的负载;数据清洗能够排除无用数据,减少不必要的处理;而数据分区则能够确保数据分布均匀,防止Map任务执行的倾斜。

预处理的步骤需要细心规划,以确保对后续任务的影响最小。例如,使用Hadoop的CompresssedInputFormat可以进行数据压缩,利用Pig或Hive进行数据清洗和转换,然后通过自定义Partitioner将数据均匀分散到各个Map任务。

### 3.1.2 Map任务的负载均衡

负载均衡在Map阶段同样至关重要,因为不均匀的负载分配会导致Map任务执行时间差异巨大,进而造成整体作业的处理时间延长。负载均衡可以通过多种方式实现,包括但不限于使用自定义的Partitioner来控制数据分片,或者通过MapReduce框架本身的配置参数调整。

例如,可以通过调整`mapreduce.job.reduces`参数来控制Map任务数量,配合`mapreduce.input.lineinputformat.linespermap`参数优化单个Map任务处理的数据量。当Map任务负载不均时,Map任务结束时间差异较大,作业调度器应根据任务执行情况动态调整资源分配。

## 3.2 改善Reduce阶段性能

### 3.2.1 Reduce任务的动态调度

0

0