【磁盘I_O优化技巧】:MapReduce Shuffle阶段性能提升的关键

发布时间: 2024-10-30 21:19:11 阅读量: 6 订阅数: 8

# 1. 磁盘I/O基础与优化概述

在现代IT系统中,磁盘I/O是性能的关键瓶颈之一。磁盘I/O指的是系统中对存储设备的读写操作,包括数据的存取、查询、更新等。因为数据处理速度远远超过磁盘存取速度,所以I/O延迟问题显得尤为突出。本章我们首先介绍磁盘I/O的基本概念,然后阐述优化的基本思路和重要性。

## 1.1 磁盘I/O的基本概念

磁盘I/O即输入/输出操作,是计算机与外部存储设备交换数据的过程。硬盘驱动器(HDD)和固态驱动器(SSD)是最常见的存储介质。HDD依赖于机械运动,有较高延迟;SSD利用闪存技术,速度快,无机械部件,但成本相对较高。

## 1.2 磁盘I/O优化的重要性

优化磁盘I/O可以减少数据处理的延迟,提升系统的整体响应速度。这在大数据处理场景下尤为重要,比如Hadoop的MapReduce框架中的Shuffle阶段。通过合理配置和使用I/O调度算法、选择合适的文件系统,可以显著提高系统性能。

在深入探讨Shuffle阶段及磁盘I/O优化之前,我们需要对这些基础概念有一个全面的理解。这将为后续章节中更复杂和具体的优化方法提供理论支持和指导方向。

# 2. MapReduce Shuffle阶段解析

## 2.1 Shuffle阶段的作用和流程

### 2.1.1 Shuffle阶段的定义和重要性

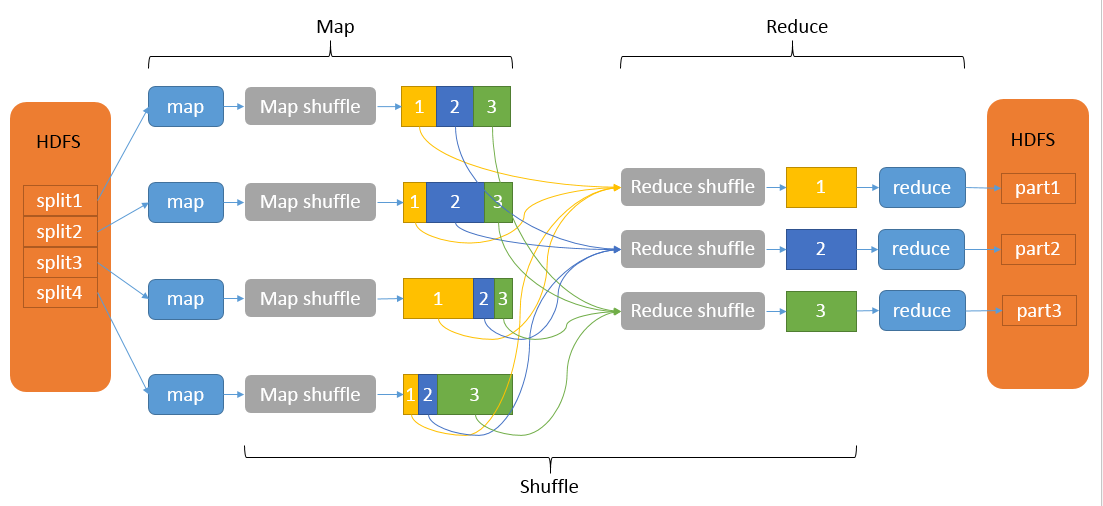

MapReduce作为大数据处理中非常重要的计算框架,其Shuffle阶段起着承前启后的作用。在Map阶段完成后,Shuffle负责收集、排序和分组Map输出的中间数据,以供Reduce阶段进一步处理。Shuffle过程直接影响到整体作业的性能和效率,因为大量的数据传输和计算都在这个阶段完成。

Shuffle阶段的重要性可以从以下几点加以阐述:

- **数据排序**:Shuffle过程对数据进行了排序,这保证了在Reduce阶段同一键值的数据会被发送到同一个Reducer上,从而实现数据的聚合操作。

- **网络带宽**:Shuffle过程决定了网络带宽的使用量。数据的传输量和效率直接影响到整个系统的吞吐量。

- **性能瓶颈**:在许多情况下,Shuffle阶段的性能瓶颈也是MapReduce作业的性能瓶颈。对Shuffle过程进行优化是提高整个作业效率的关键。

### 2.1.2 Shuffle流程的关键步骤

Shuffle流程可以拆分为以下几个关键步骤:

1. **数据分区**:Map函数的输出根据键值进行分区,确保所有相同键的数据被分到同一个分区。

```java

// 伪代码示例:分区过程

int partition(int key) {

return key.hashCode() % numReduceTasks;

}

```

2. **写入本地磁盘**:每个Map任务将数据写入到本地磁盘上的临时文件中。这是为了防止内存溢出,并且为Shuffle过程提供数据源。

3. **执行Shuffle**:这个过程包括从Map任务的输出中读取数据,通过网络发送到Reduce任务,然后在Reduce端进行排序。

4. **归并排序**:在Reduce任务端,Shuffle机制对从不同Map任务中收集来的数据进行归并排序,确保了最终数据的有序性。

## 2.2 Shuffle阶段的性能瓶颈

### 2.2.1 磁盘I/O对性能的影响

磁盘I/O是Shuffle过程中非常关键的因素,它涉及到数据的读写速度和吞吐量。在Map端,如果磁盘I/O性能不足,会导致Map任务的输出写入速度受限,进而影响整个作业的完成时间。在Reduce端,读取磁盘上的Shuffle数据效率低下也会成为瓶颈。

```markdown

| 参数 | 描述 | 影响 |

| --- | --- | --- |

| 磁盘类型 | HDD或SSD | SSD提供更高的I/O吞吐率和更低的延迟 |

| 磁盘数量 | 分布式存储中的磁盘数量 | 更多的磁盘可以提供更高的并行读写能力 |

| 磁盘队列深度 | 磁盘I/O请求队列的深度 | 深度越大,能够处理的并发I/O请求数量越多 |

```

### 2.2.2 网络和CPU资源对性能的影响

除了磁盘I/O之外,Shuffle过程中网络和CPU资源的使用也至关重要。Shuffle的数据传输依赖网络带宽,网络延迟和带宽会直接影响数据传输的效率。同时,CPU资源被用于处理数据的压缩、解压和排序等操作。

```mermaid

graph LR

A(Map任务数据输出) -->|本地磁盘写入| B(Shuffle过程)

B -->|网络传输| C(Reduce任务)

C -->|内存排序| D(磁盘排序)

D --> E(最终输出)

```

CPU资源的优化可以通过调整缓冲区大小、内存管理策略等来实现,从而提高数据处理效率。在网络层面,合理规划网络拓扑结构、优化数据传输协议和路由算法等都可以进一步优化Shuffle过程。

在下一章节中,我们将探讨Shuffle阶段性能瓶颈的优化策略,并展示具体的配置参数调整方法。

# 3. 磁盘I/O性能优化理论

在处理大数据任务时,如MapReduce作业,磁盘I/O性能直接影响整个系统的处理效率。要深入理解磁盘I/O优化,首先需要从理论上构建坚实的基础。本章将探讨磁盘I/O优化的理论基础以及硬件层面的优化策略。

### 3.1 磁盘I/O优化的理论基础

#### 3.1.1 I/O调度算法

磁盘I/O调度算法的核心是组织和管理磁盘请求,以提高读写效率,减少寻道时间。传统调度算法如First-Come First-Served(FCFS)、Shortest Seek Time First(SSTF)、SCAN和LOOK算法等,各有优劣。例如,SCAN算法又称为电梯算法,它将磁盘臂移动方向上的请求合并,减少了磁头移动次数,适合于磁盘负载较重的场景。在Hadoop等大数据处理框架中,调度策略的选择直接关系到数据处理的延迟和吞吐量。

```mermaid

flowchart LR

A[开始] --> B[读写请求到达]

B --> C{选择调度算法}

C -->|FCFS| D[按请求到达顺序处理]

C -->|SSTF| E[选择距离磁头最近的请求]

C -->|SCAN| F[沿一个方向处理所有请求]

C -->|LOOK| G[类似SCAN,但不跨过请求边界]

D --> H[结束]

E --> H

F --> H

G --> H

```

#### 3.1.2 文件系统的选择和优化

不同的文件系统设计有不同的特性,它们对性能的影响也不尽相同。例如,XFS和EXT4等现代文件系统支持大容量存储,提供了更好的日志管理以及更快的处理速度。使用正确的文件系统可以提高数据的读写速度

0

0