【MapReduce Shuffle优化案例研究】:解决实际问题的策略与技巧

发布时间: 2024-10-30 21:35:51 阅读量: 35 订阅数: 33

MapReduce2.0源码分析与实战编程

# 1. MapReduce Shuffle机制解析

## 1.1 Shuffle机制概述

MapReduce模型是分布式计算框架中处理大数据的核心技术之一,而Shuffle过程则是MapReduce任务中的关键阶段。Shuffle主要负责将Map阶段输出的数据进行排序、合并,并传输给Reduce阶段进行处理。它是Map和Reduce两个处理阶段之间的桥梁,直接决定了整个作业的性能和效率。

## 1.2 Shuffle流程

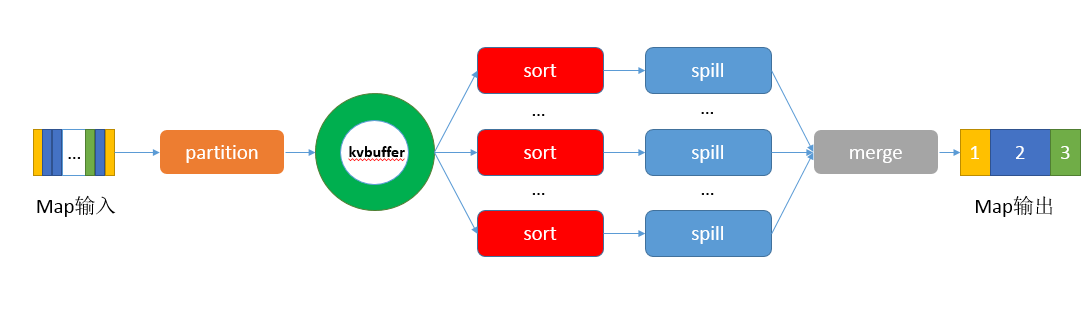

Shuffle过程主要包括以下几个步骤:

- **分区**:根据key的哈希值确定每个key-value对应该发送到哪个Reduce任务。

- **排序**:对每个分区内的数据进行局部排序,通常根据key进行排序。

- **溢写**:将排序后的数据写入磁盘进行持久化存储,以防止数据丢失。

- **合并**:合并多个溢写文件,以减少读取时的I/O次数。

- **传输**:将处理后的数据传输给对应的Reduce任务。

## 1.3 Shuffle的重要性

Shuffle过程不仅需要高效的网络通信和磁盘I/O操作,还要确保数据能够准确无误地传输和处理。一个有效的Shuffle机制能够显著提高数据处理的性能,减少不必要的资源消耗,是实现大数据处理高效作业的关键所在。

```mermaid

flowchart LR

A[Map阶段] -->|分区| B[排序]

B -->|溢写| C[磁盘存储]

C -->|合并| D[传输给Reduce]

D --> E[Reduce阶段]

```

在接下来的章节中,我们将深入探讨Shuffle过程中可能遇到的性能瓶颈,并分析如何优化这些瓶颈以提高大数据处理作业的整体性能。

# 2. Shuffle过程中的性能瓶颈分析

## 2.1 Map阶段的性能瓶颈

### 2.1.1 网络带宽的限制

在MapReduce框架中,Map阶段产生的中间数据需要通过网络传输到Reduce阶段进行处理。在这个过程中,网络带宽成为限制Shuffle性能的一个关键因素。由于网络传输速度有限,尤其是在大规模集群环境下,网络拥塞和带宽不足的问题会严重阻碍数据传输的效率。网络带宽的限制不仅影响数据传输的速度,而且还可能导致Map任务执行时间延长,从而影响整个作业的完成时间。

### 2.1.2 磁盘I/O的瓶颈

Map阶段处理的数据通常来自HDFS等分布式文件系统。在执行Map任务时,Map任务需要从磁盘读取数据,并在处理后将数据写回磁盘。磁盘I/O操作的性能直接影响着Map任务的执行效率。如果磁盘的读写速度跟不上Map任务处理数据的速度,那么磁盘I/O将成为一个性能瓶颈。在某些情况下,Map任务产生的中间数据量可能会非常大,导致磁盘空间不足,进而影响到Shuffle过程的连续性和稳定性。

## 2.2 Reduce阶段的性能瓶颈

### 2.2.1 网络调度与数据传输

Reduce阶段主要负责对来自Map阶段的数据进行汇总和进一步的处理。在这个过程中,Reduce任务需要从网络上拉取所有相关的中间数据。如果网络调度不合理或者数据传输效率低下,那么网络带宽的限制就会成为制约Reduce阶段性能的瓶颈。特别是在数据倾斜的情况下,某些Reduce任务可能会接收到远超平均量的数据,导致网络I/O成为瓶颈,影响整个作业的完成时间。

### 2.2.2 Reduce任务的负载均衡问题

在Reduce阶段,不同的Reduce任务可能会处理的数据量差异很大,这是由于数据倾斜引起的。数据倾斜是指大部分的数据都集中在少数的Reduce任务中,而其他任务则相对空闲。这会导致负载不均衡,有的Reduce任务过载,而有的则空闲,降低了系统的整体处理能力。为了优化性能,需要对数据进行再分配,以实现负载均衡。

## 2.3 中间数据的管理问题

### 2.3.1 中间数据的存储与清理

Map阶段产生的中间数据需要临时存储在磁盘上,直到Reduce阶段拉取完毕。这个过程中,中间数据的存储管理对于Shuffle性能有着直接的影响。如果中间数据没有得到合理管理,可能会导致磁盘空间不足或者读写效率低下。在处理完Shuffle之后,这些中间数据就不再需要,因此及时清理这些临时数据,避免对系统资源的浪费,是非常必要的。

### 2.3.2 中间数据的溢写机制

当Map任务产生的中间数据量超过内存缓冲区大小时,会触发溢写操作,将数据写入磁盘。这个过程中,合理的溢写机制对于保证Map任务的稳定性和数据传输的连续性非常重要。如果溢写操作频繁发生,会大量占用磁盘I/O资源,并可能导致网络传输数据的延迟。因此,合理配置内存缓冲区大小以及优化溢写逻辑,可以有效避免性能瓶颈。

### 示例代码与解释

下面是一个简化的MapReduce作业示例,用于说明Shuffle过程中数据流的处理:

```java

public class SimpleMapReduce {

// Map函数,模拟键值对的生成

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

// Reduce函数,模拟键值对的汇总

public static class IntSumReducer

extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

```

0

0