【Hadoop Sort Merge Join】:步骤优化与性能调优

发布时间: 2024-10-31 07:12:11 阅读量: 26 订阅数: 30

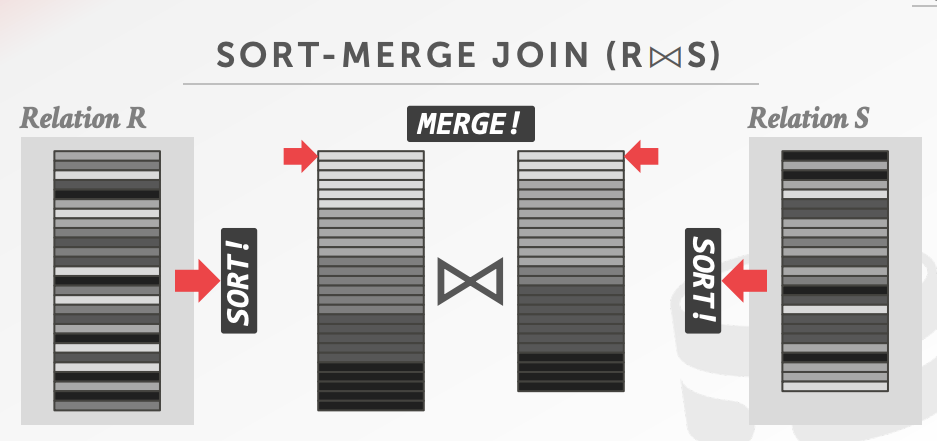

# 1. Hadoop Sort Merge Join简介

Hadoop Sort Merge Join是大数据处理中一种高效的连接操作,它利用了Hadoop的分布式计算能力来处理大规模数据集之间的关系连接。相比于传统数据库中的Join操作,Sort Merge Join在处理PB级别数据时不仅提高了处理速度,还优化了存储和网络I/O消耗。本章节将简要介绍Hadoop Sort Merge Join的基本概念及其在数据处理中的作用,为读者接下来深入探讨其理论基础、优化策略和性能调优奠定基础。

# 2. 理论基础和算法原理

### 2.1 Hadoop分布式计算框架概述

Hadoop是一个开源的分布式存储与计算框架,允许用户以分布式的方式存储大量数据,并且在这些数据上执行计算任务。Hadoop通过MapReduce编程模型来处理和生成大规模数据集,同时它提供了HDFS(Hadoop Distributed File System)作为存储层,以及YARN(Yet Another Resource Negotiator)作为资源管理和作业调度层。

#### 2.1.1 Hadoop核心组件解析

Hadoop的核心组件包括:

- HDFS:Hadoop的文件系统,为分布式存储提供了高吞吐量的数据访问,适合于大数据集的应用。

- MapReduce:一种编程模型和处理大数据集相关联的计算框架。Map阶段处理输入数据,Reduce阶段对结果进行汇总。

- YARN:负责Hadoop集群中的资源管理和任务调度,它提供了一个资源管理层来管理整个集群资源。

#### 2.1.2 Hadoop的工作原理

Hadoop工作原理主要基于以下几个步骤:

1. 数据存储:通过HDFS将数据分片存储在多个节点上,从而实现数据的高可用性和可扩展性。

2. 数据处理:用户通过MapReduce编程模型定义具体的Map和Reduce函数,Hadoop框架负责将这些任务分配到集群的各个节点上执行。

3. 任务调度:YARN根据集群资源和任务需求动态调度资源,保证作业的高效执行。

### 2.2 Sort Merge Join算法机制

#### 2.2.1 算法流程详解

Sort Merge Join是一种在分布式计算中常用的数据连接算法。其基本流程包括:

1. 数据分割:在Map阶段,两个待连接的表根据连接键被分割成若干部分。

2. 局部排序:每部分数据在Map端按照连接键进行局部排序。

3. 数据传输:排序后的数据被传输到Reduce端,通常会根据连接键值进行分区,保证相同键值的数据传输到同一个节点。

4. 数据合并:在Reduce端,按照连接键值对数据进行全局排序,并合并匹配的记录。

#### 2.2.2 算法在Hadoop中的实现

在Hadoop中,Sort Merge Join算法的实现涉及到具体的编程细节:

```java

public class SortMergeJoin {

public static class MapClass extends Mapper<LongWritable, Text, Text, Text> {

public void map(LongWritable key, Text value, Context context) {

// Map函数逻辑,通常包含对输入数据的解析和输出

}

}

public static class ReduceClass extends Reducer<Text, Text, Text, Text> {

public void reduce(Text key, Iterable<Text> values, Context context) {

// Reduce函数逻辑,执行数据合并操作

}

}

}

```

### 2.3 算法性能影响因素分析

#### 2.3.1 数据倾斜问题

数据倾斜是分布式计算中常见的问题,当数据分布不均匀时,某些节点可能需要处理比其他节点更多的数据,导致处理速度不一致,影响整体计算效率。在Sort Merge Join中,数据倾斜可能导致某些Reduce任务压力过大,无法有效利用集群资源。

#### 2.3.2 网络和磁盘I/O瓶颈

网络和磁盘I/O是Hadoop集群性能的主要瓶颈之一。在网络传输大量数据时,尤其是在数据合并和排序阶段,高网络I/O开销会导致性能下降。同样,高磁盘I/O开销也会对性能产生影响,尤其是在数据持久化阶段。

### 第二章小结

在本章中,我们对Hadoop分布式计算框架进行了深入的介绍,并详细解析了Sort Merge Join算法的机制和在Hadoop中的实现过程。同时,我们探讨了影响Sort Merge Join性能的因素,例如数据倾斜和网络与磁盘I/O瓶颈,为后续章节中的性能优化提供了理论基础。随着对Sort Merge Join算法的进一步了解,我们将能在下一章中针对具体场景提出有效的优化策略。

# 3. Sort Merge Join的步骤优化

## 3.1 数据预处理的优化策略

### 3.1.1 数据分区优化

数据分区是Hadoop MapReduce框架中的一个重要概念,它确保Map任务可以并行处理数据,从而提高处理速度。在Sort Merge Join中,数据预处理阶段的分区优化主要是指确保参与join操作的两张表根据相同的键值进行分区,以便在Map阶段将相应的记录分发到同一个Map任务中。

优化数据分区的策略包括:

- **使用自定义分区器**:如果默认的哈希分区器不能满足特定需求,可以创建自定义分区器来确保数据正确分区。

- **预分区**:在数据上传到HDFS之前,先在客户端进行数据分片,这样可以减少Hadoop在Map阶段的计算量。

```java

// 自定义分区器示例代码

public class CustomPartitioner extends Partitioner<Text, Text> {

public int getPartition(Text key, Text value, int numPartitions) {

// 根据键值计算分区号的逻辑

int partition = (key.hashCode() & Integer.MAX_VALUE) % numPartitions;

return partition;

}

}

```

在上述代码中,`CustomPartitioner` 继承自 `Partitioner` 类,并重写了 `getPartition` 方法来实现自定义分区逻辑。这样,在执行MapReduce作业时,Hadoop框架会使用我们自定义的分区逻辑来分配键值对。

### 3.1.2 数据排序的优化

数据排序是确保Sort Merge Join高效执行的关键步骤。由于join操作依赖于有序数据,所以排序可以减少在后续阶段不必要的数据比较和合并操作。

优化数据排序的策略包括:

- **减少Map端排序的开销**:可以通过增加Map任务的输出缓冲区大小来减少数据溢写到磁盘的次数,从而减少排序次数。

- **使用Combiner**:在Map端输出之前使用Combiner可以减少数据传输量,因为Combiner可以在Map端进行局部合并。

```xml

<!-- Hadoop配置示例,开启Combiner -->

<property>

<name>mapreduce.job.mapoutputcombiner.class</name>

<value>***positeJoin$CompositeJoinCombiner</value>

</property>

```

在上述配置中,通过设置`mapreduce.job.mapoutputcombiner.class`参数,启用了一个特定的Combiner类来在Map任务的输出阶段进行合并操作。

## 3.2 Map端的优化技巧

### 3.2.1 Map任务的并行度调整

Map任务的并行度对于整个作业的执行时间有显著影响。如果并行度过低,会导致Map阶段成为瓶颈;如果并

0

0