【Kafka Streams Join操作】:流处理的高级策略与挑战

发布时间: 2024-10-31 07:26:11 阅读量: 29 订阅数: 30

kafka-streams-scala:Kafka Streams Java API周围的Thin Scala包装器

# 1. Kafka Streams Join操作的基础知识

在流处理的复杂场景中,Kafka Streams的Join操作是实现多数据源关联的重要功能。通过Join操作,可以将来自不同主题的数据流合并为单一流,基于特定的键值对进行组合,从而实现数据的丰富性和业务逻辑的完整性。本章将介绍Kafka Streams Join操作的基本概念和简单的用法,为深入理解后续的理论框架和实践应用打下基础。在此,我们将从Join操作的定义和应用场景开始,逐步展开对Kafka Streams Join操作的全面探索。

# 2. Kafka Streams Join操作的理论框架

### 2.1 Kafka Streams Join操作的数据模型

#### 2.1.1 Kafka Streams的数据流处理模型

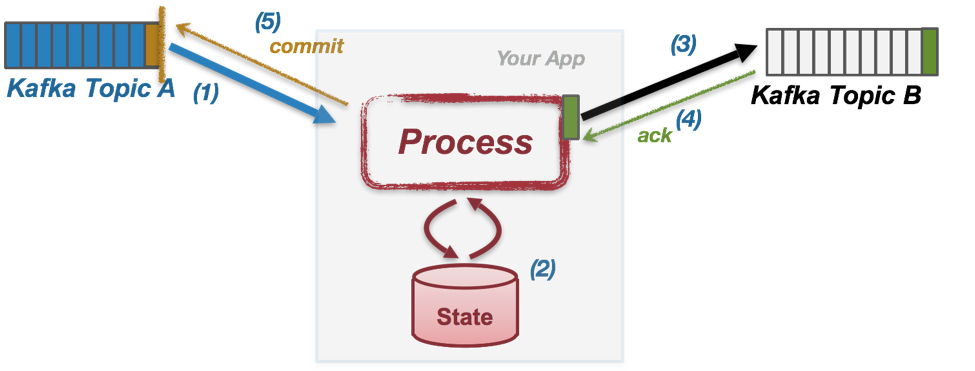

Kafka Streams作为Apache Kafka的一个客户端库,提供了一种简单而强大的方式来构建和运行实时数据处理应用。在Kafka Streams中,数据流处理模型主要基于一个主题(Topic)的连续数据流——被称为流(Stream),以及一个在处理中用来暂存中间数据的数据结构——称为表(Table)。

流是一系列连续不断的消息,可以类比为关系数据库中的记录日志,或者是实时数据源的无界数据集。流中的每个消息都包含了键值对(key-value pair),其中键用于唯一标识记录或执行状态的保持,值是具体的数据内容。

表则是从流中衍生出来的数据结构,它是一个有界的数据集,仅包含有特定键的数据。表可以看作是流的一个快照,它代表在某个特定时间点的全局视图。

流和表的操作为复杂的数据处理提供了丰富的工具集。例如,流可以进行诸如过滤(filter)、映射(map)、归约(reduce)等操作,而表则可以进行诸如更新(update)或聚合(aggregate)等操作。进一步的,通过Join操作可以将流与流、流与表、表与表等进行关联处理,以生成新的流或表。

#### 2.1.2 Kafka Streams的数据流和表的转换

在Kafka Streams中,流和表的转换是通过不同的操作来实现的。例如,流可以通过`groupByKey()`操作转换为表,该操作将流中具有相同键的所有值组织到一起。而表也可以通过`toStream()`操作转换为流,这个转换过程则是将表中的每个键值对视为流中的一条记录。

Kafka Streams的数据模型非常灵活,可以支持不同类型的Join操作。在某些场景下,我们会将一个表与一个流进行Join,也可能会将两个表进行Join。这些操作通常需要在Join之前明确地定义好key,以便于流或表可以正确地关联。

### 2.2 Kafka Streams Join操作的类型和使用场景

#### 2.2.1 Kafka Streams的基本Join类型

Kafka Streams支持多种Join操作,最常见的是内连接(inner join)、左连接(left join)和右连接(right join)。这些Join类型允许用户根据业务需求灵活地选择数据关联的方式。

内连接操作返回两个数据源中匹配的键值对,如果某一方没有匹配的记录,则不包含在结果中。左连接和右连接则是不对称的,左连接会返回左数据源中的所有记录,即使右数据源中没有匹配的记录也会包含在结果中,对于右数据源中未匹配的记录则结果中值为空。右连接则是右数据源的视角,其行为与左连接相反。

#### 2.2.2 不同Join类型的应用场景和选择

选择合适的Join类型对于满足业务需求至关重要。例如,在一个推荐系统中,用户的行为数据可以作为一个流,而产品信息可以存储为一个表。内连接可能用于找出同时具有行为数据和完整产品信息的记录,而左连接可能适用于希望包含所有用户行为数据,即使某些产品信息缺失的情况。

不同的Join操作导致不同的数据处理和性能特征,因此在选择Join类型时,也需要考虑数据的分布、数据量大小、处理速度等因素。在实际的应用中,开发人员可能需要根据性能测试结果或业务的实际需求来选择最合适的数据处理策略。接下来的章节,我们将深入探讨Kafka Streams Join操作的代码实践和性能优化方法。

# 3. Kafka Streams Join操作的实践应用

## 3.1 Kafka Streams Join操作的代码实践

### 3.1.1 Kafka Streams的Join代码编写

在Kafka Streams中进行Join操作,需要考虑数据流的键和时间窗口等因素,以便正确地将数据流关联起来。以下是一个简化的例子,我们将通过代码来演示如何在Kafka Streams中编写一个简单的Join操作。

```***

***mon.serialization.Serdes;

import org.apache.kafka.streams.KafkaStreams;

import org.apache.kafka.streams.StreamsBuilder;

import org.apache.kafka.streams.kstream.JoinWindows;

import org.apache.kafka.streams.kstream.KStream;

import org.apache.kafka.streams.kstream.KTable;

import org.apache.kafka.streams.kstream.Printed;

import java.time.Duration;

public class JoinExample {

public static void main(String[] args) {

// 创建Kafka Streams的构建器

StreamsBuilder builder = new StreamsBuilder();

// 定义输入流

KStream<String, String> leftStream = builder.stream("leftTopic", Consumed.with(Serdes.String(), Serdes.String()));

KStream<String, String> rightStream = builder.stream("rightTopic", Consumed.with(Serdes.String(), Serdes.String()));

// 定义窗口

JoinWindows joinWindow = JoinWindows.of(Duration.ofMinutes(5));

// 执行Join操作

KStream<String, String> joinedStream = leftStream.leftJoin(rightStream,

(leftValue, rightValue) -> "left=" + leftValue + ", right=" + rightValue,

joinWindow);

// 打印结果

joinedStream.to("joinedTopic", Produced.with(Serdes.String(), Serdes.String()));

// 构建并启动Kafka Streams应用

KafkaStreams streams = new KafkaStreams(builder.build(), getStreamsConfig());

streams.start();

}

private static Properties getStreamsConfig() {

// 配置省略,包含集群信息、应用ID、缓存大小等

// ...

return new Properties();

}

}

```

在这个例子中,我们创建了两个流(`leftStream` 和 `rightStream`)分别从不同的主题中读取数据。这两个流在5分钟的窗口内进行左外连接(`leftJoin`),并将结果输出到新的主题。连接操作的逻辑是将两个流中的值拼接在一起。

### 3.1.2 Kafka Streams的Join代码调试和优化

在编写Kafka Streams代码时,调试和优化是不可或缺的步骤。理解Kafka Streams的内部运行机制将有助于我们对程序进行有效的调试和性能优化。

调试可以通过日志输出来完成,例如在上述代码中,我们可以使用`Printed`来打印处理过程中的数据,帮助我们观察数据流的状态和转换。

```java

joinedStream.print(Printed.toSysOut());

```

优化方面,可以考虑减少网络传输和本地处理开销,例如通过合并主题来减少流的数量,或是优化键的划分策略来减少join操作时的数据倾斜问题。同时,在配置中调整缓冲区大小、线程数和任务数等参数也可以对性能产生显著影响。

## 3.2 Kafka Streams Join操作的性能优化

### 3.2.1 Kafka Streams Join操作的性能问题及解决

Kafka Streams的Join操作可能会

0

0