【Apache Drill Join操作】:SQL on Hadoop的灵活性与实践

发布时间: 2024-10-31 07:42:21 阅读量: 22 订阅数: 30

drill-site:Apache Drill网站

# 1. Apache Drill的介绍与安装

## 1.1 Apache Drill简介

Apache Drill是为大数据而设计的开源SQL查询引擎,旨在简化与传统数据库系统相同的用户查询分析能力,实现对各种数据源的快速查询,包括Hadoop和NoSQL数据库。Drill的推出标志着SQL on Hadoop技术的一大进步,使得Hadoop上的即席查询(SAQ)变得更加高效和易用。

## 1.2 SQL on Hadoop技术

在详细介绍Apache Drill之前,我们需要了解SQL on Hadoop这一概念。它是Hadoop生态系统中对存储在Hadoop上的数据进行即席查询的一系列技术和解决方案的总称。SQL on Hadoop的出现,极大地降低了用户与大数据进行交互的门槛,提升了数据的可用性。

## 1.3 Apache Drill的安装步骤

安装Apache Drill相对简单,可以通过包管理器或者下载预编译的二进制包来完成安装。以下是使用包管理器在Linux环境下安装的基本步骤:

- 下载并解压Drill安装包。

- 运行Drill的配置工具。

- 配置环境变量以便在命令行中直接访问Drill。

- 启动Drill服务并验证安装。

安装完成后,Drill将启动一个本地的嵌入式ZooKeeper实例,初始化并启动Drillbit服务。用户可以通过Drill的Web界面或者命令行界面来执行SQL查询。

# 2. 理解SQL on Hadoop技术

## 2.1 SQL on Hadoop的演变

### 2.1.1 Hadoop的SQL接口初探

Hadoop最初是为批处理任务设计的,使用MapReduce编程模型进行数据处理。传统的SQL引擎并不适用于Hadoop的分布式数据存储结构,主要是因为MapReduce模型与SQL的执行逻辑有着本质的不同。在这样的背景下,Hadoop上的SQL接口应运而生,旨在为用户提供一种能够利用SQL语言来查询和分析Hadoop上的数据的方式。

Hive是首个尝试将SQL带到Hadoop生态中的工具,它通过一个叫作HiveQL的查询语言,将传统的SQL语句转换为MapReduce任务,使得非编程人员也能对Hadoop进行查询操作。随着时间的发展,其他工具如Pig(使用Pig Latin语言)和HBase shell等,也提供了类似的SQL-like查询接口。

### 2.1.2 传统SQL与SQL on Hadoop的对比

传统SQL在关系型数据库中执行时,是建立在数据模型规范和索引优化之上的,它对于数据的一致性和完整性有严格的约束。相反,SQL on Hadoop工具则是在大规模分布式环境中的数据上执行,需要面对数据分布不均匀、节点可能随时失效等问题。因此,SQL on Hadoop工具必须有处理大数据特有问题的方案,比如数据倾斜、网络延迟、磁盘I/O等。

与传统SQL相比,SQL on Hadoop支持的查询操作更加复杂和多样。比如支持复杂的JSON和Avro数据格式的查询,以及对大数据集进行的关联查询(Join)和聚合计算。SQL on Hadoop的设计目标是提供与传统SQL相当的易用性,同时扩展其能力以满足大数据处理的需求。

## 2.2 Apache Drill的架构与特点

### 2.2.1 Drill的分布式查询引擎架构

Apache Drill是基于Google Dremel的论文设计实现的,旨在提供一个低延迟的交互式分布式SQL查询引擎。Drill支持多种数据源,包括Hadoop上的Hive、Parquet、Avro、RCFile等,还支持NoSQL数据库如HBase和MongoDB。

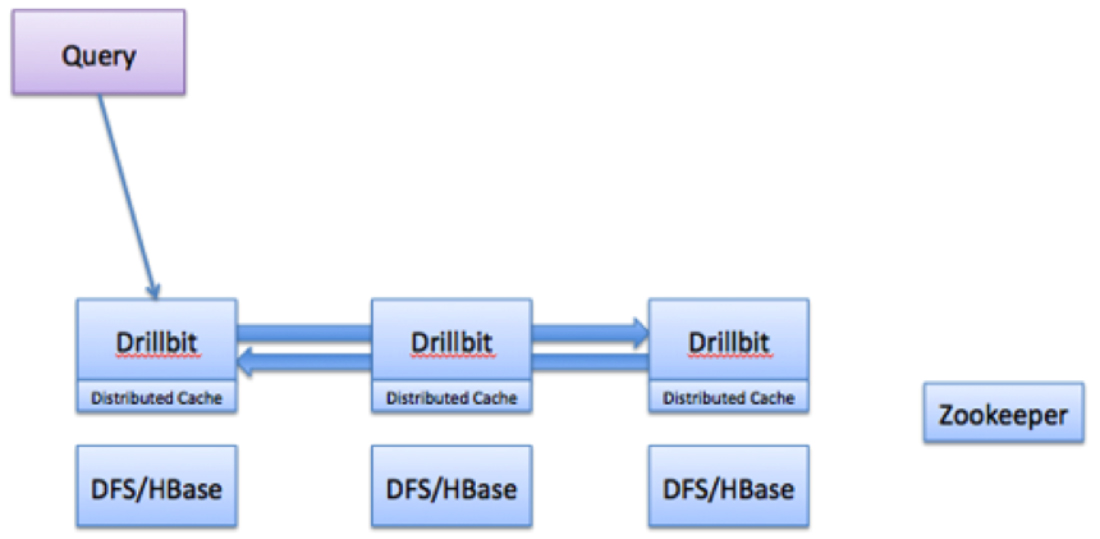

Drill的架构基于微服务和插件化的设计理念,其核心组件包括Drillbit服务和Drill查询执行引擎。Drillbit是Drill集群中的工作节点,负责执行查询计划,处理数据读取与写入,并与其他Drillbit通信。查询执行引擎负责解析SQL语句、生成查询计划、优化和执行查询。

### 2.2.2 Drill的无模式和灵活性优势

Drill的一个显著特点是它的无模式(Schema-free)设计。在Hadoop生态中,数据往往存储为各种格式,如Parquet、ORC等,并且存储在HDFS上。传统的关系型数据库需要预先定义数据的模式,而在大数据场景下,数据格式和结构经常变化,预定义模式的限制就显得不合适。Drill能够自动推断数据模式,使得用户无需为数据定义模式,从而能够更快地探索和分析数据。

这种灵活性极大地提高了开发人员的生产效率,他们可以直接在数据上执行查询,而无需进行繁琐的数据预处理或模式定义步骤。这对于数据探索、即席查询和复杂数据分析尤其有帮助。

### 2.2.3 Drill与Hadoop生态系统的集成

Apache Drill紧密集成了Hadoop生态系统中的各种组件,使得它能够利用Hadoop的分布式计算能力和存储能力。Drill可以连接到Hadoop上的Hive Metastore,从而查询存储在Hive表中的数据。同时,Drill也可以直接读取存储在HDFS上的非结构化数据,如Parquet、Avro等格式,这些数据格式广泛用于Hadoop生态系统中。

Drill支持实时数据查询,能够与HBase等NoSQL数据库集成,使得用户能够执行联机事务处理(OLTP)类型的查询。其与YARN的集成,让Drill能够利用YARN作为资源管理器,动态分配计算资源,进一步提高了资源利用率和查询性能。

接下来的章节将深入探讨Apache Drill的Join操作,以及如何优化这些操作以提高查询性能。我们将看到如何将这些理论应用到实际的大数据环境中,以及如何使用Drill解决复杂的查询问题。

# 3. 掌握Apache Drill的Join操作

## 3.1 Join操作的基础

### 3.1.1 SQ

0

0