【大数据表Join操作】:MapReduce实践案例与深度分析

发布时间: 2024-10-31 06:54:22 阅读量: 26 订阅数: 30

大数据实验 实验五:MapReduce 初级编程实践

# 1. 大数据表Join操作概述

在现代数据处理中,Join操作是数据仓库和大数据应用中不可或缺的一环。它是将两个或多个数据表根据共同的键值进行关联合并,形成一个扩展表的过程。例如,在一个电商网站中,通过Join操作可以将订单表和用户信息表关联起来,以提供更丰富的数据分析和报告。

Join操作通常出现在数据仓库的ETL(提取、转换、加载)过程中,尤其是在数据整合和转换阶段。合理的使用Join操作,可以让数据分析师在单个查询中获取到更多的业务洞见。然而,在大规模数据集上执行Join操作,尤其是在分布式计算环境中,可能会面临性能瓶颈和资源消耗巨大的挑战。

在分布式计算框架如Apache Hadoop中,MapReduce是一种广泛使用的编程模型,专门用于处理大规模数据集的并行运算。在第二章至第五章中,我们将深入探讨MapReduce在处理Join操作中的理论基础、实践应用以及与现代大数据框架的关系。我们将从基础理论出发,逐步讲解到具体的应用案例,最终在对比分析中展望MapReduce的未来发展方向。

# 2. MapReduce基础理论

## 2.1 MapReduce模型理解

### 2.1.1 MapReduce的核心概念

MapReduce是Google提出的一种编程模型,用于大规模数据集的并行运算。其主要思想来源于Map和Reduce两个函数,它们都是对数据集进行操作的函数式接口。核心概念包括:

- **Map(映射)**:这个函数处理输入的数据,将这些数据转换成一系列中间值。每个中间值是一个键值对(key-value pair),这个过程称为映射。

- **Reduce(归约)**:这个函数处理所有映射出来的中间值,通常是将具有相同键值的值合并起来,以产生一个输出结果。

MapReduce模型的优势在于:

- **可扩展性**:通过分布式处理,可以在多台机器上并行处理数据。

- **容错性**:通过数据的复制和任务的重试,能够应对节点故障。

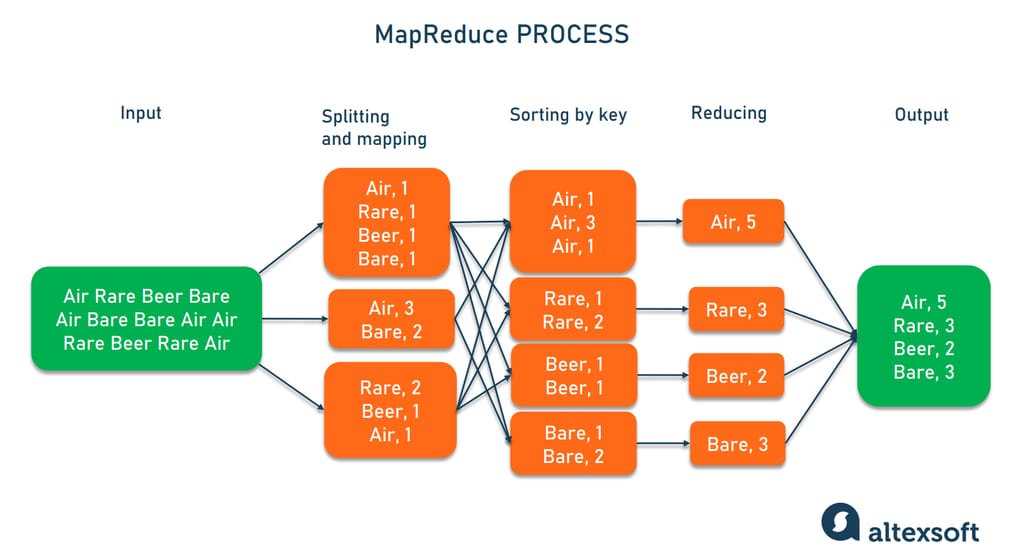

### 2.1.2 MapReduce的工作流程

一个标准的MapReduce程序工作流程可以分为以下几个步骤:

1. **输入分割**:将输入数据分割成多个数据块,以便在多个Map任务上进行并行处理。

2. **Map阶段**:对每个输入数据块并行执行Map任务,输出中间键值对。

3. **Shuffle**:系统自动进行Shuffle操作,将所有中间键值对按键进行排序,并分配到对应的Reduce任务。

4. **Reduce阶段**:对具有相同键的值进行归约处理,输出最终的结果。

5. **输出**:将Reduce的结果写入到输出文件系统中。

接下来,我们会详细介绍MapReduce的编程模型和优化理论。

# 3. MapReduce Join操作实践

## 3.1 Map端Join的实现方法

### 3.1.1 数据预处理

在Map端Join之前,需要进行数据预处理。数据预处理是MapReduce Join操作的重要前提,它包括数据的清洗、格式化、分组等操作。为了实现Map端Join,通常要求两个参与Join的数据表事先按照Join键进行分组和排序。这可以通过MapReduce作业预先处理数据,或者利用Hadoop生态系统中的其他工具,如Hive进行数据整理。

### 3.1.2 Map端Join的操作流程

Map端Join适用于小表和大表的Join操作,其操作流程如下:

1. **数据准备**:将小表加载到分布式缓存中,大表作为MapReduce的输入数据。

2. **数据读取**:Map函数读取大表中的每一条记录。

3. **数据匹配**:Map函数在读取大表记录的同时,查询缓存中的小表数据,寻找匹配的记录。

4. **数据合并**:将大表和小表中匹配的数据合并为一条记录,输出。

5. **输出结果**:Map函数输出所有合并后的记录。

下面的代码块是Map端Join的简单实现示例。

```java

public static class Map端JoinMapper extends Mapper<LongWritable, Text, Text, Text> {

private Text outputKey = new Text();

private Text outputValue = new Text();

// 假设小表已加载到内存中,这里仅为示例

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] smallTableFields = smallTable.get(value.toString()); // 从内存中获取小表数据

// 大表的值经过处理,获取到需要的字段

String[] bigTableFields = value.toString().split(",");

outputKey.set(bigTableFields[0]); // Join键作为输出键

outputValue.set(bigTableFields[1] + "," + smallTableFields[1]); // 大表字段和小表字段拼接作为输出值

context.write(outputKey, outputValue);

}

}

```

上述代码中,`smallTable`是一个假设在内存中的小表数据结构,实际应用中可能需要将小表数据加载到`DistributedCache`。代码块逐行解读:

- `Map端JoinMapper`类继承自`Mapper`,重写了`map`方法。

- `outputKey`和`outputValue`是用于输出键值对的变量。

- 在`map`方法中,通过读取小表数据和大表数据,执行join操作。

- 输出的键是大表和小表共有的字段,输出的值是大表的其他字段和小表的字段拼接。

## 3.2 Reduce端Join的实现方法

### 3.2.1 数据排序与分区

在Reduce端Join中,关键步骤之一是确保参与Join的表在数据传输到Reducer之前被正确地排序和分区。这样,具有相同Join键的

0

0