Kafka数据流处理实战:构建实时数据处理管道

发布时间: 2024-07-02 00:37:14 阅读量: 72 订阅数: 24

Kafka大数据实战

# 1. Kafka数据流处理简介

Kafka数据流处理是一种强大的技术,它使组织能够实时处理和分析大量数据流。它提供了强大的功能,例如数据摄取、变换、聚合和持久化,使组织能够从数据流中提取有价值的见解并做出明智的决策。

Kafka数据流处理基于分布式流处理平台Kafka,它提供高吞吐量、低延迟和容错性。它使组织能够轻松处理来自各种来源的数据,包括传感器、日志文件和应用程序。

通过利用Kafka数据流处理,组织可以实现实时数据分析、欺诈检测、客户行为分析和许多其他应用程序。它为组织提供了强大的工具,可以从数据流中提取价值并推动业务增长。

# 2. Kafka数据流处理基础**

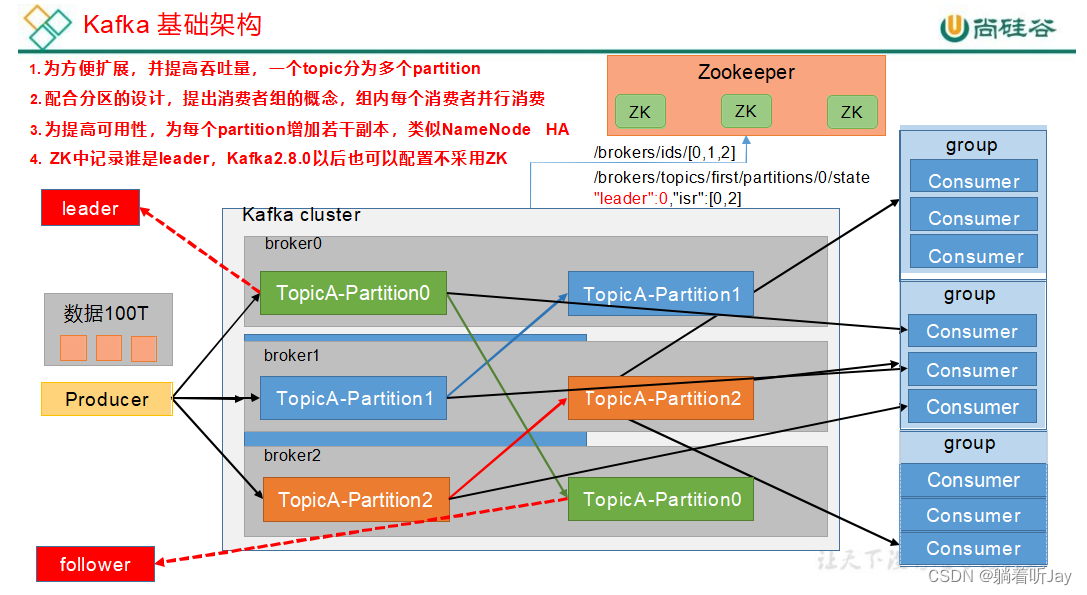

**2.1 Kafka数据流架构**

Kafka数据流处理架构是一个分布式系统,用于处理大量实时数据。它由以下组件组成:

- **Kafka代理:**存储和管理数据流的分布式日志系统。

- **生产者:**向Kafka代理发送数据的应用程序或服务。

- **消费者:**从Kafka代理读取数据的应用程序或服务。

- **处理引擎:**处理从Kafka代理读取的数据的应用程序或服务。

- **存储系统:**用于存储处理结果的持久化存储。

**2.2 Kafka数据流处理模型**

Kafka数据流处理模型基于发布-订阅模式,其中:

- **发布者:**将数据发布到Kafka代理。

- **订阅者:**从Kafka代理订阅数据流。

- **处理引擎:**订阅数据流并对其进行处理。

数据流处理模型允许多个处理引擎同时处理同一数据流,从而实现并行处理和可扩展性。

**代码块:**

```java

// 创建Kafka生产者

Producer<String, String> producer = new KafkaProducer<>(props);

// 创建Kafka消费者

Consumer<String, String> consumer = new KafkaConsumer<>(props);

// 订阅主题

consumer.subscribe(Collections.singletonList("my-topic"));

// 循环读取消息

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

// 处理消息

}

}

```

**逻辑分析:**

这段代码演示了Kafka数据流处理模型。它创建了一个生产者来发布数据到Kafka代理,并创建了一个消费者来订阅数据流。消费者不断轮询Kafka代理以获取新消息,并对每个消息进行处理。

**参数说明:**

- `props`:Kafka生产者或消费者的配置属性。

- `"my-topic"`:要订阅的Kafka主题。

- `100`:轮询Kafka代理以获取新消息的超时时间(毫秒)。

# 3.1 实时数据摄取和处理

**数据摄取**

数据摄取是将数据从源头加载到 Kafka 数据流中的过程。Kafka 提供了多种连接器和 API,用于从各种数据源摄取数据,包括:

- **Kafka Connect:**一种可插拔的框架,用于从各种数据源连接和摄取数据,如数据库、文件系统和 Web 服务。

- **Kafka REST API:**一个 RESTful API,用于发送数据到 Kafka 主题。

- **Kafka Producers:**用于通过代码直接将数据发送到 Kafka 主题的客户端库。

**数据处理**

一旦数据被摄取到 Kafka 中,它就可以使用 Kafka Streams API 进行实时处理。Kafka Streams API 提供了一组操作符,用于对数据流进行转换、聚合和过滤。

**操作符**

Kafka Streams API 中常用的操作符包括:

- **map():**将每个记录映射到一个新的记录。

- **filter():**根据条件过滤记录。

- *

0

0