Hadoop分布式框架与大数据处理详解

下载需积分: 10 | PPTX格式 | 964KB |

更新于2024-07-22

| 6 浏览量 | 举报

"本文档主要介绍了Hadoop的详细知识,包括Hadoop在云计算和大数据处理中的应用,以及Hadoop从1.0到2.0的架构、编程和部署方面的演变。"

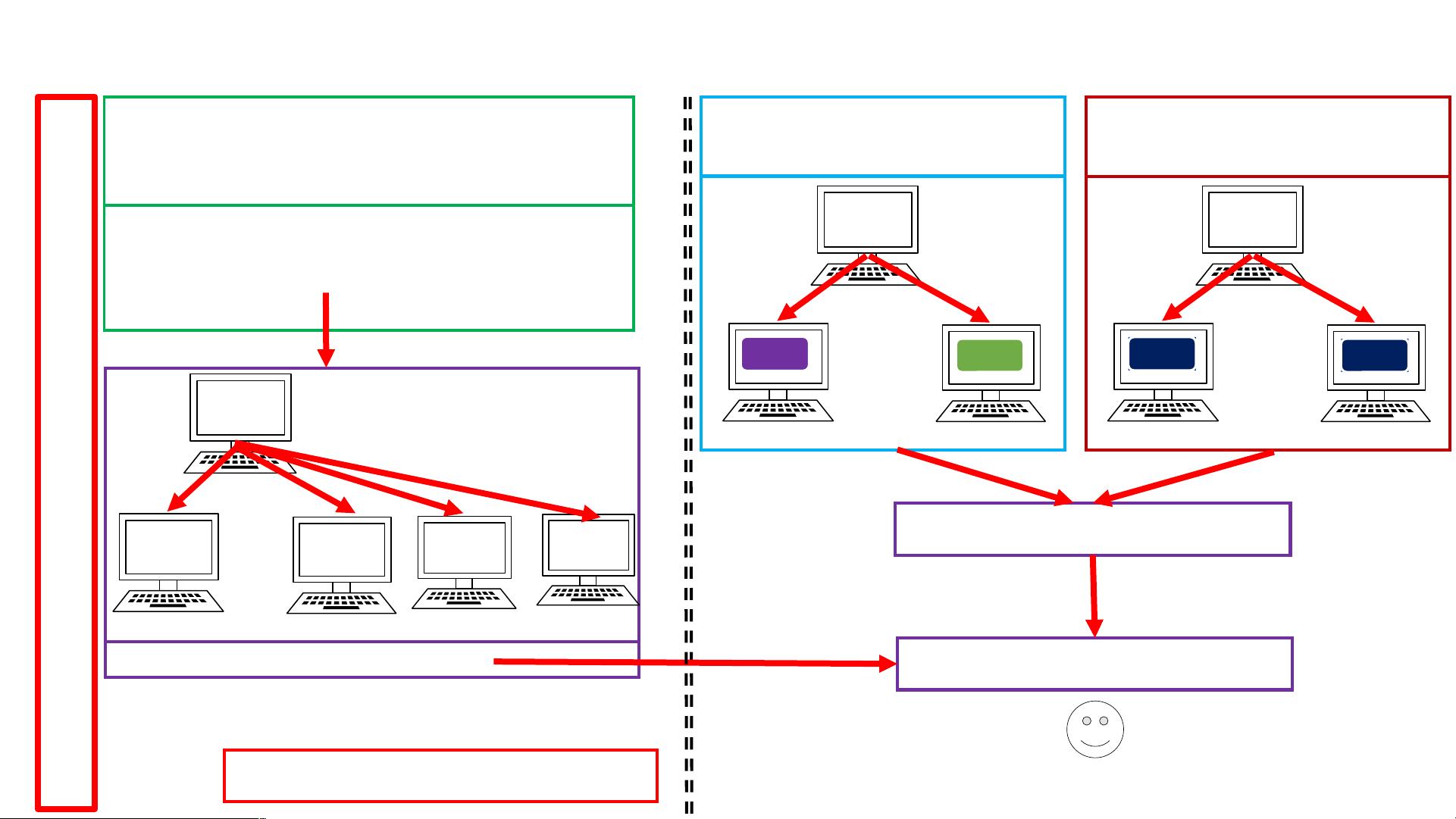

在理解Hadoop之前,首先需要了解分布式计算的基本概念。分布式计算是将大型任务分解成多个小任务,在多台计算机(节点)上并行处理,以提高计算效率和存储能力。Hadoop作为开源的分布式计算框架,正是为了解决大规模数据处理的问题而设计的。

Hadoop 1.0 架构主要包括两个核心组件:HDFS(Hadoop Distributed File System)和MapReduce。HDFS是一种分布式文件系统,它将大文件分割成块并存储在多台机器上,提供了高容错性和高可用性。MapReduce则是用于处理和生成大规模数据集的编程模型,它将计算任务分为“映射”(Map)和“化简”(Reduce)两个阶段,使得数据可以在集群中并行处理。

在Hadoop 1.0中,存在一些显著的问题,如JobTracker的单点故障和任务调度效率低。JobTracker负责管理和调度所有任务,如果它失败,整个系统可能瘫痪。此外,数据传输效率不高,因为所有Reduce任务都要通过单一的TaskTracker。

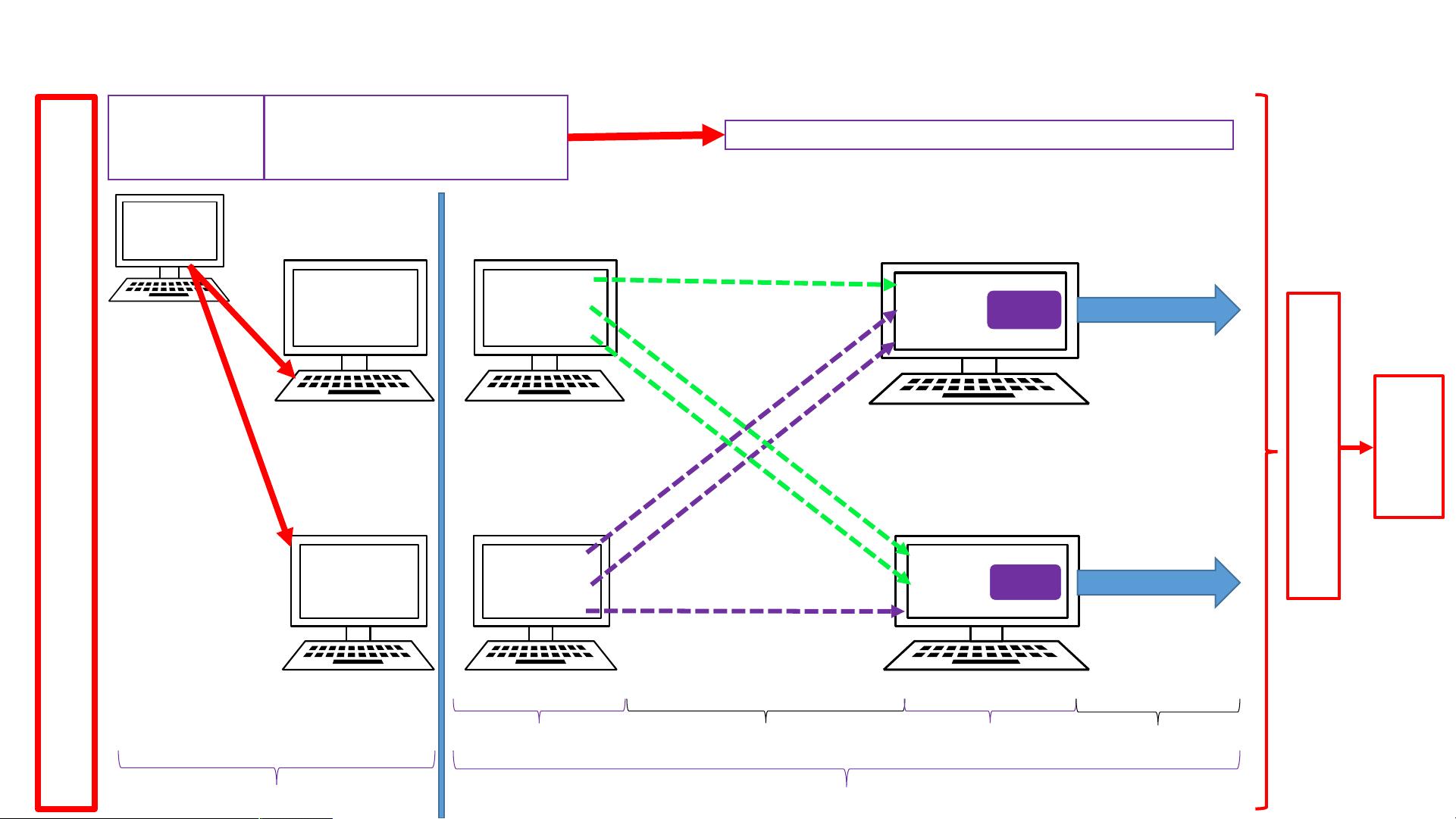

为了解决这些问题,Hadoop 2.0引入了YARN(Yet Another Resource Negotiator)。YARN将JobTracker的功能拆分为Resource Manager和Application Master,Resource Manager负责全局资源管理,Application Master则负责具体应用的调度和监控。这一改变提高了系统的容错性和资源利用率。

Hadoop 2.0编程模型仍然基于MapReduce,但引入了更灵活的计算框架,如Spark和Flink,它们可以在YARN上运行,提供更高效的数据处理能力。同时,Hadoop 2.0的HDFS引入了HDFS Federation,允许多个NameNode并存,增强了系统的扩展性。

Hadoop的部署通常涉及安装Hadoop环境,配置集群参数,如节点间通信、数据复制策略等,以及安装和配置Hadoop生态系统中的其他组件,如Hive(用于SQL查询)、HBase(NoSQL数据库)、Pig(数据流处理)等。

在应对大数据挑战时,Hadoop的分布式解决方案提供了关键的优势。通过将数据分布在多台机器上,Hadoop能够处理PB级别的数据。同时,其容错机制确保即使部分节点故障,系统也能继续运行。此外,MapReduce模型使得复杂的数据分析任务可以并行处理,大大缩短了计算时间。

总结来说,Hadoop是一个强大的分布式计算平台,特别适合处理和存储大规模数据。从1.0到2.0的演进,Hadoop不断优化了其架构和性能,以适应不断增长的大数据需求。理解并掌握Hadoop对于从事云计算和大数据领域的专业人士至关重要。

相关推荐

Giddens_

- 粉丝: 0

最新资源

- Subclipse 1.8.2版:Eclipse IDE的Subversion插件下载

- Spring框架整合SpringMVC与Hibernate源码分享

- 掌握Excel编程与数据库连接的高级技巧

- Ubuntu实用脚本合集:提升系统管理效率

- RxJava封装OkHttp网络请求库的Android开发实践

- 《C语言精彩编程百例》:学习C语言必备的PDF书籍与源代码

- ASP MVC 3 实例:打造留言簿教程

- ENC28J60网络模块的spi接口编程及代码实现

- PHP实现搜索引擎技术详解

- 快速香草包装技术:速度更快的新突破

- Apk2Java V1.1: 全自动Android反编译及格式化工具

- Three.js基础与3D场景交互优化教程

- Windows7.0.29免安装Tomcat服务器快速部署指南

- NYPL表情符号机器人:基于Twitter的图像互动工具

- VB自动出题题库系统源码及多技术项目资源

- AndroidHttp网络开发工具包的使用与优势