"深入学习损失函数:从基础到新进展"

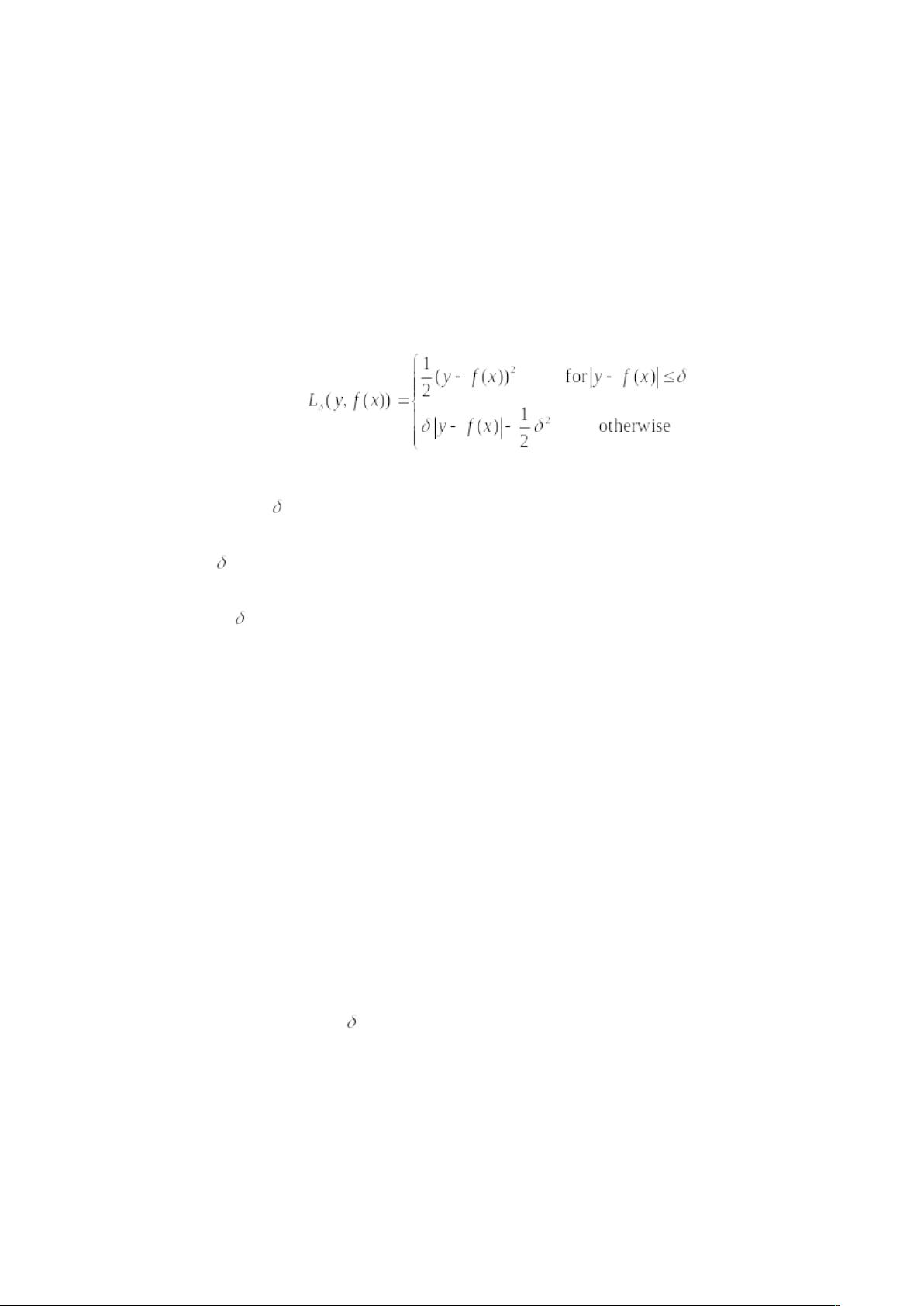

损失函数是深度学习中一个非常重要的概念,它用来衡量模型输出与实际标签之间的距离或差异。在本文中,我们将对损失函数的基本原理进行梳理和总结,并介绍一些比较新的损失函数,如softmax loss、A-softmax、center loss、coco-loss和triple-loss,以及它们的理论推导和应用情况。

在绪论部分,我们首先对损失函数和代价函数进行了定义和区分。损失函数是定义在单个样本上的,用来计算一个样本的误差,而代价函数是整个训练集上所有样本误差的平均值。目标函数则是需要优化的函数,用来衡量模型的性能和拟合效果。为了更好地理解这些概念,我们引入了风险函数的概念,用来度量模型拟合结果的好坏。

接着,我们对softmax loss进行了详细的介绍。softmax loss是常用于多分类任务的损失函数,它能够将模型输出的分数转换为概率分布,并计算该分布与实际标签之间的交叉熵损失。我们讨论了softmax loss的数学原理和推导过程,以及其在实际应用中的重要性和效果。

除了softmax loss,我们还介绍了一些比较新的损失函数。A-softmax是一种用于人脸识别任务的损失函数,它在softmax loss的基础上,引入了参数α,用来增强类间的距离,从而改善模型的性能。Center loss和coco-loss分别用于人脸识别和目标检测任务,它们在损失函数中加入了类别中心的约束,以减小类别内部的变异性,提高模型的判别能力。而triple-loss则是用于学习相似度度量的损失函数,它在训练过程中同时考虑了正负样本和锚点之间的关系,能够有效地优化模型在相似度度量任务中的性能。

总的来说,本文总结了损失函数的基本原理和相关研究和应用情况,适合入门级的同学阅读参考。文章力求对每个损失函数进行了详细的理论推导和解释,希望读者能够从中深入了解不同损失函数的特点和适用场景。最后,需要强调的是,本文的内容主要来源于网络和论文,还包含部分个人的理解,如有错误之处,请读者批评指正。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-05-31 上传

2015-03-12 上传

2020-12-21 上传

2022-07-20 上传

2017-10-14 上传

2018-09-04 上传

绿色背影

- 粉丝: 5

- 资源: 9

最新资源

- DWR中文文档pdf

- ADHOC网络中的一种QOS_AWARE多径路由协议.pdf

- U—Boot及Linux2.6在S3C2440A平台上的移植方法

- Core+Java (Java核心技术卷1)

- stc89c51系列单片机使用手册

- Verilog 黄金参考指南

- Silverlight完美入门.pdf

- 领域驱动设计 domain driven design

- VLAN典型配置方案

- 02/03注册电气工程师模拟试题-模拟电子技术基础

- 关于操作反射的部分代码

- Ubuntu 参考手册

- 中国矿业大学电拖试题

- ASP.NET加密教程(MD5和SHA1加密几种方法)

- linux -shell手册

- 信息发布系统毕业论文 (asp+sql2000)