Hadoop实战:Shell与Java接口操作文件上传下载

需积分: 10 183 浏览量

更新于2024-09-12

收藏 780KB DOC 举报

"Hadoop的shell接口和java接口用于在Hadoop分布式文件系统(HDFS)中进行文件上传和下载操作。在使用shell接口时,需确保文件路径正确,并通过md5值验证上传是否成功。在Java接口方面,需导入特定版本的Hadoop库,如Hadoop-2.9.1,以避免运行错误。实验目标包括使用shell和Java接口进行文件操作,并通过编写map-reduce程序对数据进行分析。实验环境涉及VMware Station和Eclipse IDE,以及Windows 10操作系统。"

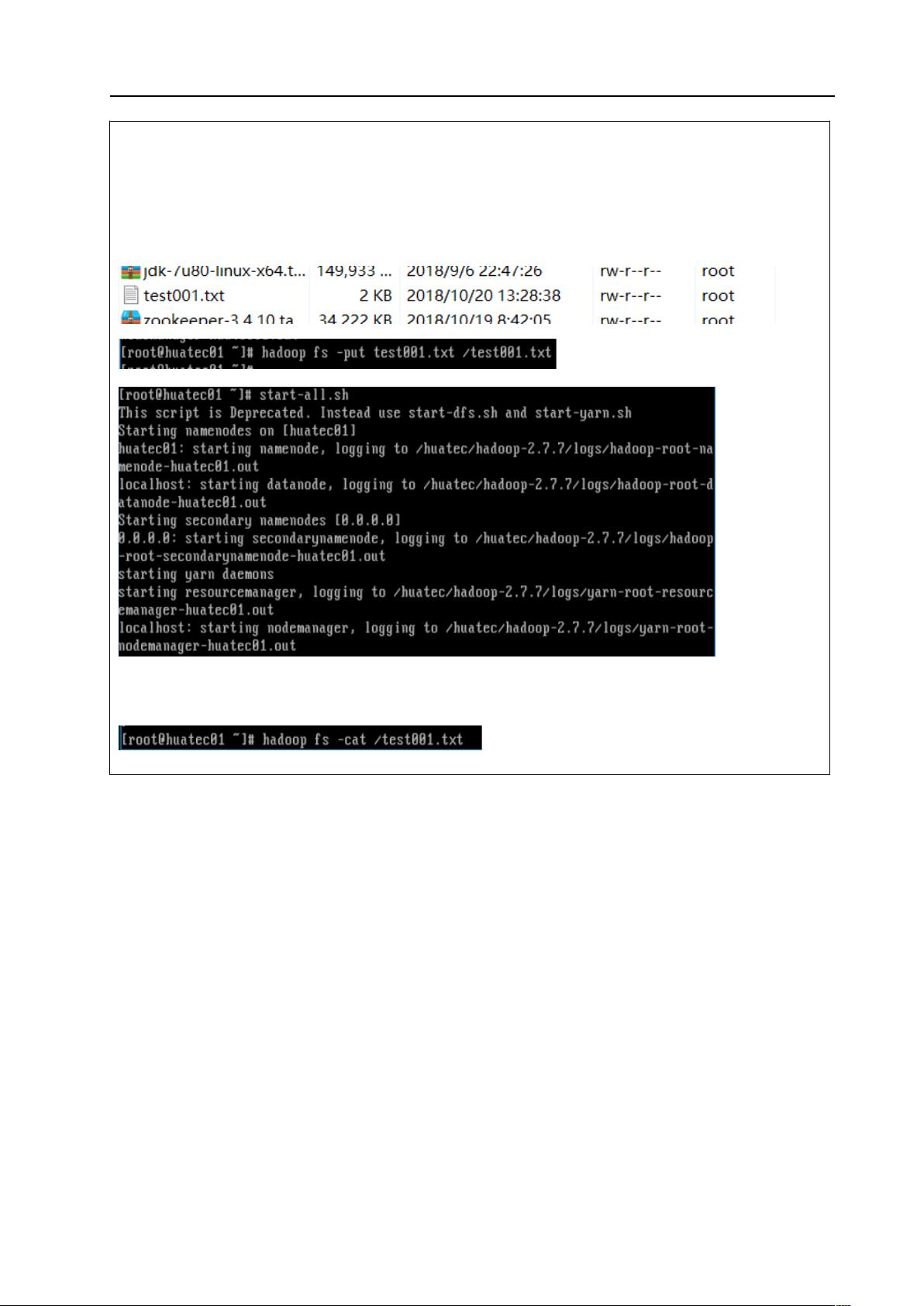

在大数据处理与智能决策的Hadoop实战开发实验中,学生需掌握两种主要的文件操作方式:shell接口和Java接口。shell接口主要用于简单快速地执行命令行操作,例如使用`hadoopfs-put`命令上传文件到HDFS,`hadoopfs-ls`查看文件列表,以及`hadoopfs-get`下载文件。为了确认文件完整性,可以通过`md5sum`命令对比源文件和HDFS上文件的md5值。

Java接口则更适用于复杂的应用场景,需要设置好开发环境,例如创建Java项目,并导入Hadoop相关的jar包,包括`hadoop-2.9.1`目录下各组件的jar包。通过Java接口,可以实现更为灵活的文件操作,包括上传和下载。实验中提供了Java代码示例,帮助学生理解和实现HDFS文件系统的交互。

实验还强调了编写map和reduce函数来生成jar包,这一步骤是Hadoop处理大规模数据的关键。Map函数负责将输入数据分割并转换,而reduce函数则整合map阶段的结果,实现聚合或汇总操作。通过这种方式,学生可以学习如何利用Hadoop进行数据处理和分析。

这个实验旨在让计算机科学与技术专业的学生熟悉Hadoop生态系统,掌握在HDFS中进行文件操作的基本技能,以及运用map-reduce编程模型解决实际问题的能力。通过实验,学生能够深化对Hadoop分布式计算的理解,并提升在实际环境中应用Hadoop的实践经验。

2019-06-11 上传

2019-03-04 上传

2024-06-26 上传

2024-09-12 上传

2023-06-13 上传

2023-05-23 上传

2024-06-25 上传

2024-09-20 上传

燃烧0121

- 粉丝: 0

- 资源: 3

最新资源

- 多传感器数据融合手册:国外原版技术指南

- MyEclipse快捷键大全,提升编程效率

- 从零开始的编程学习:Linux汇编语言入门

- EJB3.0实例教程:从入门到精通

- 深入理解jQuery源码:解析与分析

- MMC-1电机控制ASSP芯片用户手册

- HS1101相对湿度传感器技术规格与应用

- Shell基础入门:权限管理与常用命令详解

- 2003年全国大学生电子设计竞赛:电压控制LC振荡器与宽带放大器

- Android手机用户代理(User Agent)详解与示例

- Java代码规范:提升软件质量和团队协作的关键

- 浙江电信移动业务接入与ISAG接口实战指南

- 电子密码锁设计:安全便捷的新型锁具

- NavTech SDAL格式规范1.7版:车辆导航数据标准

- Surfer8中文入门手册:绘制等高线与克服语言障碍

- 排序算法全解析:冒泡、选择、插入、Shell、快速排序