探索人工神经网络:BP详解、应用与发展历程

版权申诉

174 浏览量

更新于2024-07-04

收藏 686KB PPTX 举报

人工神经网络(Artificial Neural Networks, ANN)是现代机器学习领域的重要组成部分,它旨在模仿人类大脑的工作原理,实现智能化计算。ANN的研究起源于20世纪40年代末,由心理学家W.McCulloch和数学家W.Pitts提出的简单神经元模型(MP模型)拉开了神经网络研究的序幕。早期的尝试如感知机(Perceptron)在模式识别领域取得了一定成果。

然而,由于理论上的限制和实际应用中的局限,神经网络的研究经历了起伏。在70-80年代初,由于某些挑战和理论难题,神经网络进入了低潮期。直到1982年,美国物理学家J.J.Hopfield提出的Hopfield模型重新点燃了人们对神经网络的热情。Hopfield模型是一个自组织的非线性动力学网络,它通过反复迭代的方式解决复杂问题,展示了与传统符号逻辑处理方法不同的优势。

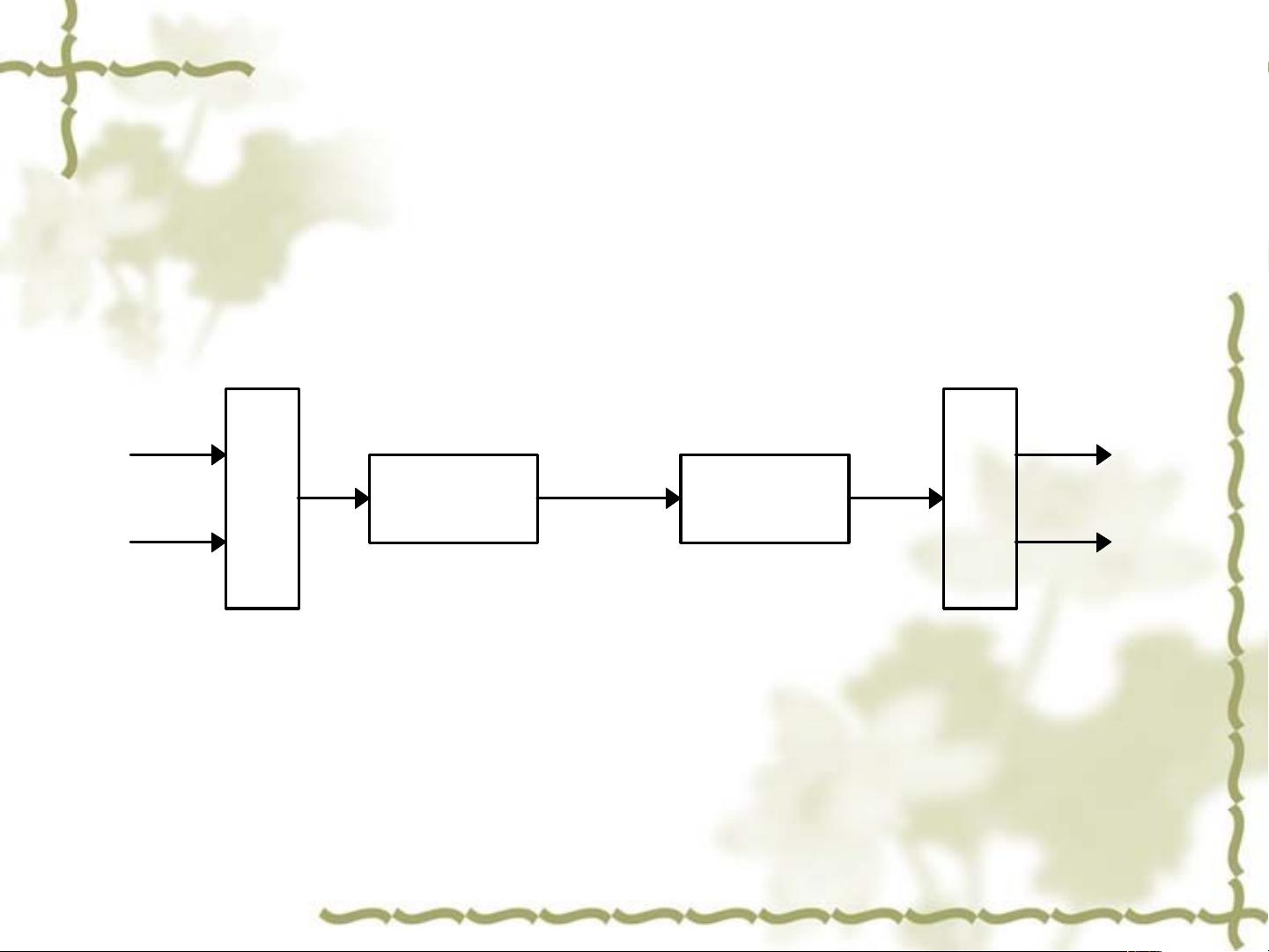

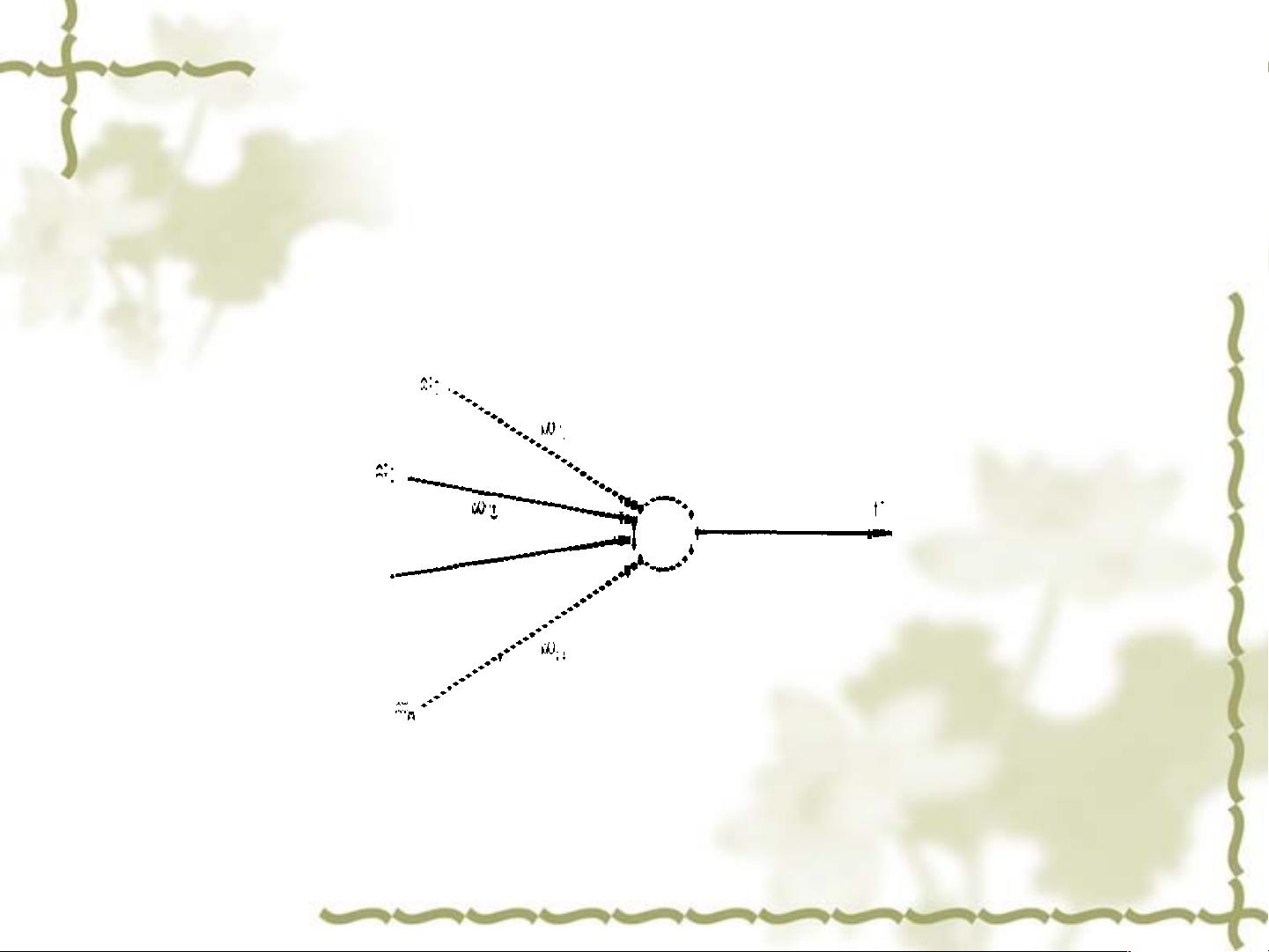

神经网络的主要目标包括:(1)理论研究,即开发更精确的模型和学习算法,如BP(Backpropagation,反向传播)算法,它是一种训练多层神经网络的有效方法,能够以较快的速度和高精度调整权重,从而使网络收敛到最优解。(2)实现技术的研究,探讨如何利用物理设备如电子、光学或生物学原理构建神经计算机,这不仅限于硬件层面,也涉及到算法与硬件的集成。(3)实际应用,如模式识别、故障检测、智能机器人等领域,这些应用场景展示了神经网络的强大潜力,使其在图像识别、语音识别、自然语言处理等多个AI前沿领域大放异彩。

研究ANN的意义深远,它有助于理解思维本质,探索智能的起源,并试图构造出与人脑功能相似的计算机,即ANN计算机。通过模拟人脑的神经结构和功能,人工神经网络可以超越传统计算机在处理复杂问题时的局限,特别是在处理非线性问题和解决高维度数据方面具有独特的优势。

从历史发展看,神经网络的研究经历了两次高潮和低谷,但随着计算能力的提升和深度学习的兴起,特别是大数据和GPU的普及,神经网络进入了新的发展阶段,深度学习模型如卷积神经网络(Convolutional Neural Networks, CNN)、循环神经网络(Recurrent Neural Networks, RNN)和Transformer等,进一步推动了神经网络在人工智能领域的广泛应用。

总结起来,人工神经网络不仅是理解人类智能机制的关键工具,也是实现人工智能进步的重要引擎,其理论研究、实现技术和应用前景都充满无限可能。随着科技的不断进步,我们期待神经网络在未来能带来更多的创新和突破。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-04-27 上传

2021-10-01 上传

2021-10-10 上传

passionSnail

- 粉丝: 467

- 资源: 7836

最新资源

- 微软C编程精粹 专业的程序设计指导资料

- 新东方刘畅词汇新东方刘畅词汇

- [概要设计] 图书管理系统概要设计说明书

- 需 求 规 格 说 明 书

- 网站用户单点登录系统解决方案

- struts validator框架验证和多模块开发总结.doc

- TC经典程序设计题目

- GIS软件应用实验指导

- unix高级程序设计

- ARM仿真工具IAREW使用教程

- OpenCV学习资料

- 2008上半年软件设计师考试答案

- 基于嵌入式的mp3播放器设计!

- 富客户端语言Curl介绍

- How to validate XML documents against Schematron rules

- 使用JDBC和Hibernate来写入Blob型数据到Oracle中