神经网络基础:从感知机到sigmoid与ReLU

需积分: 10 74 浏览量

更新于2024-07-17

收藏 1.56MB PPTX 举报

"这篇学习笔记主要介绍了人工神经网络(ANN)的基础知识,包括感知机模型、激活函数如Sigmoid和ReLU,以及神经网络中的权重和偏置概念。"

神经网络是一种模拟人脑神经元工作方式的计算模型,它在各种领域如医学、经济、控制和心理学中都有广泛应用。其核心在于通过多个处理单元(神经元)之间的连接和权重分配来实现复杂的信息处理和模式识别。感知机是神经网络的最简单形式,它接受多个输入信号(如x1、x2),与对应的权重(w1、w2)相乘后,加上一个偏置(b)进行总和判断。如果总和超过阈值,输出为1,否则输出为0。

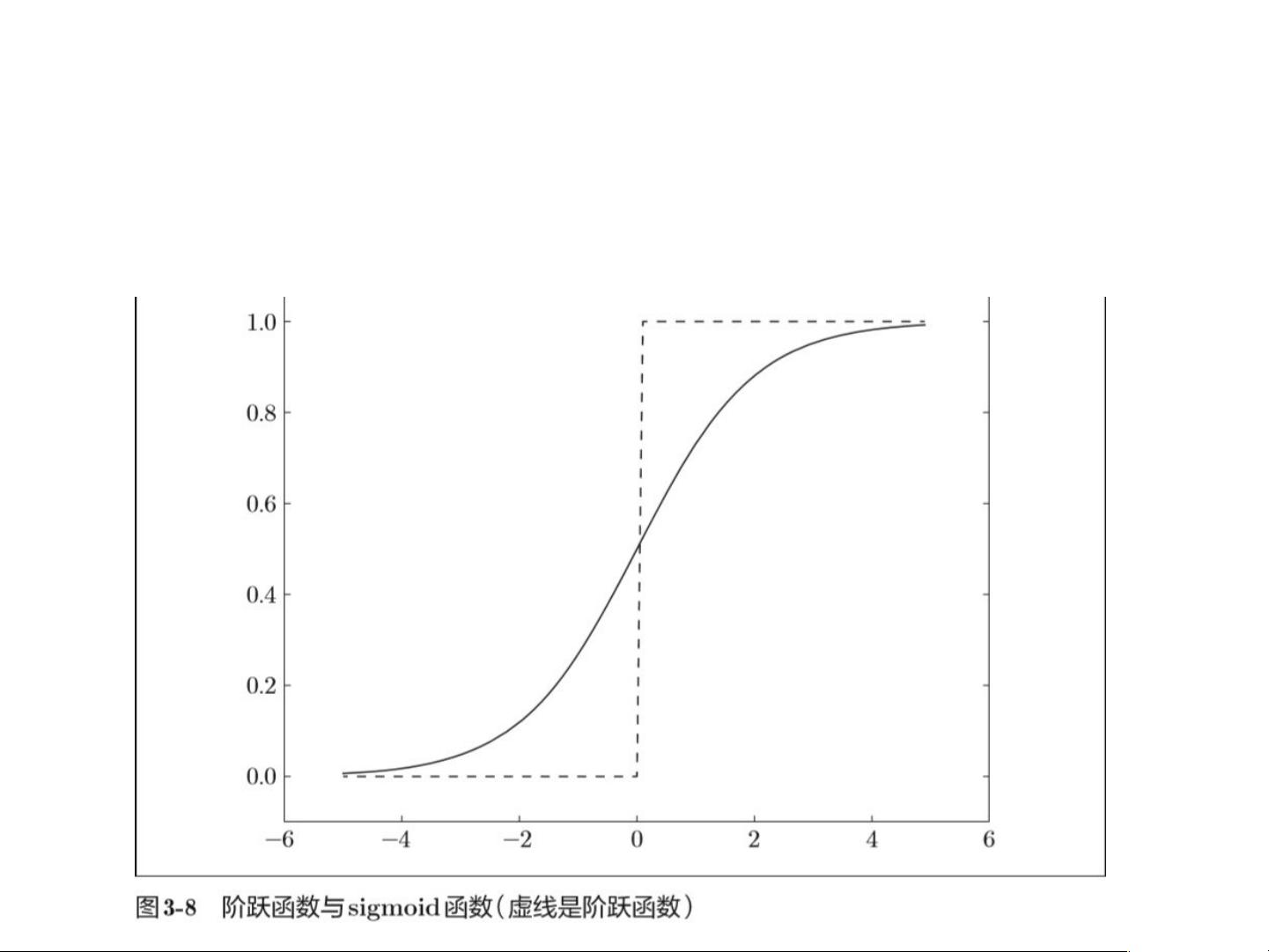

激活函数在神经网络中起着至关重要的作用,它决定了神经元是否被“激活”并产生输出。阶跃函数是最简单的激活函数,但其非连续性和不连续导数限制了其在神经网络中的应用。sigmoid函数则是一种更优的选择,它具有平滑的连续曲线,可以输出0到1之间的任意实数值,这使得神经网络能够更好地拟合复杂的非线性关系。sigmoid函数的形式为1/(1+e^(-x)),其特性是输入小时输出接近0,输入大时输出接近1,这使得它成为早期神经网络常用的激活函数。

然而,sigmoid函数在深度神经网络中存在梯度消失的问题,因此后来出现了ReLU(Rectified Linear Unit)函数,它在x>0时直接输出x,而在x≤0时输出0。ReLU函数解决了sigmoid和tanh函数在负区的梯度消失问题,极大地提升了深层神经网络的训练效率。

在神经网络的结构中,权重和偏置是关键参数。权重决定了输入信号对神经元输出的影响程度,而偏置则可以调整神经元的激活阈值。在实际计算中,权重通常通过反向传播算法进行学习和更新,以优化网络性能。例如,在Python中,我们可以使用`np.dot()`函数进行矩阵乘法来计算神经网络中各层之间的加权和,加上偏置项(B)后,通过激活函数转化为最终的输出。

总结来说,神经网络的运作机制基于感知机模型,通过激活函数将线性组合转换为非线性决策边界,权重和偏置则负责调整网络的适应性。随着深度学习的发展,神经网络的设计和优化变得更加复杂,但其基本原理依然源于这些基础知识。理解这些概念是深入学习神经网络理论和实践的基础。

2022-07-13 上传

2010-12-10 上传

2022-10-22 上传

2023-05-21 上传

2024-06-23 上传

2023-05-10 上传

2023-05-05 上传

2023-05-26 上传

2023-06-07 上传

水查男

- 粉丝: 0

- 资源: 1

最新资源

- Python中快速友好的MessagePack序列化库msgspec

- 大学生社团管理系统设计与实现

- 基于Netbeans和JavaFX的宿舍管理系统开发与实践

- NodeJS打造Discord机器人:kazzcord功能全解析

- 小学教学与管理一体化:校务管理系统v***

- AppDeploy neXtGen:无需代理的Windows AD集成软件自动分发

- 基于SSM和JSP技术的网上商城系统开发

- 探索ANOIRA16的GitHub托管测试网站之路

- 语音性别识别:机器学习模型的精确度提升策略

- 利用MATLAB代码让古董486电脑焕发新生

- Erlang VM上的分布式生命游戏实现与Elixir设计

- 一键下载管理 - Go to Downloads-crx插件

- Java SSM框架开发的客户关系管理系统

- 使用SQL数据库和Django开发应用程序指南

- Spring Security实战指南:详细示例与应用

- Quarkus项目测试展示柜:Cucumber与FitNesse实践