新手指南:三主机Hadoop分布式集群详尽搭建

需积分: 50 16 浏览量

更新于2024-07-18

3

收藏 1.19MB DOCX 举报

本文档详细介绍了如何搭建一个完整的Hadoop分布式集群,特别针对初学者设计,强调了在构建之前对Linux服务器(这里推荐的是Server版)的准备工作。首先,你需要准备三台主机,分别命名为masterslave1和slave2,并确保它们都已经安装了Linux系统,且用户名和密码统一设置为hadoop。推荐使用IP地址192.168.0.132、192.168.0.131和192.168.0.138。

在搭建过程中,关键步骤包括:

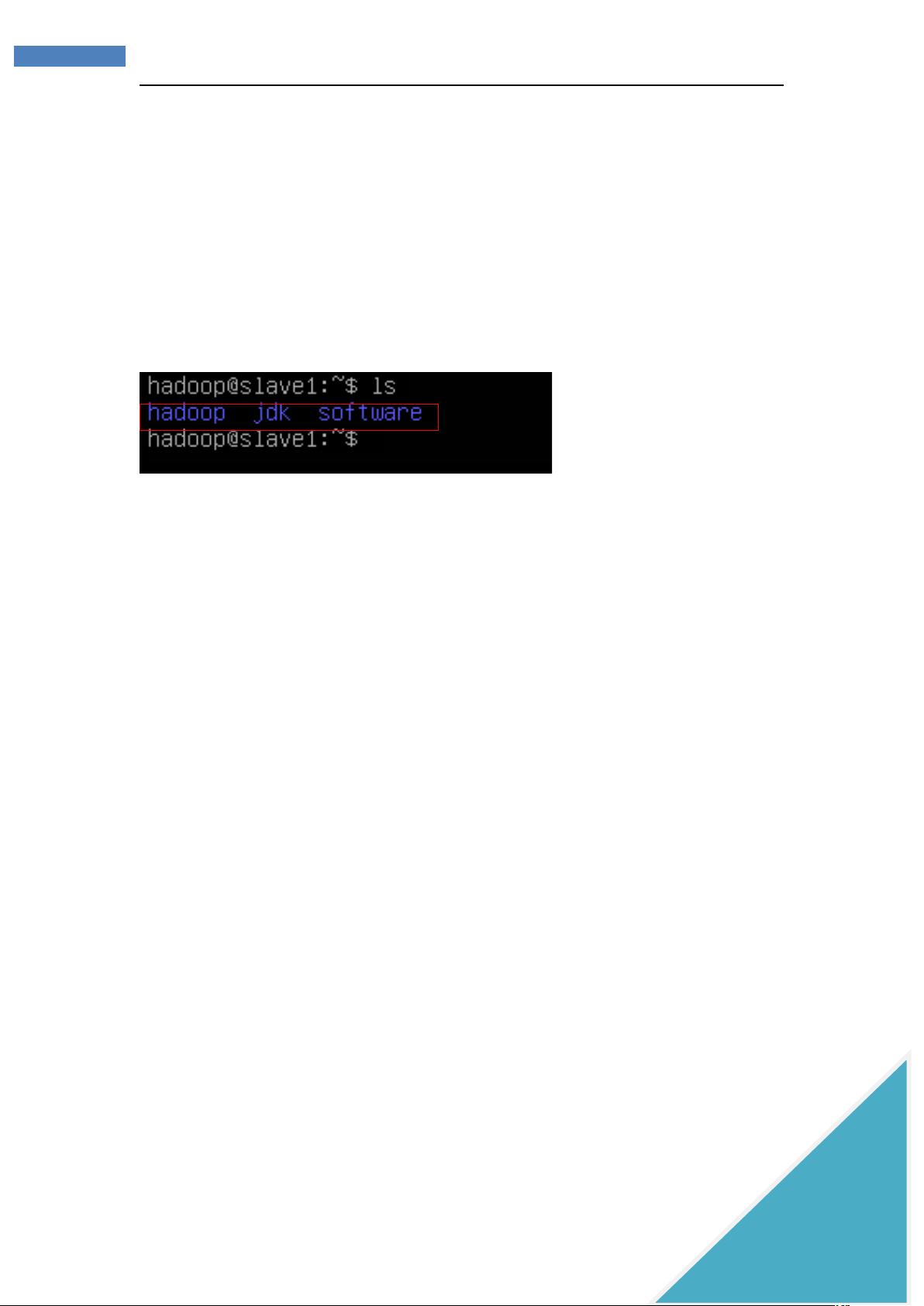

1. **前期软件准备与配置环境变量**:选择其中一台主机(如slave1)作为操作中心,因为后续需要将配置复制到其他主机,以保持一致性。在Linux环境中,理解文件路径至关重要,区分绝对路径(如 `/home/hadoop/hadoop/etc/sbin`)和相对路径(如 `/hadoop/etc/sbin`)有助于正确管理文件。

2. **拷贝压缩包**:由于新搭建的Ubuntu-server虚拟机尚未安装Java和Hadoop,需要从Windows机器上将这些环境文件通过SSH Secure File Transfer Client传输到Linux主机。在这个步骤中,用户需要输入主机IP地址、用户名(hadoop)以及密码(同样为hadoop)以建立连接,然后将文件拖拽至Ubuntu-server的目录。

3. **安装Java和Hadoop**:在Linux主机上,你需要安装Java环境,并根据官方文档或特定版本的要求安装Hadoop。这通常包括下载Hadoop的tarball,解压,配置环境变量,添加到系统路径,以及配置Hadoop配置文件(如core-site.xml, hdfs-site.xml, yarn-site.xml等)。

4. **配置Hadoop集群**:配置Hadoop集群涉及多个步骤,如启动守护进程(如namenode, datanode, secondary namenode, resource manager, nodemanager),以及配置HDFS和YARN等服务的参数。此外,还需要设置Hadoop的副本策略和容错机制。

5. **测试和验证**:最后,你需要运行Hadoop的命令行工具(如`hadoop fs -ls`或`hadoop job -list`)来检查集群是否正常工作,以及数据是否能被正确处理。

在整个过程中,要注意不同实验环境下可能需要根据实际情况调整配置参数,确保网络连通性、磁盘空间和权限设置等。如果有需要安装Linux系统的详细教程,作者提供了免费资源的联系方式,以便于读者获取帮助。

总结起来,本文提供了一个详尽的Hadoop分布式集群搭建指南,不仅涵盖了理论知识,还包含实用的实践步骤,对于新手学习大数据处理平台的搭建具有很高的参考价值。

741 浏览量

132 浏览量

120 浏览量

207 浏览量

267 浏览量

2024-12-29 上传

IMRE

- 粉丝: 4

最新资源

- 隐私数据清洗工具Java代码实践教程

- UML与.NET设计模式详细教程

- 多技术领域综合企业官网开发源代码包及使用指南

- C++实现简易HTTP服务端及文件处理

- 深入解析iOS TextKit图文混排技术

- Android设备间Wifi文件传输功能的实现

- ExcellenceSoft热键工具:自定义Windows快捷操作

- Ubuntu上通过脚本安装Deezer Desktop非官方指南

- CAD2007安装教程与工具包下载指南

- 如何利用Box平台和API实现代码段示例

- 揭秘SSH项目源码:实用性强,助力开发高效

- ECSHOP仿68ecshop模板开发中心:适用于2.7.3版本

- VS2012自定义图标教程与技巧

- Android新库Quiet:利用扬声器实现数据传递

- Delphi实现HTTP断点续传下载技术源码解析

- 实时情绪分析助力品牌提升与趋势追踪:交互式Web应用程序