理解决策树与随机森林:Python实现原理

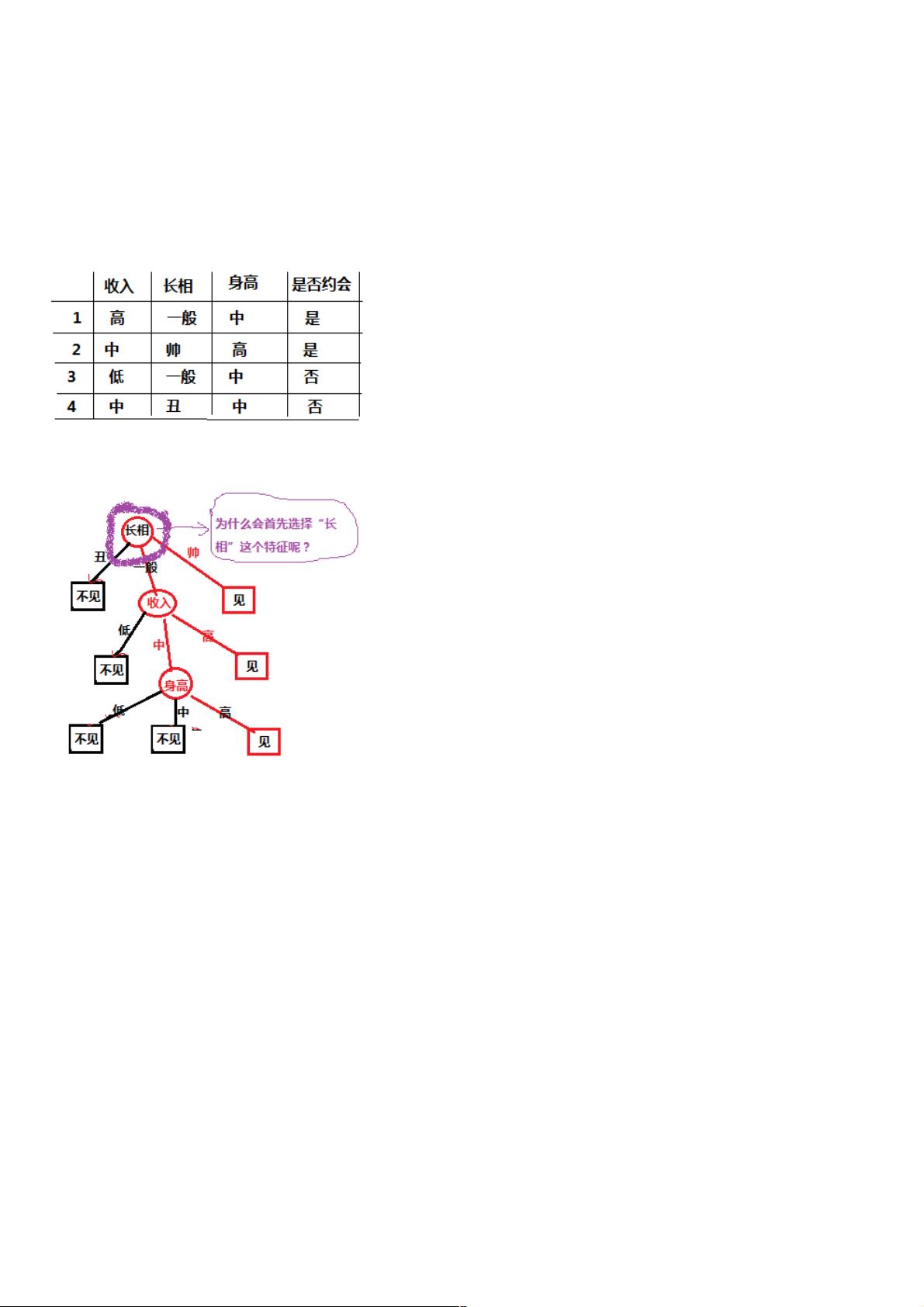

"这篇文章除了介绍决策树的基本概念,还探讨了如何在Python中实现决策树,并涉及到了信息熵和互信息等关键概念在特征选择中的应用。文章通过一个简单的约会决策树案例,解释了如何根据信息增益来决定特征的重要性。"

决策树是一种基于树形结构进行决策的机器学习算法,它通过对数据集的分析,构建出一个能够模拟决策过程的树状模型。在Python中,可以使用scikit-learn库来实现决策树。这个库提供了`DecisionTreeClassifier`和`DecisionTreeRegressor`类,分别用于分类和回归任务。

决策树的优点在于其模型易于理解,因为它们能够以人类可读的方式表示复杂的决策逻辑。此外,决策树的预测速度相对较快,构建完成后,对于新数据的预测只需沿着树结构向下走,直到到达叶子节点,这使得它在大数据集上也有较好的性能。

在构建决策树时,一个关键步骤是选择最优的特征进行划分。文章中提到了信息熵和互信息的概念,这两个概念是特征选择的理论基础。信息熵是衡量数据纯度或不确定性的一个度量,而互信息则是衡量两个随机变量之间相关性的度量。

在决策树中,通常使用信息增益来选择最佳特征。信息增益是父节点的信息熵减去所有子节点的信息熵的加权平均,它反映了通过选择某个特征进行划分,可以减少类别不确定性(即信息熵)的程度。信息增益大的特征意味着它能更有效地将数据集划分为更纯净的子集,因此,选择信息增益最高的特征作为划分标准,可以使决策树的学习效果更好。

在实际操作中,Python的scikit-learn库使用了一种叫做基尼不纯度(Gini Impurity)的替代方法来选择特征,因为信息增益可能会偏向于选择具有更多取值的特征。基尼不纯度也是一种度量数据集纯度的方式,计算方式与信息熵略有不同,但它同样可以指导特征的选择。

随机森林(Random Forest)是决策树的集成学习版本,它构建了多个决策树并取它们的平均结果作为最终预测。随机森林在每次构建树时会随机选择一部分特征,并从随机抽取的子样本中构建子树,这增加了模型的多样性和鲁棒性,降低了过拟合的风险。

在Python中,使用scikit-learn的`RandomForestClassifier`或`RandomForestRegressor`可以实现随机森林。通过调整参数,如树的数量、特征抽取的比例等,可以优化随机森林的性能。

总结来说,理解和掌握决策树以及随机森林的基本原理和Python实现,对于进行分类和回归任务是非常重要的。通过合理选择特征,利用信息熵、互信息和信息增益,可以构建出高效且易于解释的决策模型。同时,集成学习如随机森林可以进一步提升模型的稳定性和预测能力。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2020-09-20 上传

2021-09-29 上传

2021-09-30 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38526780

- 粉丝: 4

- 资源: 994

最新资源

- Chrome ESLint扩展:实时运行ESLint于网页脚本

- 基于 Webhook 的 redux 预处理器实现教程

- 探索国际CMS内容管理系统v1.1的新功能与应用

- 在Heroku上快速部署Directus平台的指南

- Folks Who Code官网:打造安全友好的开源环境

- React测试专用:上下文提供者组件实现指南

- RabbitMQ利用eLevelDB后端实现高效消息索引

- JavaScript双向对象引用的极简实现教程

- Bazel 0.18.1版本发布,Windows平台构建工具优化

- electron-notification-desktop:电子应用桌面通知解决方案

- 天津理工操作系统实验报告:进程与存储器管理

- 掌握webpack动态热模块替换的实现技巧

- 恶意软件ep_kaput: Etherpad插件系统破坏者

- Java实现Opus音频解码器jopus库的应用与介绍

- QString库:C语言中的高效动态字符串处理

- 微信小程序图像识别与AI功能实现源码