Eclipse中Hadoop HDFS API实验与上传操作详解

需积分: 0 108 浏览量

更新于2024-06-30

收藏 1.04MB DOCX 举报

本篇实验内容主要针对Eclipse环境下的Hadoop分布式文件系统(HDFS)编程基础操作。在Eclipse中进行Hadoop实验,首先需要搭建HDFS API编程环境,确保能够运行和演示相关的测试程序。以下是实验的关键步骤和评分标准:

1. **评分要求**:

- 教师将随机选择实验题目,要求学生在Eclipse中实际操作并解释代码。

2. **评分点一(C级)**:

- 学生需能够正确配置HDFS API环境,确保程序能够顺利执行。具体步骤包括:

- 安装必要的Hadoop库并在Eclipse项目中设置环境变量,如配置Apache Hadoop的jar包路径。

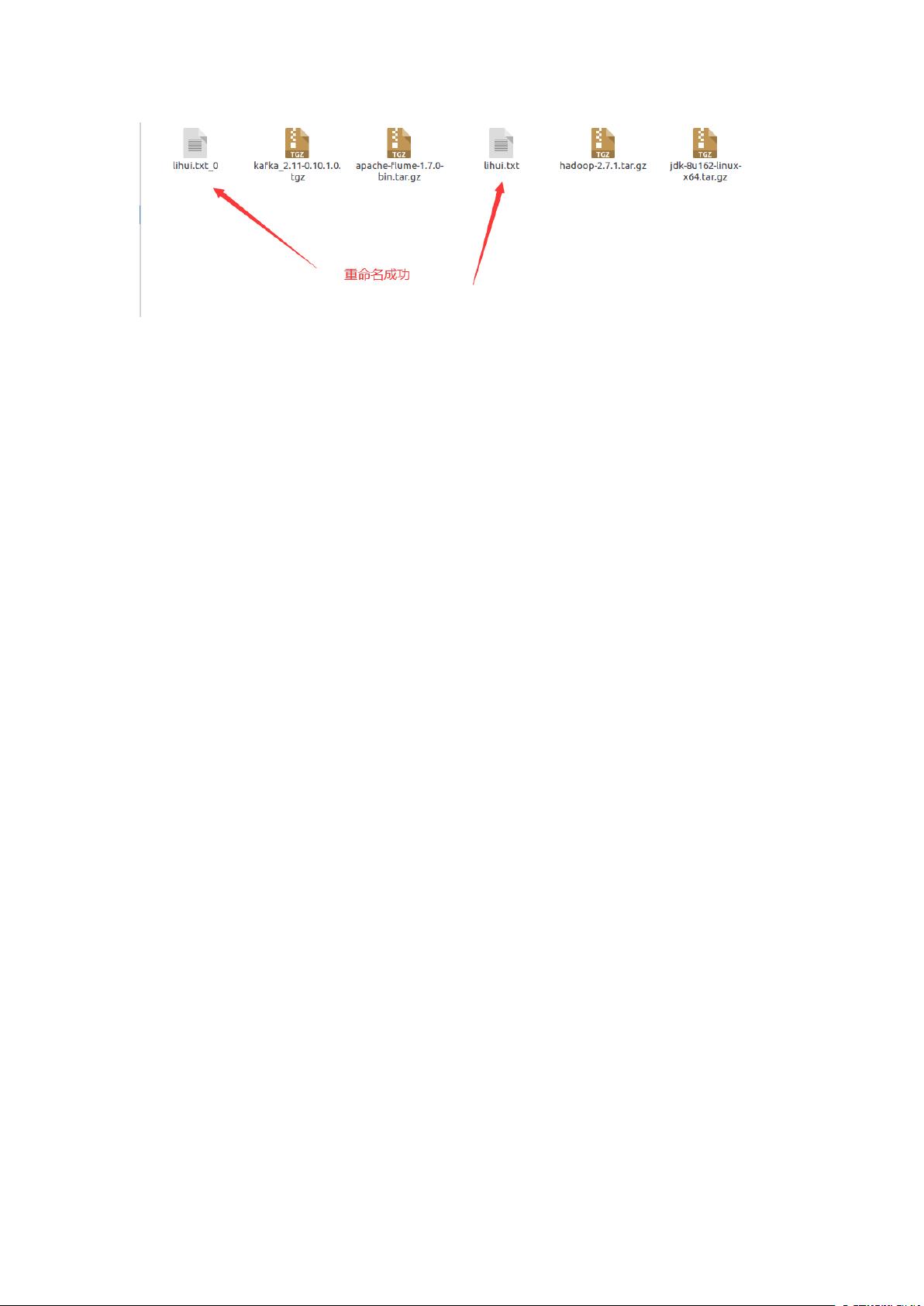

- 编写并运行名为`CopyFromLocalFile`的Java类,该类包含两个方法:`test`用于检查文件路径是否存在,以及`copyFromLocalFile`用于从本地文件系统复制文件到HDFS。在这个过程中,学生需要使用`FileSystem`、`FSDataOutputStream`等HDFS API来实现。

3. **评分点二(B/A级,四选二)**:

- 学生需进一步掌握文件操作的灵活性:

- 向HDFS中上传文本文件,如果文件已存在,允许用户选择是追加内容到文件末尾还是覆盖原有的文件。这需要对`copyFromLocalFile`方法进行扩展,通过添加一个布尔参数决定是`fs.copyFromLocalFile`的第二个参数,即`true`代表覆盖,`false`代表追加。

4. **代码示例**:

- 提供的代码片段展示了如何使用Hadoop API进行文件操作。关键部分包括使用`FileSystem.get(conf)`获取文件系统对象,然后调用`fs.exists()`检查路径,以及`fs.copyFromLocalFile()`方法进行文件复制。在实际操作时,学生需要根据教师给出的题目调整文件路径和行为。

在进行这个实验时,学生应该熟悉Hadoop API的使用,理解文件系统的基本概念,如路径、文件状态和复制机制。同时,他们还应具备基本的异常处理能力,以便在遇到IO异常时能有效调试。通过这个实验,学生将加深对Hadoop分布式文件系统在Java编程中的理解和实践能力。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-07-05 上传

2011-12-11 上传

2019-03-12 上传

2014-11-10 上传

2021-12-06 上传

2021-12-06 上传

weixin_58696462

- 粉丝: 0

- 资源: 1

最新资源

- java版商城源码-4sg:小而简单的SVGSankey生成器(使用XSLT)

- FPGA实现推箱子游戏.7z

- Single-Price-Grid-Component

- RaspberryPi 安装 WindowsArm 驱动 20200315drv_rpi4.zip

- PiperBlocklyLibrary:CircuitPython库支持使用RP Pico微控制器的块编码

- 易语言图片任意旋转源码.zip易语言项目例子源码下载

- Grades_Calc

- cschool:基本的Rails应用程序中的基本代码学校-谁想要雄心勃勃的人都可以免费打开手提袋

- 码

- data-structure

- 行业文档-设计装置-一种笔尾设置可折叠掏耳勺的方便笔.zip

- 华为简历-求职简历-word-文件-简历模版免费分享-应届生-高颜值简历模版-个人简历模版-简约大气-大学生在校生-求职-实习

- usov.tech

- 蒂莫·格拉斯特拉

- Webcam Fun +-开源

- semaphore_nuxt