Spark本地开发与调试指南

需积分: 10 31 浏览量

更新于2024-07-20

2

收藏 2.59MB PDF 举报

"Spark开发及本地环境搭建指南"

Spark是一种流行的分布式计算框架,用于大数据处理和分析。这篇指南主要涵盖了如何在本地环境中搭建Spark开发环境,并使用IDEA进行Spark项目的开发和调试。以下是对这些步骤的详细说明:

1. **构建本机开发环境**

- **操作系统选择**:推荐使用Linux发行版如CentOS、Redhat或Fedora,或者MacOS。Linux环境更适合进行开发和测试分布式系统。

- **JDK版本**:如果你打算使用PySpark(Python on Spark),则需要JDK1.6.x。不过,现代Spark版本可能需要更高版本的JDK。

- **IDEA安装**:推荐使用IntelliJ IDEA,它是一款强大的Java集成开发环境,对Spark开发有很好的支持。

- **Scala安装**:Spark主要使用Scala语言编写,因此需要安装Scala 2.10.4或更高版本。

- **Maven安装**:Maven是Java项目管理工具,用于构建和管理Spark项目。

- **Git客户端**:用于获取Spark源码,以及后续与GitHub的交互。

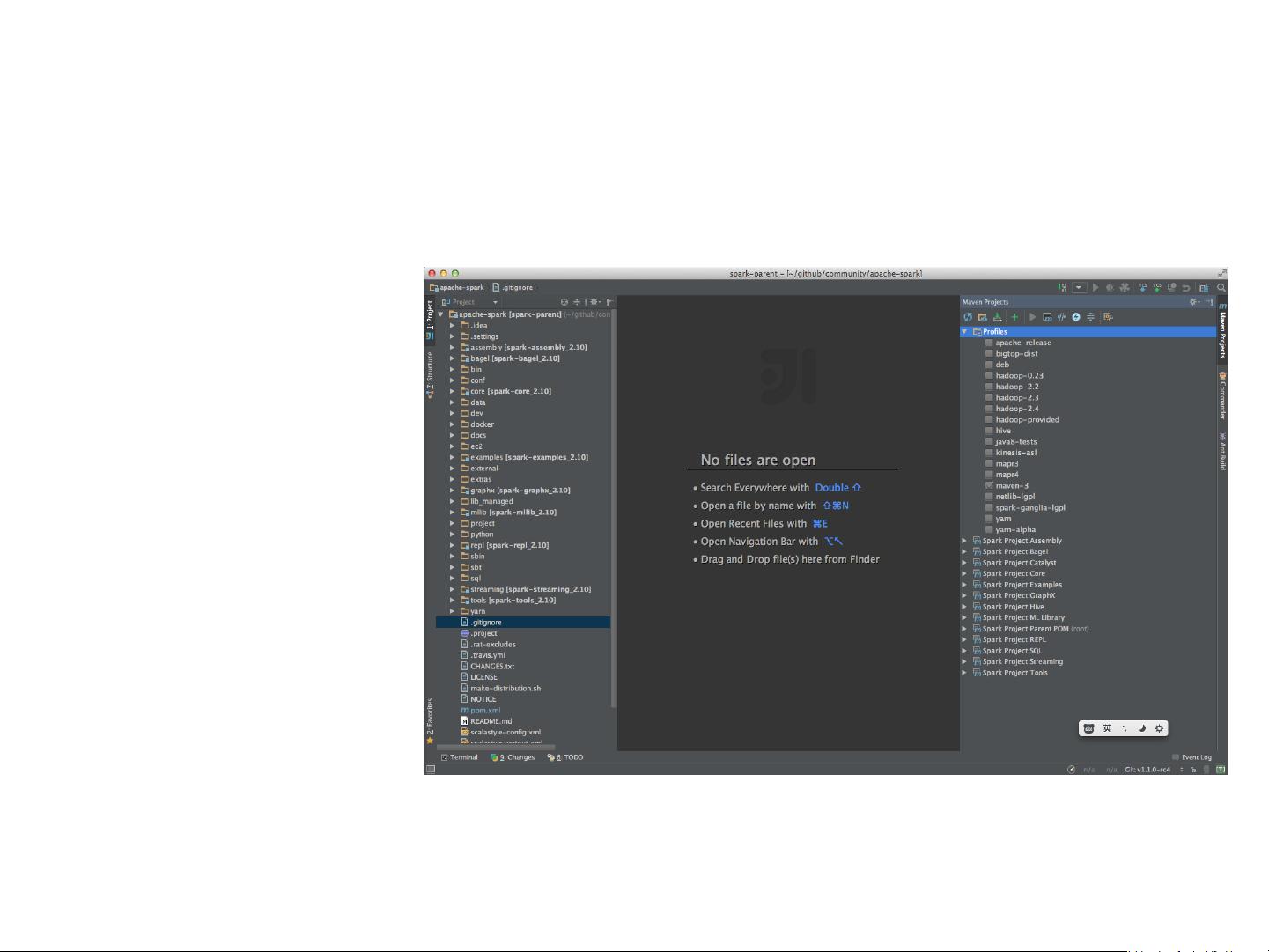

2. **导入Spark工程**

- 使用git克隆Spark的源代码仓库。

- 在IDEA中选择“Open Project”,然后导入Spark项目根目录下的`pom.xml`文件。

3. **选择项目配置**

- 根据你的需求,选择合适的Hadoop版本,这会影响到Spark运行的后端环境。

- 如果不使用Hive,可以选择不引入`spark-hive`模块。

- 若不在Yarn上运行,可以不勾选相应的配置。

- 如不需要Ganglia监控,可以删除`FlumeSink`模块的相关定义。

4. **使用Maven编译**

- Maven用于编译和打包Spark源码。编译前,可能需要解决源码中的已知问题,以便IDEA能正确编译。

5. **调试Spark应用**

- 以SparkSQL为例,打开`SparkSQLCliDriver.scala`,通过右键点击“Run…”启动调试。

- 首次启动可能会失败,需要修改VM参数,如添加`-Dspark.master=local[4]`指定本地模式,并增加`-Xmx4096m`来设定内存上限。

- 注意调试时,过多的断点会降低性能,尽量减少断点数量。

- 若要增强调试日志,可以添加`hive-log4j.properties`到类路径对应的目录。

6. **本地DEBUG环境的优势**

- 本地调试环境能够快速理解程序执行流程。

- 对于排查和修复Spark中的错误非常有帮助。

- IDEA的快捷功能可以提高开发效率,减少手动编译的次数。

7. **在GitHub上贡献代码**

- 创建GitHub账号,然后“fork”Spark的官方项目,这样你就可以在自己的GitHub仓库中进行修改。

- fork完成后,你可以将社区代码拉取到本地,进行开发和测试,然后再提交pull request到上游项目,供社区审核和合并。

通过以上步骤,开发者可以在本地环境中有效地进行Spark的开发、调试和贡献代码,这对于理解和优化Spark应用至关重要。

2020-04-01 上传

2024-07-22 上传

2023-06-28 上传

2023-06-28 上传

2023-12-22 上传

2023-06-28 上传

2023-06-06 上传

2023-09-16 上传

2023-03-16 上传

二把老骨头

- 粉丝: 80

- 资源: 293

最新资源

- 多模态联合稀疏表示在视频目标跟踪中的应用

- Kubernetes资源管控与Gardener开源软件实践解析

- MPI集群监控与负载平衡策略

- 自动化PHP安全漏洞检测:静态代码分析与数据流方法

- 青苔数据CEO程永:技术生态与阿里云开放创新

- 制造业转型: HyperX引领企业上云策略

- 赵维五分享:航空工业电子采购上云实战与运维策略

- 单片机控制的LED点阵显示屏设计及其实现

- 驻云科技李俊涛:AI驱动的云上服务新趋势与挑战

- 6LoWPAN物联网边界路由器:设计与实现

- 猩便利工程师仲小玉:Terraform云资源管理最佳实践与团队协作

- 类差分度改进的互信息特征选择提升文本分类性能

- VERITAS与阿里云合作的混合云转型与数据保护方案

- 云制造中的生产线仿真模型设计与虚拟化研究

- 汪洋在PostgresChina2018分享:高可用 PostgreSQL 工具与架构设计

- 2018 PostgresChina大会:阿里云时空引擎Ganos在PostgreSQL中的创新应用与多模型存储