深度循环网络与递归神经网络:解析长期依赖与结构优化

需积分: 0 7 浏览量

更新于2024-08-05

收藏 845KB PDF 举报

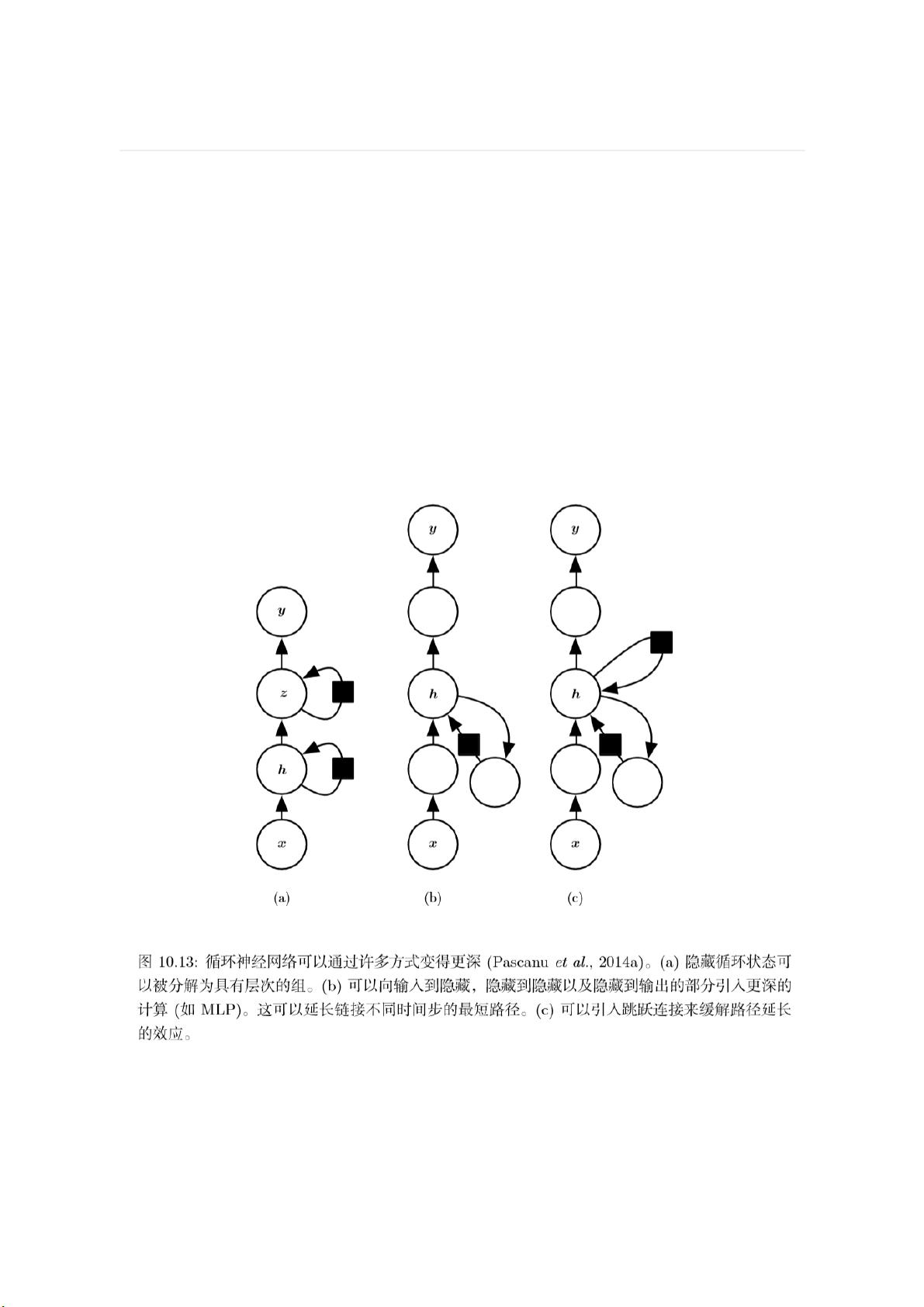

"本文主要探讨了深度循环网络(Deep Recurrent Neural Networks)和递归神经网络(Recursive Neural Networks)的概念以及它们在处理长期依赖问题上的挑战。深度循环网络通过多层结构增强表示能力,但可能面临优化难题;递归神经网络则以树状结构进行计算,尤其适用于处理结构化数据,如自然语言。然而,两者在处理长时间序列信息时,都面临梯度消失或爆炸的问题,这限制了它们对长期依赖关系的学习能力。"

深度循环网络(DRNN)是循环神经网络(RNN)的一种扩展,它通过增加网络的深度来提高模型的表达能力。DRNN通常包含三个关键变换:从输入到隐藏状态、从前一隐藏状态到下一隐藏状态,以及从隐藏状态到输出。这些变换通过权重矩阵实现,并可以通过多层感知机(MLP)来表达。虽然深度可以增加表示的复杂性,但也可能导致训练难度增加,因为深度网络往往更容易遇到梯度消失或爆炸的问题。

递归神经网络(RNNS)是一种特殊的循环网络,其结构呈树形而非链式。这使得RNNS更适合处理具有内在结构的数据,如自然语言句子,其中每个单词的含义受到上下文的影响。递归网络通过非线性操作的组合来增加深度,解决了序列长度的问题,减少了长期依赖的挑战。然而,如何有效地构建和利用树结构仍然是一个研究课题。在处理自然语言时,可以利用已知的语法分析树结构,但理想的解决方案是让网络自适应地学习输入数据的最佳结构。

长期依赖问题在循环网络中是一个核心挑战。由于信息在多个时间步中传递,经过多次函数组合后,梯度往往会逐渐消失或突然增长。这是因为循环网络的结构类似于矩阵乘法,导致特征值的幂次效应。如果特征值小于1,信息会逐渐减弱;如果大于1,则可能导致梯度爆炸。为了解决这个问题,研究人员提出了各种技术,如长短时记忆网络(LSTM)和门控循环单元(GRU),它们引入了门控机制来控制信息流,从而更好地捕获长期依赖关系。

深度循环网络和递归神经网络在处理序列数据和结构化信息方面展示了强大的潜力,但它们也面临着优化和长期依赖的难题。通过不断的研究和创新,如引入门控机制和其他结构改进,这些问题正在逐步得到缓解,使得这些网络在自然语言处理、语音识别和图像分析等领域发挥了重要作用。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-09-10 上传

2021-10-10 上传

2021-10-10 上传

2022-04-23 上传

2020-08-12 上传

2021-09-30 上传

三山卡夫卡

- 粉丝: 26

- 资源: 323

最新资源

- IBMIotForAndriod:用于 IBM IoT 的 Andriod 应用程序

- hext:HtmlAgilityPack库的扩展

- 一个非常简单的markdown文档的静态站点生成器-Node.js开发

- NanoR:R程序包用于分析和比较纳米Kong数据-开源

- FileTest,java项目源码下载,二叉平衡树Java

- 安卓Android源码——安卓Android中实现Iphone样式的AlertDialog.zip

- 打印机驱动 LJPro_MFP_M125-126_full_solution_15309

- AccessControl-4.3-cp38-cp38-win_amd64.whl.zip

- STM32F429 FreeRTOS实战:实现FreeRTOS任务运行时间统计【支持STM32F42X系列单片机】.zip

- webpack4-template:标记样板

- rmr:JavaScript JavaScriptWebGL中的音频React式视觉引擎

- pipetastic-foldl:将管道函数转换为 foldl 折叠的实验

- 箱型图,简单a星算法源码matlab,matlab源码网站

- assigment-4-源码.rar

- Python库 | gecosistema_lite-0.0.650.zip

- Accern-0.1.8-py2.py3-none-any.whl.zip