自然语言处理:近十年重大进展与未来挑战

需积分: 11 172 浏览量

更新于2024-07-18

收藏 11.48MB PDF 举报

"自然语言处理前沿:深度学习与历史演进"

这份来自2018年Deep Learning Indaba会议的报告聚焦于自然语言处理(NLP)的最新发展和重要里程碑。在南非斯泰伦博斯举行的会议上,Sebastian Ruder和Herman Kamper作为主要参与者,引领了一场关于NLP目标的深入讨论,其中包括:

1. NLP的定义及近年来的重大进展:报告回顾了NLP的历史,从2001年的神经语言模型开始,经过2008年的多任务学习、2013年的词嵌入技术,再到2013年神经网络在NLP领域的应用、2014年的序列到序列模型、2015年的注意力机制以及2015年的记忆网络。2018年的亮点是预训练语言模型的兴起,标志着一个全新的转折点。

2. NLP的核心技术突破:

- 神经语言模型:这些模型通过分析上下文预测下一个词,是基础中的基础。

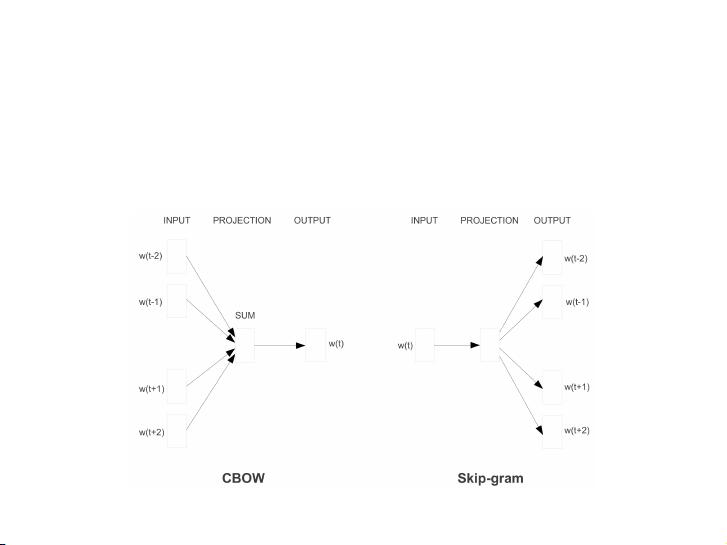

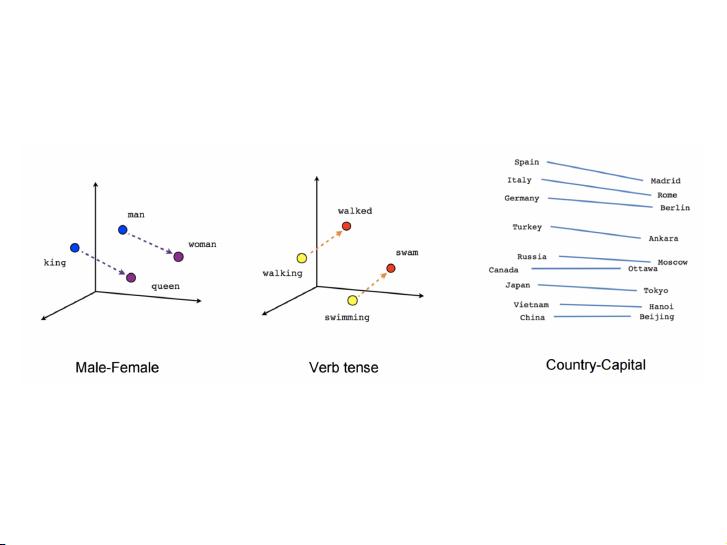

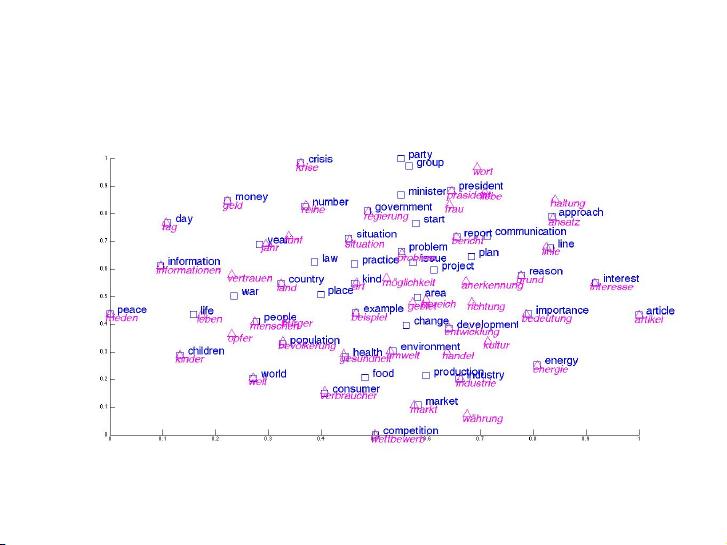

- 词嵌入:将单词转化为数值向量,便于计算机理解语义关系。

- 神经网络:如卷积神经网络(CNN)和循环神经网络(RNN),显著提高了处理自然语言的能力。

- 序列到序列模型:用于翻译、问答系统等任务,通过输入和输出序列的学习实现自动化。

- 注意力机制:允许模型在处理输入时动态聚焦关键部分,提升处理复杂序列的能力。

- 记忆网络:模拟人类记忆系统,增强了模型对长期依赖的理解。

- 预训练语言模型:如BERT、GPT等,通过大规模无监督学习预先获取大量语言知识,然后微调应用于特定任务,显著提升了NLP性能。

3. 面临的挑战与未来方向:报告也探讨了NLP领域尚未解决的关键问题,如语义理解、对话系统的真实交互性、跨语言处理等。同时,鼓励参会者了解当地社区,寻找合作机会,共同推动NLP技术的发展。

这份报告不仅梳理了NLP的历史脉络,还对未来的研究趋势提出了思考,对于理解和跟进NLP技术的最新动态具有很高的参考价值。通过学习这些发展历程,研究者和开发者可以更好地规划自己的研究路径,并在实际项目中应用这些先进的技术。

2019-01-20 上传

2017-06-09 上传

2023-04-04 上传

2023-11-18 上传

2023-09-11 上传

2024-09-01 上传

2023-03-30 上传

2023-06-08 上传

2023-10-19 上传

unmawenjia

- 粉丝: 13

- 资源: 30

最新资源

- 解决本地连接丢失无法上网的问题

- BIOS报警声音解析:故障原因与解决方法

- 广义均值移动跟踪算法在视频目标跟踪中的应用研究

- C++Builder快捷键大全:高效编程的秘密武器

- 网页制作入门:常用代码详解

- TX2440A开发板网络远程监控系统移植教程:易搭建与通用解决方案

- WebLogic10虚拟内存配置详解与优化技巧

- C#网络编程深度解析:Socket基础与应用

- 掌握Struts1:Java MVC轻量级框架详解

- 20个必备CSS代码段提升Web开发效率

- CSS样式大全:字体、文本、列表样式详解

- Proteus元件库大全:从基础到高级组件

- 74HC08芯片:高速CMOS四输入与门详细资料

- C#获取当前路径的多种方法详解

- 修复MySQL乱码问题:设置字符集为GB2312

- C语言的诞生与演进:从汇编到系统编程的革命