Tensorflow学习:dropout缓解过拟合与CNN初步理解

需积分: 0 196 浏览量

更新于2024-08-04

收藏 582KB DOCX 举报

"本周报告主要讨论了如何使用dropout方法解决Tensorflow中的过拟合问题以及对卷积神经网络(CNN)的基本概念和实现进行了初步介绍。"

在这篇周报中,王旭首先提到了在构建神经网络时,输入层的图像大小设定为32*32,这比常见的MNIST数据集的28*28图像尺寸稍大。这种设计的目的是确保潜在的图像特征,如笔画的断点或角落,能够被最高层的特征检测器有效地捕捉到。增大输入尺寸有助于网络更好地识别和学习这些关键特征。

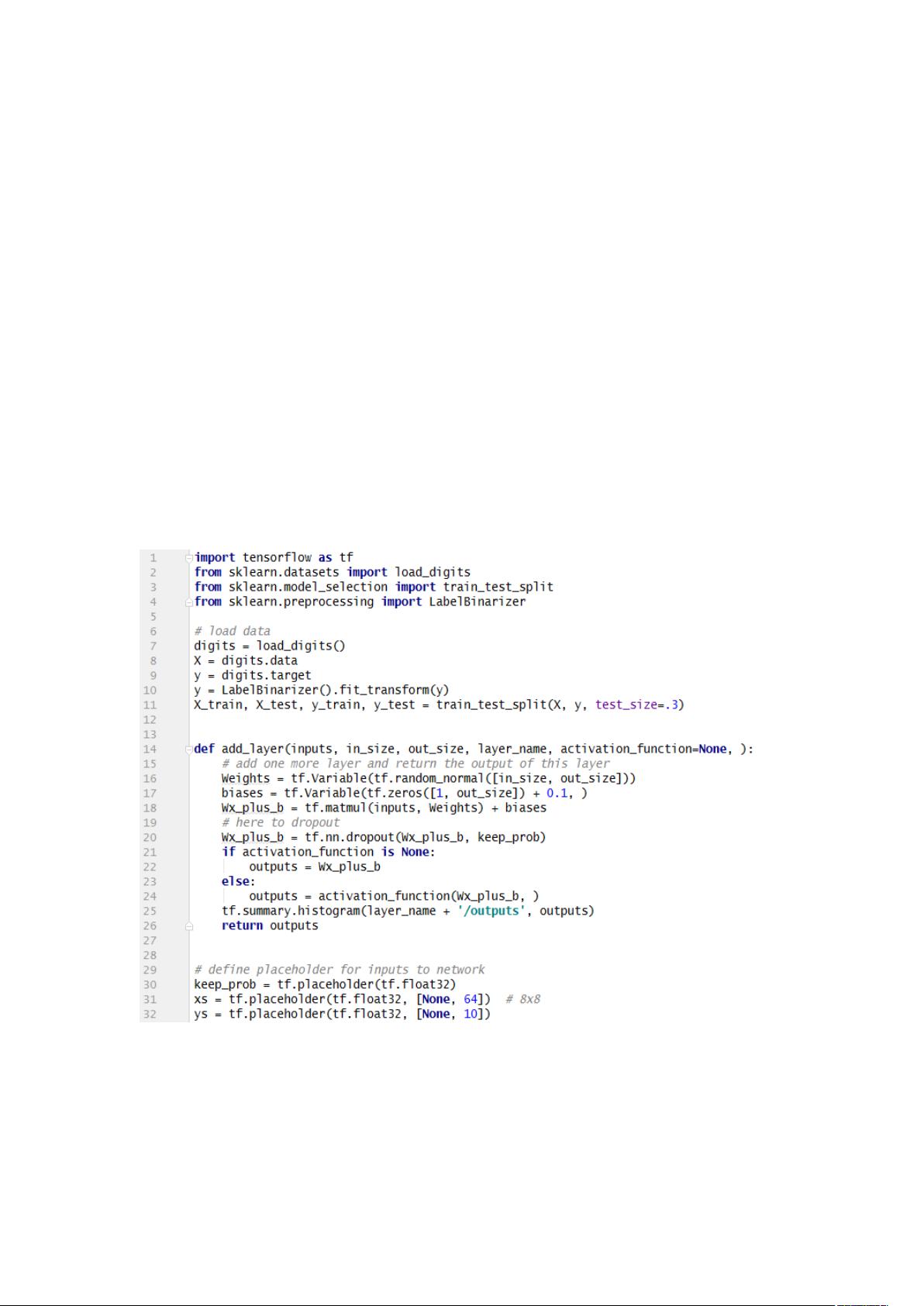

接下来,王旭介绍了如何利用dropout技术来缓解过拟合问题。Dropout是一种常用的正则化策略,它在训练过程中随机关闭部分神经元,防止模型过度依赖特定的特征。在Tensorflow中,通过定义`keep_prob=tf.placeholder(tf.float32)`来指定保留神经元的概率。例如,`keep_prob=0.7`意味着70%的神经元会被保留。运行代码后,他观察到在训练和测试数据上的损失(loss)曲线,发现经过dropout处理后,两条曲线更加接近,表明过拟合得到了改善。他还使用了Tensorboard来可视化这些结果,进一步确认了dropout的有效性。

此外,王旭简要概述了卷积神经网络(CNN)的基本构成和工作原理。CNN是一种深度学习模型,其核心特性包括局部感知和权值共享。局部感知使得网络能关注图像的局部区域,减少了需要学习的参数数量,同时增强了特征提取的能力。权值共享则是指每个卷积核内的参数在整个图像上都相同,这意味着相同的特征可以在不同位置被检测到,降低了模型复杂度,提升了训练效率。

CNN通常包含卷积层和池化层。卷积层通过卷积核对输入图像进行扫描,提取特征。卷积核的权重相当于传统神经网络的连接权重,与输入像素相乘并加上偏置,形成卷积层的输出。池化层则用于降低数据维度,常用的方法有最大池化(Max-Pooling)和均值池化(Mean-Pooling),前者选取窗口内最大值,后者取平均值,这两种方法都能在减少计算量的同时保持重要信息。

这篇周报展示了如何应用dropout解决过拟合问题,并介绍了CNN的基础知识,强调了其在图像处理中的优势。通过理解这些概念和技术,读者可以更好地理解和构建深度学习模型,尤其是针对图像识别任务的模型。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

虚伪的小白

- 粉丝: 26

- 资源: 321

最新资源

- LSketch-开源

- fable-compiler.github.io:寓言网站

- yomama:我为什么做这个

- tomcat安装及配置教程.zip

- detailed:使用 ActiveRecord 在单表和多表继承之间妥协

- nuaa-sql-bigwork-frontend::file_cabinet:NUAA 2018 数据库实验 - 学生管理系统 - 前端 - 基于 React + Antd + Electron

- CityNews:我的htmlcss研究中的另一个项目

- C64-Joystick-Adapter:一个简单的设备,可以通过USB(使用Arduino Pro Micro)将两个Commodore 64游戏杆连接到现代计算机。 总体目标是能够在模拟器中使用老式游戏杆

- pyg_lib-0.2.0+pt20cpu-cp311-cp311-linux_x86_64whl.zip

- webharas-api

- nuaa-sql-bigwork-backend::file_cabinet:NUAA 2018 数据库实验 - 学生管理系统 - 后端 - 基于 nodejs + express

- ANNOgesic-0.7.3-py3-none-any.whl.zip

- MyPullToRefresh:自己保存的下拉刷新控件

- nekomiao123:我的自述文件

- neural_stpp:用于时间戳异类数据的深度生成建模,可为多种时空域提供高保真模型

- CCeButtonST v1.2