softmax与softmax-loss:提升深度学习泛化能力的几何视角

下载需积分: 0 | PDF格式 | 2.37MB |

更新于2024-08-05

| 40 浏览量 | 举报

本文主要讨论了softmax、softmax loss以及与之相关的交叉熵损失函数在机器学习中的应用,特别是从SVM(支持向量机)的角度理解softmax loss的Max Margin概念。softmax是一种用于多分类问题的概率函数,它将神经网络的输出转换为各个类别的概率分布,使得概率总和为1。

1. **Softmax Loss理解**:

Softmax loss是一种用于多分类问题的损失函数,其目的是最小化预测概率分布与实际标签之间的差异。当考虑Max Margin时,softmax loss试图在最大化类别间的间隔(margin),就像SVM中的间隔最大化一样,但它的实现方式更为间接。softmax通过计算每个样本对所有类别的条件概率,然后基于负对数似然原则来定义损失,这使得模型倾向于将预测概率集中在正确类别上。

2. **由softmax到Softmax Loss再到Cross Entropy**:

从softmax的输出概率向量出发,转化为Softmax Loss,是通过计算每个样本的真实类别对应的预测概率的负对数,这样做的好处是可以直接优化模型参数以提高预测的准确性。而进一步到交叉熵损失(Cross Entropy),则是对Softmax Loss的一个推广,常用于深度学习中的多分类任务,因为它能够处理类别不平衡的问题,并且对梯度消失问题有所缓解。

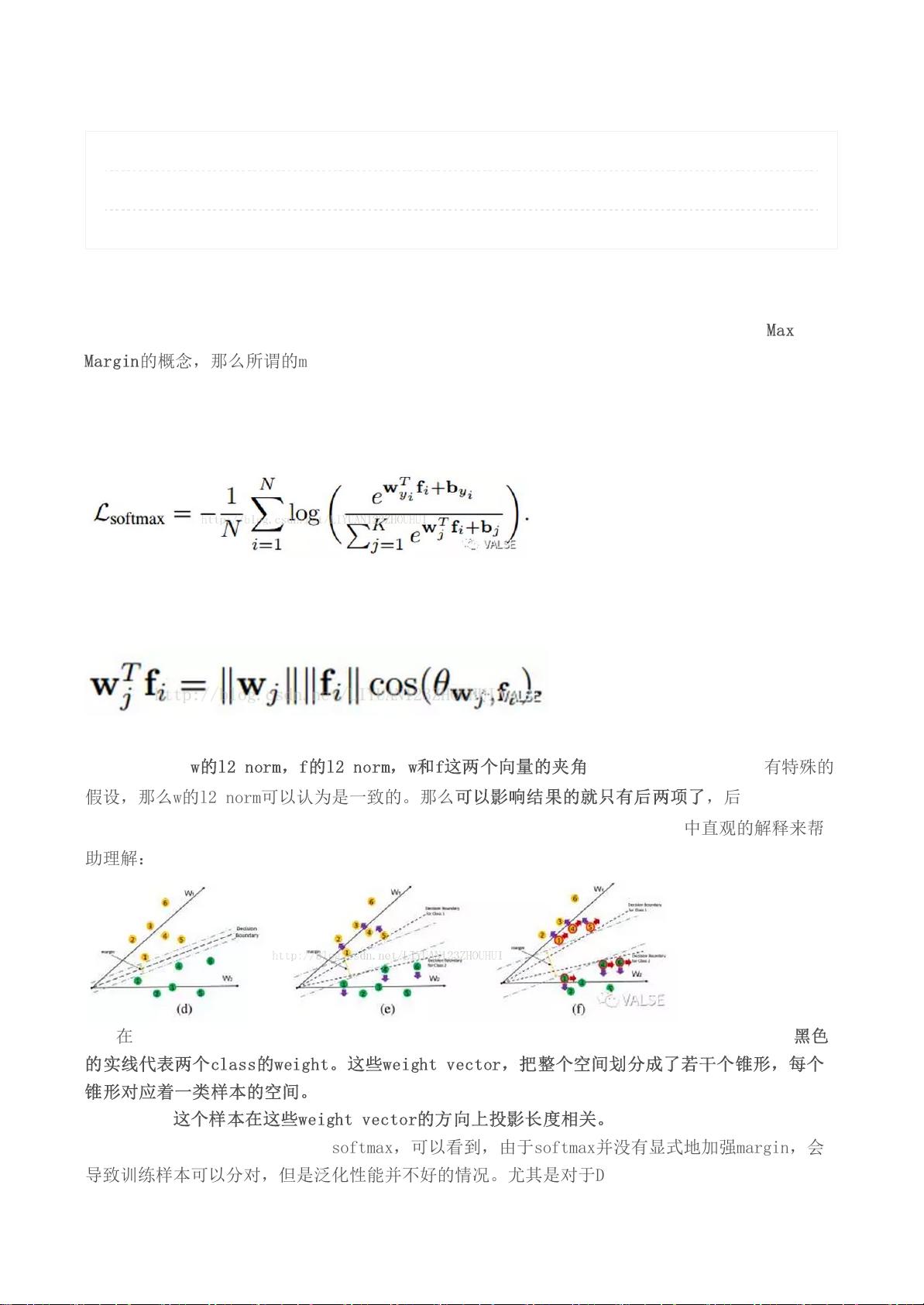

3. **几何视角下的Softmax Loss**:

在几何上,Softmax Loss可以理解为将样本点映射到高维空间中,每个类别的权重向量形成一个锥形区域,样本点落在哪个锥形内取决于其与该类权重向量的投影长度。原始的softmax可能导致决策边界不够明显,特别是在深度学习中,因为过拟合问题,很多样本的预测概率接近1,这会导致梯度更新较小,不利于模型收敛。

4. **拓展Max Margin**:

为了解决Softmax在泛化方面的不足,文章提到的主要策略有两个:一是限制特征向量(f)的L2范数,以防止过度拟合;二是通过对softmax进行改进,例如引入CenterLoss,这是一种将样本拉近其类中心的损失,从而增强样本间以及样本与类中心的距离。

总结来说,本文深入探讨了softmax loss及其与SVM中Max Margin概念的关联,并通过几何解释揭示了其在多分类问题中的作用。同时,针对softmax的局限性提出了通过调整特征向量和引入其他损失函数来扩展margin的方法,以提高模型的泛化性能。这对于理解和应用深度学习模型,特别是多分类任务中的模型优化具有重要的指导意义。

相关推荐

1142 浏览量

380 浏览量

169 浏览量

94 浏览量

82 浏览量

LauraKuang

- 粉丝: 23

- 资源: 334