Soft-Margin SVM:避免过拟合的策略

需积分: 0 46 浏览量

更新于2024-08-05

收藏 1.18MB PDF 举报

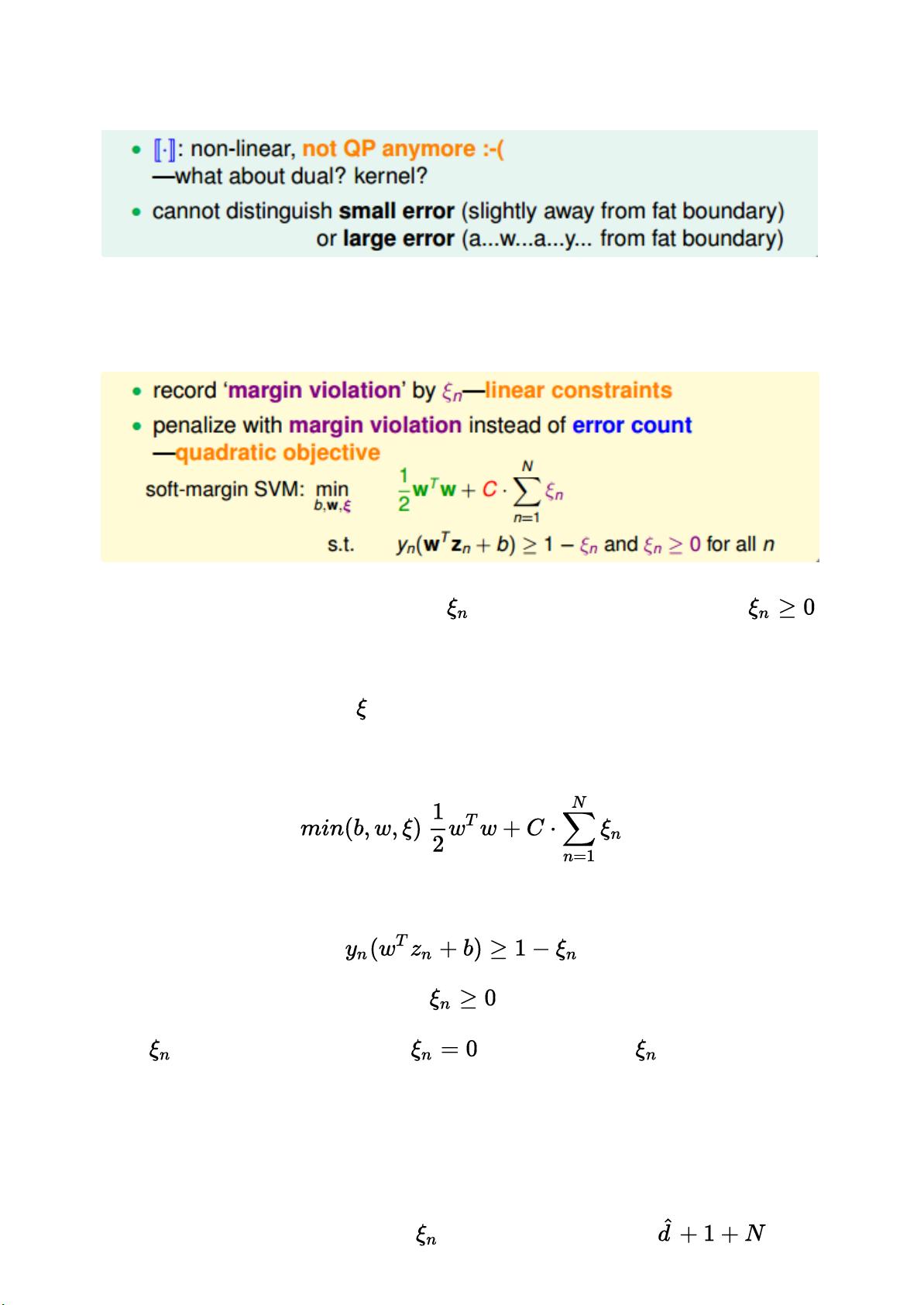

"本文是林轩田《机器学习技法》课程笔记第四部分,重点讨论了Soft-Margin Support Vector Machine (SVM)的概念和动机。笔记中指出,Hard-Margin SVM虽然能够实现完美分类,但可能导致过拟合,尤其是当样本特征过多或者模型过于复杂时。为了解决这个问题,Soft-Margin SVM被提出,它允许一定数量的样本出现分类错误,以减少模型复杂度,防止过拟合。"

在Hard-Margin SVM中,目标是找到一个能将所有训练样本完全分开的决策边界,这意味着所有的样本点都需要正确分类。然而,这种方法对数据的分布非常敏感,如果数据中存在噪声或异常点,可能导致模型过于复杂,容易发生过拟合。过拟合通常是由于模型过于强大,能完美适应训练数据,但在未见过的数据上表现不佳。

Soft-Margin SVM的引入是为了缓解这一问题。它的核心思想是在优化过程中允许一部分样本(称为“噪声点”或“误分类点”)不满足最大间隔条件,即它们可以落在决策边界的一侧。在修正后的条件中,对于正确分类的样本,依旧要求它们距离决策边界的距离(即间隔)大于等于1,而对于噪声点,则没有这样的严格限制,允许它们落在间隔内。

修正后的目标函数考虑了误分类的代价,通常引入一个惩罚项,以控制模型的复杂度。这样,Soft-Margin SVM在优化时不仅寻找最大的间隔,还试图最小化误分类的样本数量,找到一个平衡点,使得模型既有良好的泛化能力,又不至于过于简单以至于忽略数据中的重要模式。

此外,笔记中提到了核函数的选择对于SVM性能的影响。核函数可以将原始数据映射到高维空间,使得原本线性不可分的数据变得可分。常见的核函数包括线性核、多项式核和高斯核(RBF,Radial Basis Function)。选择合适的核函数是确保模型有效性和泛化能力的关键步骤。

Soft-Margin SVM通过放松Hard-Margin SVM的严格分类要求,提供了更强的鲁棒性和更好的泛化性能,特别适用于存在噪声或异常值的复杂数据集。它通过权衡分类错误的数量和间隔大小,找到了一个折衷的解决方案,有效地防止了过拟合,从而提高了模型在新数据上的预测能力。

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

点击了解资源详情

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

巧笑倩兮Evelina

- 粉丝: 26

- 资源: 335

最新资源

- StarModAPI: StarMade 模组开发的Java API工具包

- PHP疫情上报管理系统开发与数据库实现详解

- 中秋节特献:明月祝福Flash动画素材

- Java GUI界面RPi-kee_Pilot:RPi-kee专用控制工具

- 电脑端APK信息提取工具APK Messenger功能介绍

- 探索矩阵连乘算法在C++中的应用

- Airflow教程:入门到工作流程创建

- MIP在Matlab中实现黑白图像处理的开源解决方案

- 图像切割感知分组框架:Matlab中的PG-framework实现

- 计算机科学中的经典算法与应用场景解析

- MiniZinc 编译器:高效解决离散优化问题

- MATLAB工具用于测量静态接触角的开源代码解析

- Python网络服务器项目合作指南

- 使用Matlab实现基础水族馆鱼类跟踪的代码解析

- vagga:基于Rust的用户空间容器化开发工具

- PPAP: 多语言支持的PHP邮政地址解析器项目