谷歌FLAN-T5大模型:5400亿参数,1800任务实现自我改进

需积分: 1 120 浏览量

更新于2024-08-04

收藏 1.71MB PDF 举报

“谷歌FLAN-T5作者亲讲:5400亿参数,1800个任务,如何实现大语言模型‘自我改进’_鲟曦研习社.pdf”涉及的核心知识点是大语言模型的改进技术和谷歌的FLAN-T5模型。

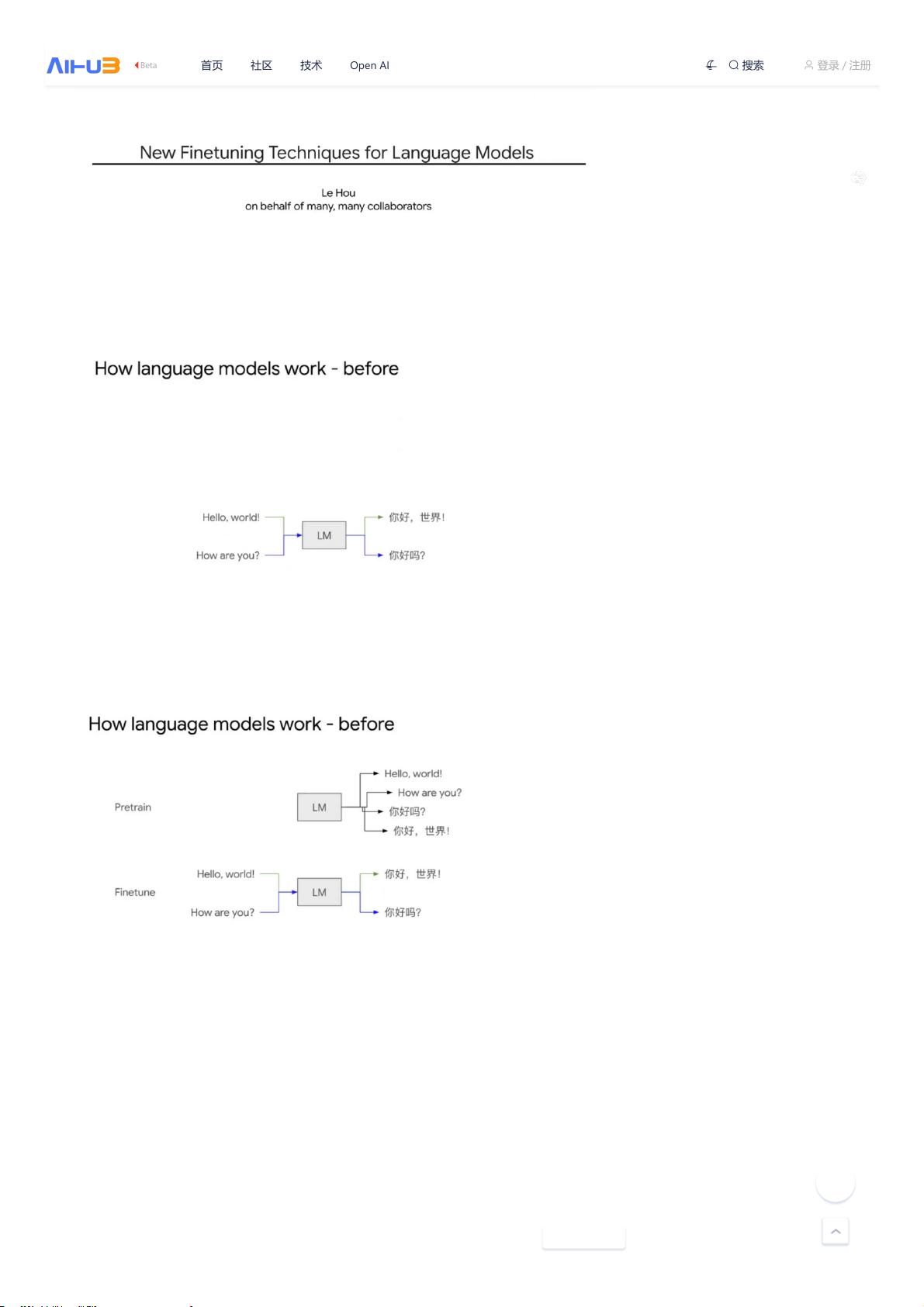

在自然语言处理领域,大语言模型如GPT系列和T5系列已经成为研究的热点,它们通过学习大量的文本数据,具备了理解和生成人类语言的强大能力。FLAN-T5是由谷歌研究团队提出的,全称为Fine-tuned Language Model with Instructions(带有指令的微调语言模型)。这个模型通过一种名为Instruction Tuning的方法,显著提高了对特定任务的理解和执行能力。与传统的预训练和微调策略不同,FLAN-T5在预训练阶段就引入了指令,使得模型在处理任务时能够更好地理解上下文和目标。

在模型参数规模上,FLAN-T5达到了惊人的5400亿(540B)参数,这是为了进一步提升模型的表达能力和泛化能力。更大的参数量通常意味着模型可以学习更复杂的语言模式和更丰富的世界知识。同时,模型被微调以应对1800多个不同的任务,这表明FLAN-T5具有广泛的适应性,能够在多种场景下表现优异。

更引人注目的是,谷歌研究者采用了Chain of Thought(CoT,思维链)这一新的Prompting机制。CoT是一种引导模型进行逐步思考的方法,它允许模型像人类一样逐步解析问题,形成逻辑链,从而更准确地解决问题,尤其在需要推理和解决复杂问题的任务中表现出色。这种“自我改进”的能力意味着模型不仅能生成语言,还能进行逻辑分析和决策,显著提升了其在认知任务上的性能。

此外,文章提到了侯乐博士,他是谷歌软件高级工程师,专注于NLP研究,特别是高效的语言模型训练、指令微调和提示工程。他的工作为改进大模型的推理能力做出了重要贡献。他在学术背景中提到的元学习和知识图谱嵌入也是NLP领域的关键研究方向,元学习旨在使模型能快速适应新任务,而知识图谱嵌入则用于将结构化知识融入到模型中,提升其理解世界的能力。

这篇资源讨论了大语言模型的最新进展,特别是FLAN-T5模型如何通过指令微调和思维链机制实现自我改进,以及研究者们如何通过这些创新方法推动大模型性能的提升。这对于理解当前AI领域的前沿趋势,以及如何利用这些技术改进人工智能系统具有重要价值。

2023-09-15 上传

2023-08-13 上传

162 浏览量

2023-05-27 上传

2023-12-19 上传

2024-07-14 上传

2023-08-30 上传

2023-09-07 上传

2023-07-27 上传

Java徐师兄

- 粉丝: 1152

- 资源: 1980

最新资源

- 解决本地连接丢失无法上网的问题

- BIOS报警声音解析:故障原因与解决方法

- 广义均值移动跟踪算法在视频目标跟踪中的应用研究

- C++Builder快捷键大全:高效编程的秘密武器

- 网页制作入门:常用代码详解

- TX2440A开发板网络远程监控系统移植教程:易搭建与通用解决方案

- WebLogic10虚拟内存配置详解与优化技巧

- C#网络编程深度解析:Socket基础与应用

- 掌握Struts1:Java MVC轻量级框架详解

- 20个必备CSS代码段提升Web开发效率

- CSS样式大全:字体、文本、列表样式详解

- Proteus元件库大全:从基础到高级组件

- 74HC08芯片:高速CMOS四输入与门详细资料

- C#获取当前路径的多种方法详解

- 修复MySQL乱码问题:设置字符集为GB2312

- C语言的诞生与演进:从汇编到系统编程的革命