EM算法详解:HMM参数估计在GMM与语音模型中的应用

需积分: 50 40 浏览量

更新于2024-07-25

1

收藏 1.47MB PDF 举报

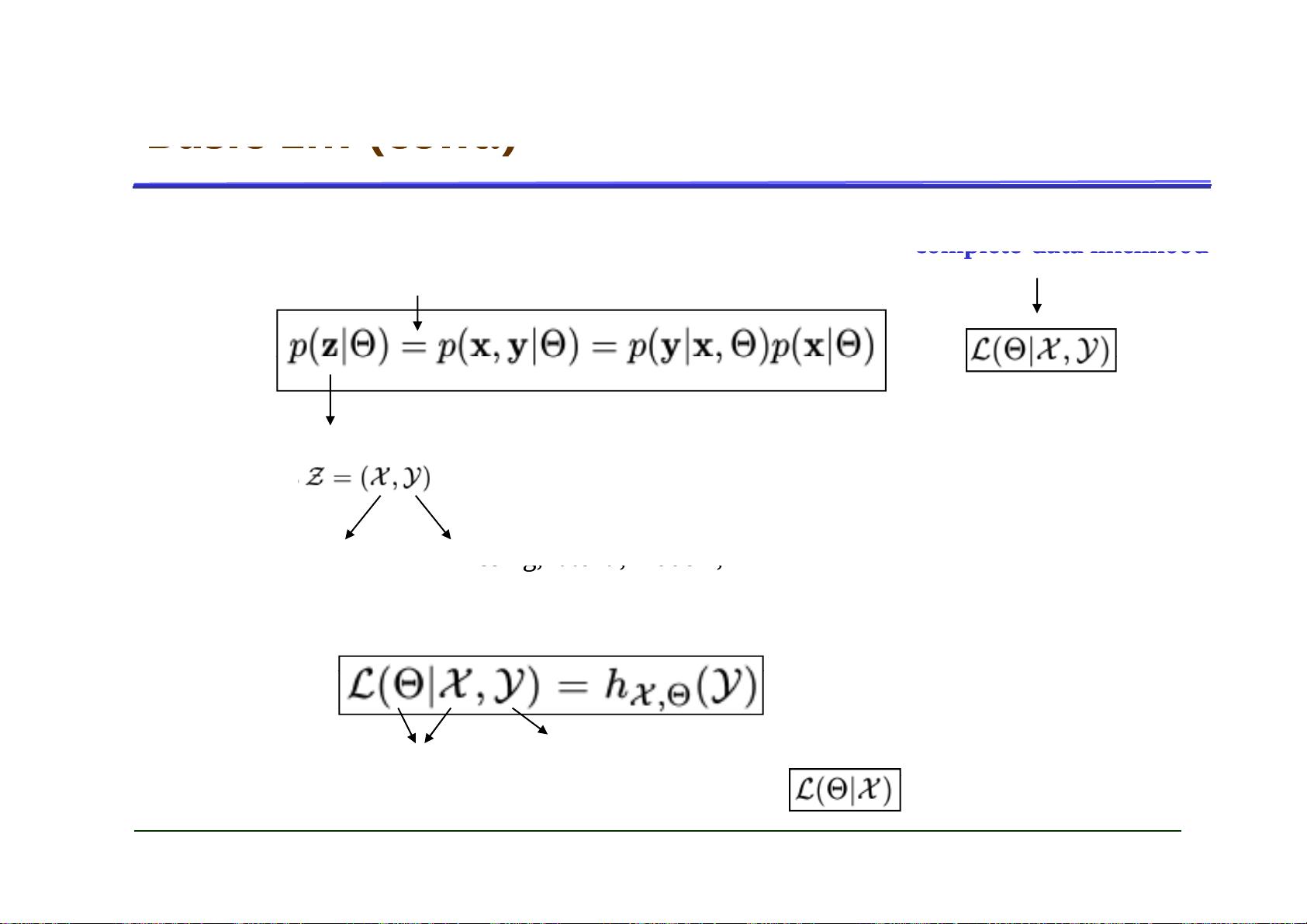

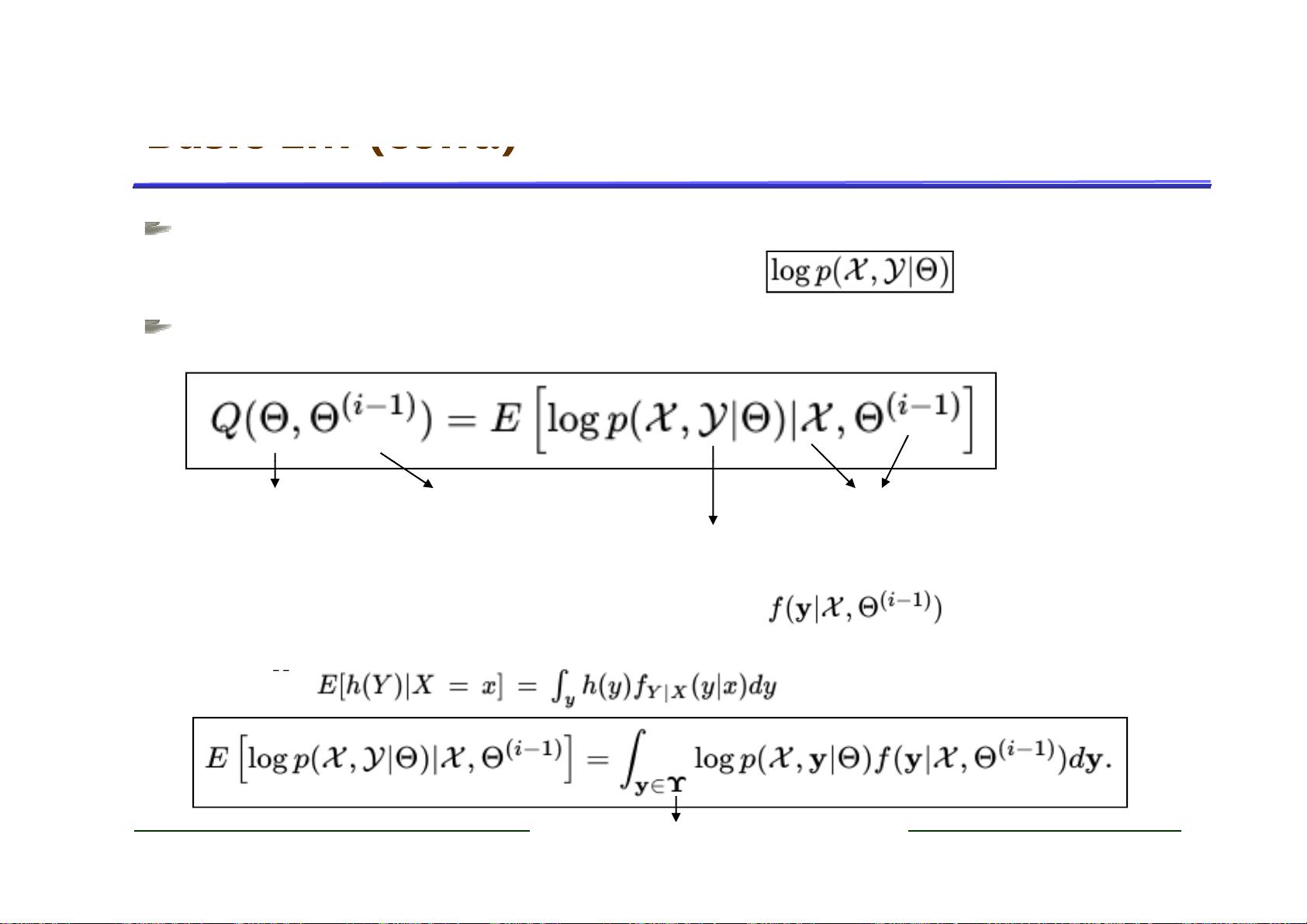

本文主要探讨了EM算法在信息技术领域的应用,特别是在隐马尔科夫模型(HMM)参数估计中的重要作用。EM算法,全称为期望最大化算法(Expectation-Maximization, EM),是一种迭代优化方法,常用于处理带有缺失数据或难以直接求解参数的复杂概率模型。该算法的核心思想是通过交替进行期望(E步)和最大化(M步)两个步骤,逐步接近模型的最大似然估计。

首先,文章回顾了极大似然估计的基本概念,这是一种常见的参数估计方法,其目标是找到能最大化数据观察概率的模型参数。然而,对于像HMM这样的模型,由于观测序列中可能存在未被观察到的状态,极大似然估计可能会遇到困难。这时,EM算法就派上了用场。

在HMM参数估计中,EM算法的应用主要体现在以下几个方面:

1. **GMM模型参数估计**:EM算法最初是用来估计高斯混合模型(GMM)的参数,当GMM作为HMM的观察模型时,可以将HMM看作GMM的一种扩展,因此,EM算法的原理可以迁移过来处理HMM参数。

2. **EM/Baum-Welch算法**:这是一个专门针对HMM设计的变种,即Baum-Welch算法,它利用EM的思想,通过迭代优化来估计HMM的初始状态概率、转移矩阵和发射概率,从而实现模型参数的精确计算和估计。这个算法在语音识别等实际应用中尤为关键,如讯飞语音实验室的研究工作中,2008年4月9日的报告中就有提及。

通过EM/Baum-Welch算法,即使面对HMM的隐藏状态问题,也能找到模型参数的最佳估计,使得模型能够更好地拟合实际观察数据,提高模型的预测和分类性能。EM算法的优点在于其适用性广,不仅适用于GMM,还能处理复杂的动态系统模型,如序列数据的建模,成为数据挖掘和机器学习领域中不可或缺的工具。

总结来说,EM算法是解决HMM参数估计问题的有效手段,其背后的理论基础和应用场景值得深入研究和理解。通过理解和掌握EM算法,科研人员和工程师可以在语音识别、自然语言处理、生物信息学等多个领域提升模型的性能,推动科技进步。

2021-05-26 上传

2013-06-15 上传

2022-09-14 上传

点击了解资源详情

点击了解资源详情

2022-09-21 上传

点击了解资源详情

jeschur

- 粉丝: 0

- 资源: 7

最新资源

- SSM Java项目:StudentInfo 数据管理与可视化分析

- pyedgar:Python库简化EDGAR数据交互与文档下载

- Node.js环境下wfdb文件解码与实时数据处理

- phpcms v2.2企业级网站管理系统发布

- 美团饿了么优惠券推广工具-uniapp源码

- 基于红外传感器的会议室实时占用率测量系统

- DenseNet-201预训练模型:图像分类的深度学习工具箱

- Java实现和弦移调工具:Transposer-java

- phpMyFAQ 2.5.1 Beta多国语言版:技术项目源码共享平台

- Python自动化源码实现便捷自动下单功能

- Android天气预报应用:查看多城市详细天气信息

- PHPTML类:简化HTML页面创建的PHP开源工具

- Biovec在蛋白质分析中的应用:预测、结构和可视化

- EfficientNet-b0深度学习工具箱模型在MATLAB中的应用

- 2024年河北省技能大赛数字化设计开发样题解析

- 笔记本USB加湿器:便携式设计解决方案