Hadoop环境下的Hive安装步骤详解

需积分: 0 25 浏览量

更新于2024-08-03

收藏 275KB PDF 举报

在Hadoop环境搭建过程中,安装Hive是一个关键步骤。以下是详细的安装步骤:

1. **安装前提**:确保Hadoop集群已安装,并且集群内已配置了MySQL数据库。这是因为Hive依赖于Hadoop作为数据存储和处理平台,同时它也需要与数据库交互来存储和管理元数据。

2. **上传安装包**:将Hive的安装包(如Apache Hive 3.1.2-bin.tar.gz)上传到服务器的指定目录,例如`/opt/software/`,然后创建一个名为`/opt/jar`的文件夹,用于存放第三方库。设置`/opt/jar`的权限,以便后续操作。

3. **解压安装包**:使用`tar -zxvf`命令在指定目录(通常是`/opt/module/`)下解压Hive安装包,并将其重命名,例如`mv apache-hive-3.1.2-bin hive3.1.2`,便于管理和识别。

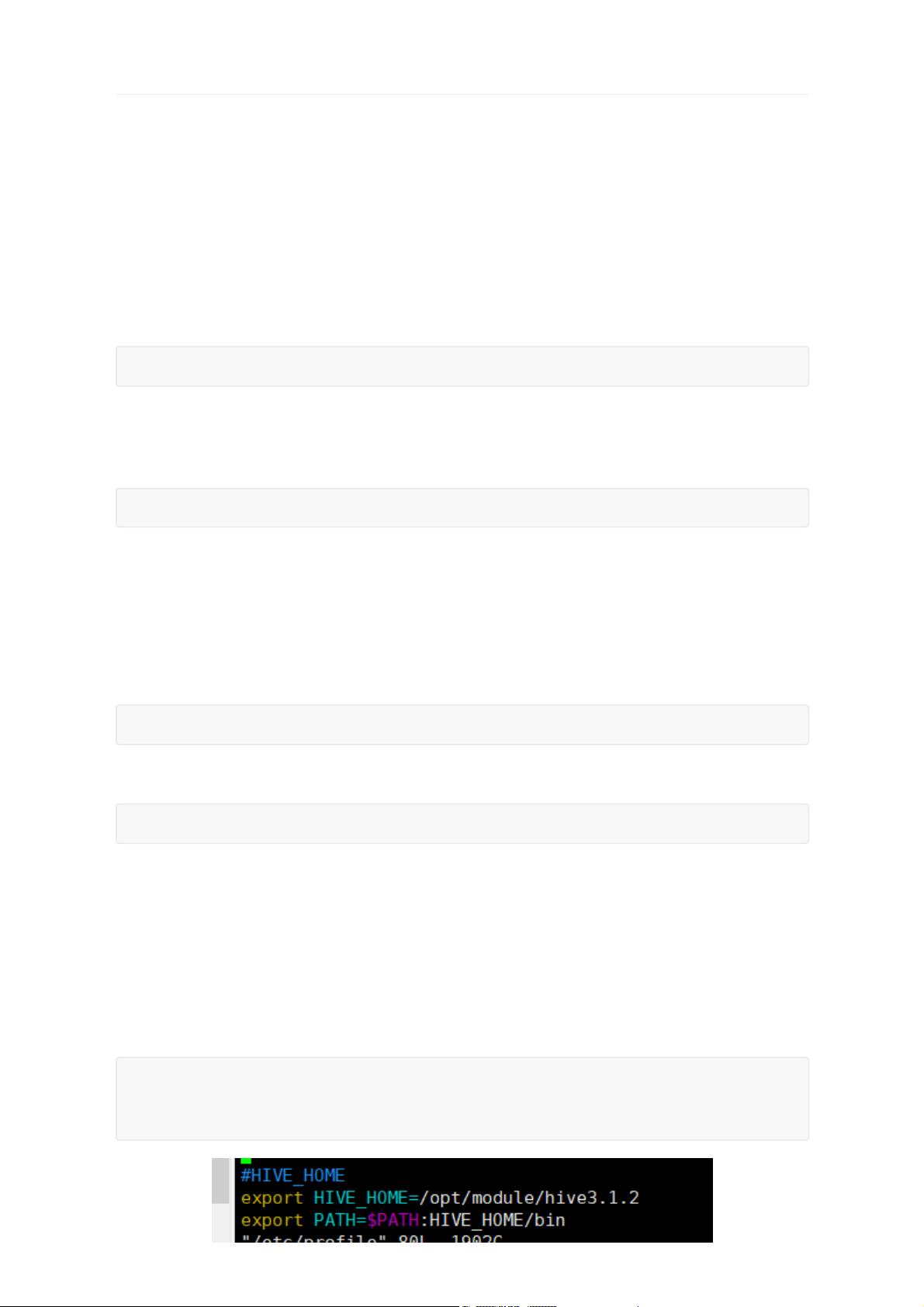

4. **配置环境变量**:

- 打开环境变量文件`/etc/profile`,添加`HIVE_HOME`指向解压后的Hive安装目录。

- 使用`chmod 777`设置`/opt/jar`的权限,以确保对jar文件的读写权限。

- 配置`PATH`环境变量,将Hive的bin目录加入其中,以便系统可以全局访问Hive命令。

5. **使环境变量生效**:通过`source /etc/profile`命令使配置立即生效,或者重启终端使更改生效。

6. **验证环境变量**:确认配置是否成功,可以通过输入`echo $HIVE_HOME`来查看Hive的安装路径,如果能正常显示路径,则说明配置已生效。

7. **配置jar包**:

- 将MySQL的JDBC驱动(如mysql-connector-java-5.1.37.jar)复制到`$HIVE_HOME/lib`目录下,解决与Hive的连接问题。

- 针对可能存在的日志jar包冲突,将`log4j-slf4j-impl-2.10.0.jar`备份并替换为Hadoop的guava版本,以避免版本不兼容导致的问题。

- 同样地,解决guava包版本冲突,将Hadoop中的guava-27.0-jre.jar拷贝到Hive的lib目录。

8. **修改Hive配置文件**:这一步涉及到了Hive的配置细节,通常涉及到核心的`hive-site.xml`文件,你需要根据具体的业务需求和环境配置参数,如数据库连接信息、Hive的元数据存储位置等。

总结来说,Hive在Hadoop环境下的安装是一个细致的过程,包括上传安装包、配置环境变量、管理jar包依赖,以及根据具体需求调整Hive的配置。每个步骤都是为了确保Hive能够顺利地运行在Hadoop集群上,并与数据库交互以支持数据分析和查询。完成这些步骤后,可以初始化Hive元数据库并启动服务,从而开始使用Hive进行数据处理工作。

2020-09-17 上传

2020-09-17 上传

2020-09-17 上传

2023-06-09 上传

2023-05-29 上传

2023-06-28 上传

2023-06-09 上传

2023-06-09 上传

2023-05-24 上传

Azer-

- 粉丝: 100

- 资源: 2

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载