机器学习深入解析:EM算法与R语言实践

43 浏览量

更新于2024-06-18

收藏 1.69MB DOCX 举报

本文主要介绍了机器学习中的EM算法,包括其基本原理、与极大似然估计的关系以及在处理聚类问题中的应用,并结合一个身高数据的例子进行深入解释。此外,文章还简要提及了EM算法的收敛性及其与K均值算法的联系。

1. EM算法原理

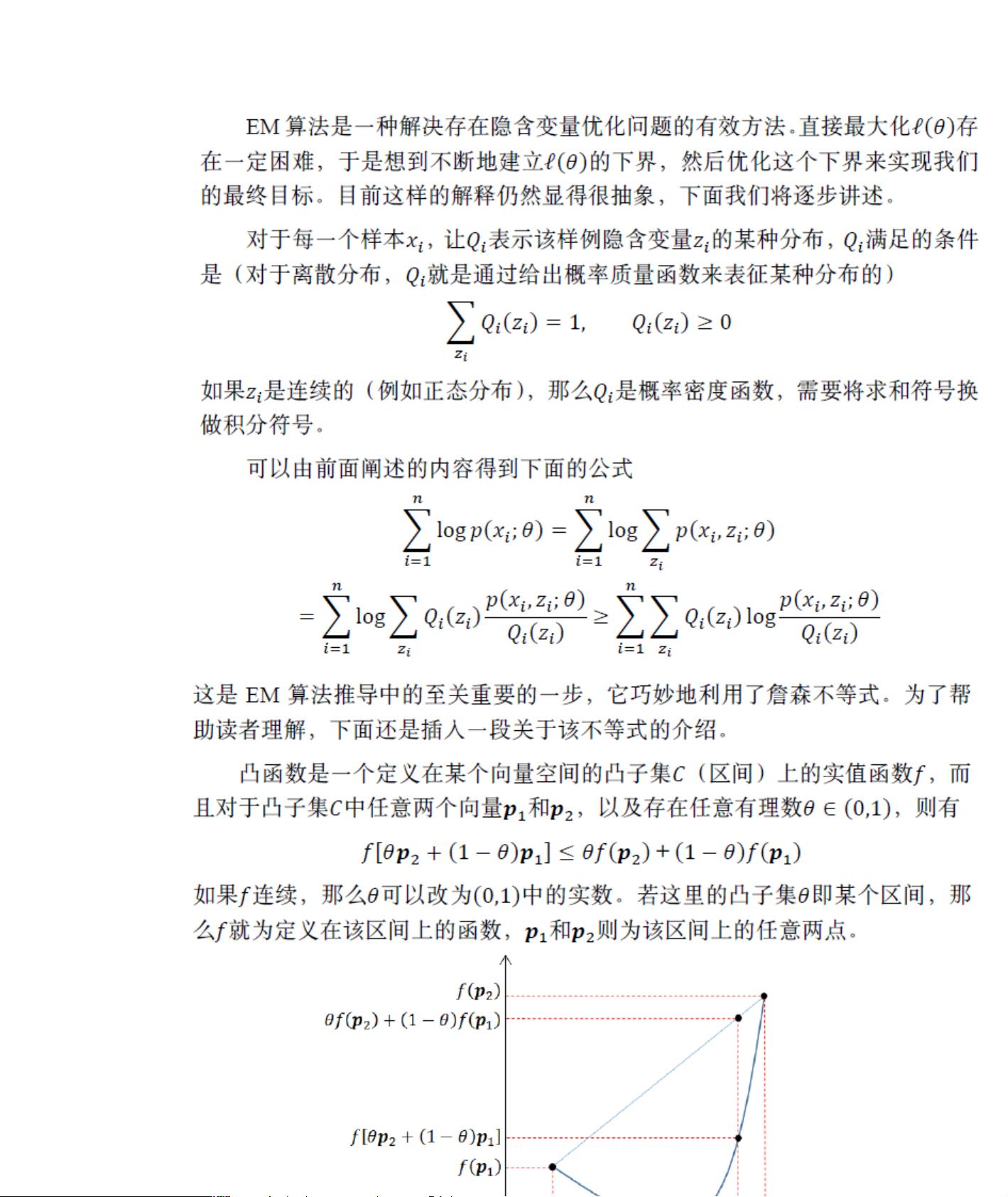

EM算法是一种用于含有隐变量的模型的最大似然估计方法。在机器学习中,当我们处理的数据存在未观测的或隐藏的变量时,EM算法可以帮助我们找到最佳的模型参数。在上述的身高例子中,男性和女性的身高分布是两个隐变量,而具体的人属于哪个性别则是需要估计的未知信息。EM算法通过交替执行E步(期望步骤)和M步(最大化步骤)来迭代优化参数。

E步:在当前参数估计的基础上,计算每个数据点属于各个类别的概率,即后验概率。

M步:利用E步得到的后验概率,重新估计模型参数,通常通过最大化似然函数来完成。

2. EM算法与K均值算法的关系

尽管K均值算法在直观上与EM算法有一定的相似性,但EM算法更为复杂且适用范围更广。K均值算法可以看作是EM算法的一个特例,其中隐变量是类别标签,而数据点属于每个类别的概率在每次迭代中被更新为0或1。EM算法则允许这些概率在[0,1]之间连续变化,使得它能处理更复杂的模型和数据结构。

3. 高斯混合模型(GMM)与EM算法

GMM是EM算法常见的应用场景,它假设数据是由多个高斯分布混合而成。在GMM中,每个数据点可能来自于一个或多个高斯分布,而每个分布对应一个类别。EM算法通过迭代更新高斯分布的均值、方差和混合系数,直至模型参数收敛。

4. 收敛性分析

EM算法的收敛性是理论研究的重点。尽管EM算法保证了目标函数(似然函数)在每一步迭代中非减,但并不保证一定能找到全局最优解。然而,在实践中,EM算法往往能给出良好的局部最优解,尤其在初始值选择得当的情况下。

5. R语言实现

文中提到的R语言实例表明,EM算法可以通过编程语言实现,对实际数据进行建模和分析。在R中,可以使用如`mclust`或`mixtools`等包来实现GMM和EM算法。

6. 应用场景

EM算法广泛应用于统计建模、聚类分析、图像识别、自然语言处理等领域。例如,它在主题模型(如LDA)中用于推断文档的主题分布;在遗传学中,用于解析基因型数据;在推荐系统中,用于混合用户和物品的隐变量。

总结,EM算法是一种强大的统计工具,尤其在处理含有隐变量的模型时,能有效地估计参数并提供有价值的洞见。通过R语言实例,学习者可以更好地理解和应用这一算法。

2024-04-17 上传

点击了解资源详情

点击了解资源详情

2020-09-21 上传

点击了解资源详情

点击了解资源详情