利用Scrapy爬取cosplay图片并保存至本地

163 浏览量

更新于2024-08-30

收藏 750KB PDF 举报

本篇文章主要介绍了如何使用Scrapy框架爬取cosplay图片并将其保存到本地文件夹的过程。Scrapy是一个强大的Python爬虫框架,适合进行高效的数据抓取。以下是详细的步骤和关键知识点:

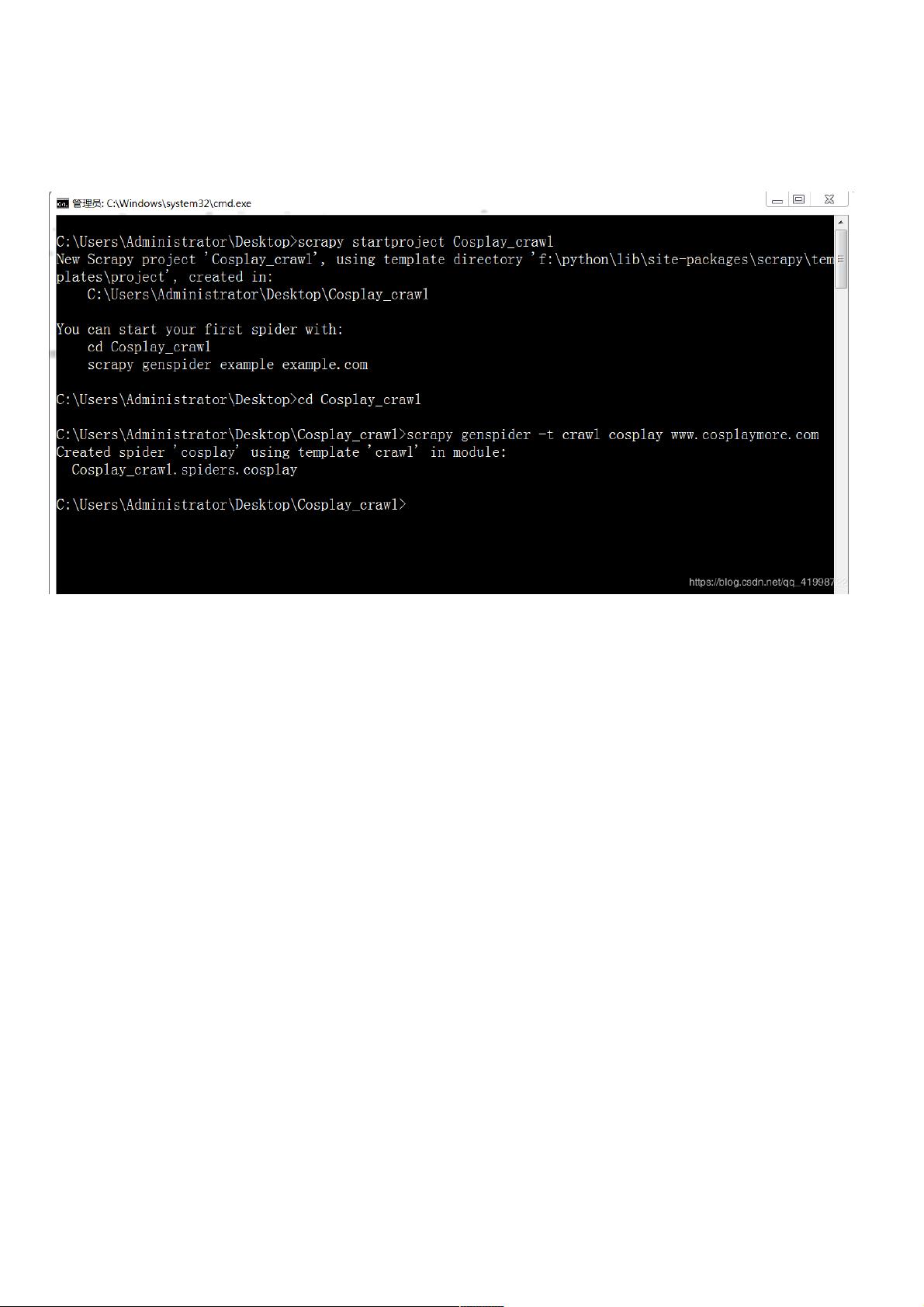

1. **新建Scrapy项目**:

首先,你需要创建一个新的Scrapy项目。在命令行中输入`scrapy startproject 项目名称`,这会自动生成一个基础的Scrapy项目结构。在这个项目中,CrawlSpider是常用的一种爬虫类型,因为它可以自动遵循网站链接。

2. **创建爬虫**:

在项目目录下,使用`scrapy genspider -t crawl 爬虫名称 域名`命令创建一个名为`CrawlSpider`的爬虫。这个命令会生成必要的文件,包括`spiders`文件夹中的`cosplay_crawl.py`,其中包含了爬虫的基本结构。

3. **设置Item**:

在`CosplayItem`类中,定义了三个字段:`title`(标题)、`information`(cosplay信息)和`pic_url`(图片URL)。这是数据抓取的基础,用于存储从网页上提取的信息。

4. **编写主爬虫**:

主爬虫`CosplayCrawlSpider`继承自`CrawlSpider`,设置了爬虫的名字、允许的域名和起始URL。`LinkExtractor`用于定义抓取规则,如允许访问特定模式的链接。这里有两条规则:一条是针对每一套图片详情页面,使用`callback='parse_picture'`来调用解析图片的函数;另一条是匹配下一页链接,使用`follow=True`表示继续追踪。

- `parse_item`函数负责处理列表页,这里选择不解析内容,因为可能不需要。

- `parse_picture`函数通过CSS选择器获取图片详情页中的图片标题和URL,并进行相应的解析和保存。

5. **运行和保存图片**:

为了将图片保存到本地,你需要在`parse_picture`函数中下载图片并决定保存的路径。这通常涉及到使用`response.request.url`获取图片URL,然后通过`response.download()`或`request.meta['download_func'](response, meta)`下载图片,并根据需要将其保存到本地指定的文件夹。

6. **注意事项**:

- 在PyCharm中运行Scrapy项目时,确保选择正确的项目路径,包括`scrapy.cfg`文件,以避免导入包错误。

- 如果遇到网络问题或反爬虫策略,可能需要调整请求头、设置延迟或使用代理IP。

- 定期更新Scrapy到最新版本,了解和应用新的特性和改进。

通过这些步骤,你可以有效地使用Scrapy爬取cosplay图片并将其组织在本地文件夹中,同时确保遵守网站的robots.txt规则,避免对目标网站造成过大负担。实践过程中,可能会遇到各种问题,但Scrapy提供了丰富的文档和社区支持,可以帮助你解决。

2017-05-28 上传

2018-11-09 上传

2018-11-09 上传

2017-08-20 上传

2018-10-16 上传

2023-08-26 上传

2023-09-23 上传

2023-05-26 上传

weixin_38720997

- 粉丝: 7

- 资源: 888

最新资源

- 全国江河水系图层shp文件包下载

- 点云二值化测试数据集的详细解读

- JDiskCat:跨平台开源磁盘目录工具

- 加密FS模块:实现动态文件加密的Node.js包

- 宠物小精灵记忆配对游戏:强化你的命名记忆

- React入门教程:创建React应用与脚本使用指南

- Linux和Unix文件标记解决方案:贝岭的matlab代码

- Unity射击游戏UI套件:支持C#与多种屏幕布局

- MapboxGL Draw自定义模式:高效切割多边形方法

- C语言课程设计:计算机程序编辑语言的应用与优势

- 吴恩达课程手写实现Python优化器和网络模型

- PFT_2019项目:ft_printf测试器的新版测试规范

- MySQL数据库备份Shell脚本使用指南

- Ohbug扩展实现屏幕录像功能

- Ember CLI 插件:ember-cli-i18n-lazy-lookup 实现高效国际化

- Wireshark网络调试工具:中文支持的网口发包与分析