MapReduce模型在日志分析中的应用实践

57 浏览量

更新于2024-07-15

收藏 417KB PDF 举报

"MapReduce编程模型在日志分析方面的应用"

MapReduce编程模型是处理大规模数据的一种有效方法,尤其适用于日志分析这样的大数据处理任务。在日志分析中,MapReduce模型能够帮助我们从海量的访问日志中提取有价值的信息,例如用户行为模式、兴趣点挖掘等,这些信息对商业智能和决策支持至关重要。

MapReduce的核心思想是将复杂的数据处理任务分解为两个主要阶段:Map阶段和Reduce阶段。Map阶段负责数据的预处理,将原始数据分割成键值对,并分配到集群的不同节点上进行并行处理。Reduce阶段则负责对Map阶段生成的中间结果进行聚合和总结,生成最终的结果。

在用户访问日志分析的例子中,Map阶段可能需要解析每个日志条目,提取关键信息,如用户ID、访问页面、访问时间等,然后将这些信息转化为键值对。例如,键可以是用户ID,值则包含该用户的访问详情。这个过程通常涉及字符串解析、正则表达式匹配等技术。

Reduce阶段则根据Map阶段生成的键值对进行聚合,例如,如果要找出每个用户的热门访问页面,Reduce函数可以对相同用户ID的页面访问记录进行汇总,统计出每个页面被访问的次数。这个阶段可以实现排序、统计、聚类等操作,进一步提炼出用户的行为特征。

在MapReduce编程中,还需要考虑一些特殊问题的处理,例如:

1. **机器学习算法**:在日志分析中,可能需要运用机器学习来预测用户行为或进行分类。Map阶段可以用来预处理数据,Reduce阶段则可以执行模型训练或预测。

2. **排序算法**:MapReduce支持基于键的排序,这对于诸如时间序列分析、Top-N查询等场景非常有用。Reduce任务接收的是已排序的键值对,可以高效地处理这些问题。

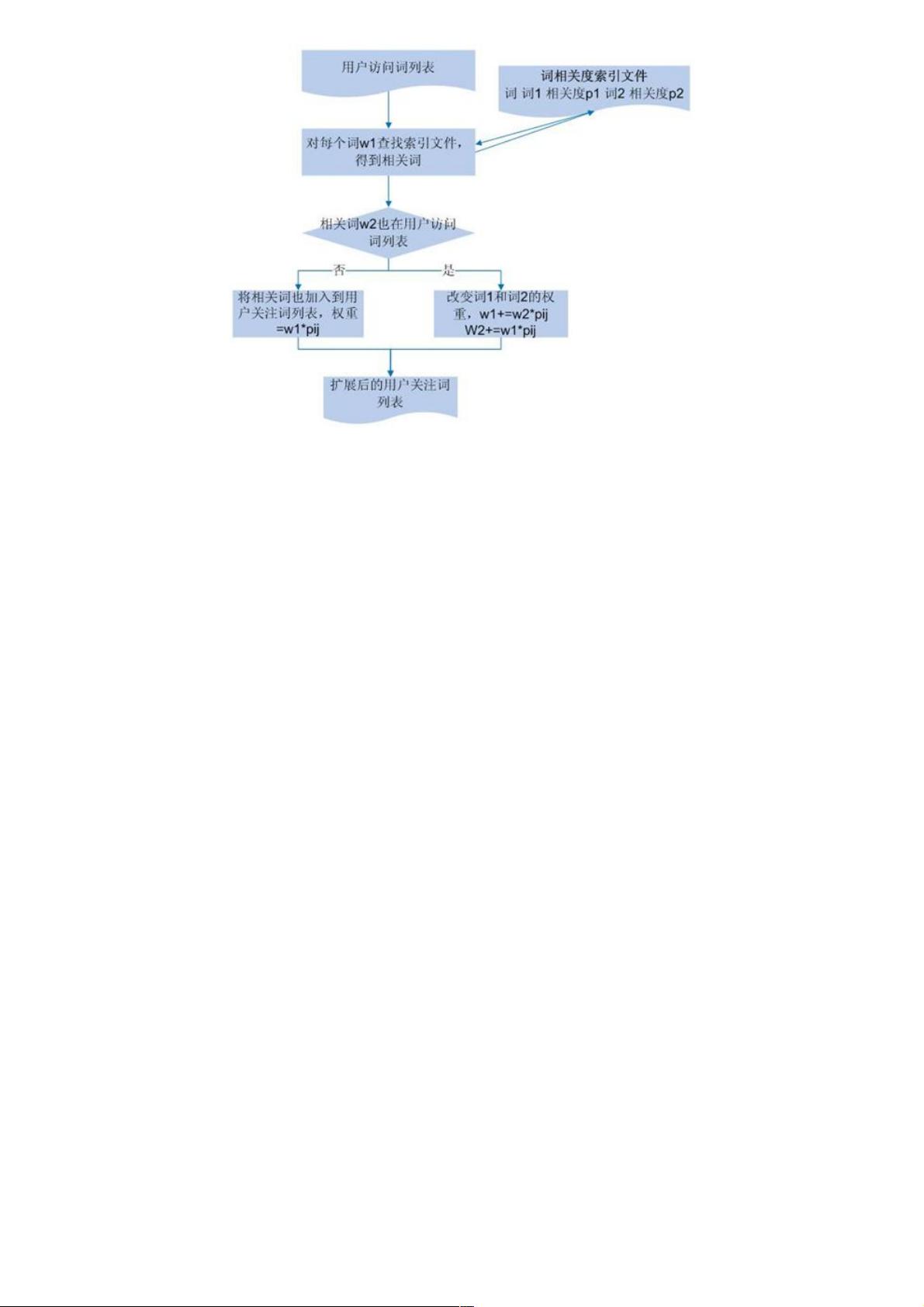

3. **索引机制**:虽然MapReduce本身不直接支持索引,但可以通过在Map阶段生成临时索引来加速特定查询,如快速查找特定用户的所有记录。

4. **连接机制**:在处理多源数据时,可以使用Shuffle阶段的分区和排序特性实现不同数据源之间的连接操作。

MapReduce模型的实现通常基于Hadoop框架,它提供了完善的容错机制和可扩展性,能够处理PB级别的数据。然而,随着数据规模的增长和需求的复杂化,出现了诸如Spark、Flink等更高效的计算框架,它们在某些场景下可以提供比MapReduce更快的计算速度和更低的延迟。

MapReduce编程模型在日志分析中的应用展示了其在处理大规模数据的强大能力,通过对日志的深入分析,我们可以洞察用户行为,优化业务策略,甚至预测未来趋势,从而提升企业的竞争力。通过学习和掌握MapReduce,开发者能够更好地应对大数据时代带来的挑战。

394 浏览量

2030 浏览量

点击了解资源详情

240 浏览量

133 浏览量

点击了解资源详情

184 浏览量

点击了解资源详情

点击了解资源详情

weixin_38743481

- 粉丝: 698

- 资源: 4万+

最新资源

- n26aas:n26api即服务

- 酒店保安部年终总结下载

- PHP Pro Bid v5

- Morf-开源

- pandas-gbq-0.2.0.tar.gz

- Autonomous_Guidance_MPC_and_LQR-LMI:自动驾驶汽车的运动学MPC和动态LPV-LQR状态反馈控制

- angular-element-example:使用angular元素创建自定义元素的示例

- nike-shop-practice

- Wallpaper Engine v1.3.141.zip

- hop:HbbTV开放平台-用于创建快速和优化的HbbTV应用程序的TypeScript平台

- OpenAI的代码解释器:open-interpreter

- 值勤细则DOC

- NU454-高级建模技术

- MobileERP

- tech-alchemy-assignment

- 软件开发项目(附评标办法及标准)).rar