深度学习:残差网络解决梯度消失与网络退化

版权申诉

75 浏览量

更新于2024-08-11

收藏 628KB PDF 举报

"该文档详细探讨了深度学习中的残差网络(Residual Network)原理,主要关注在构建深度卷积网络时所面临的问题,如梯度消失、梯度爆炸和网络退化,并解释了为何这些问题会随着网络深度增加而变得更加严重。"

深度学习的核心在于构建深层神经网络,以提取不同层次的特征。残差网络(ResNet)是为了解决深度学习中的一些挑战,尤其是当网络层数增加时出现的梯度消失和网络退化问题。在深度卷积网络中,更深的层次理论上应该能够学习到更抽象、更有代表性的特征。然而,实际操作中,随着网络深度的增加,训练变得困难,这主要归因于两个问题:

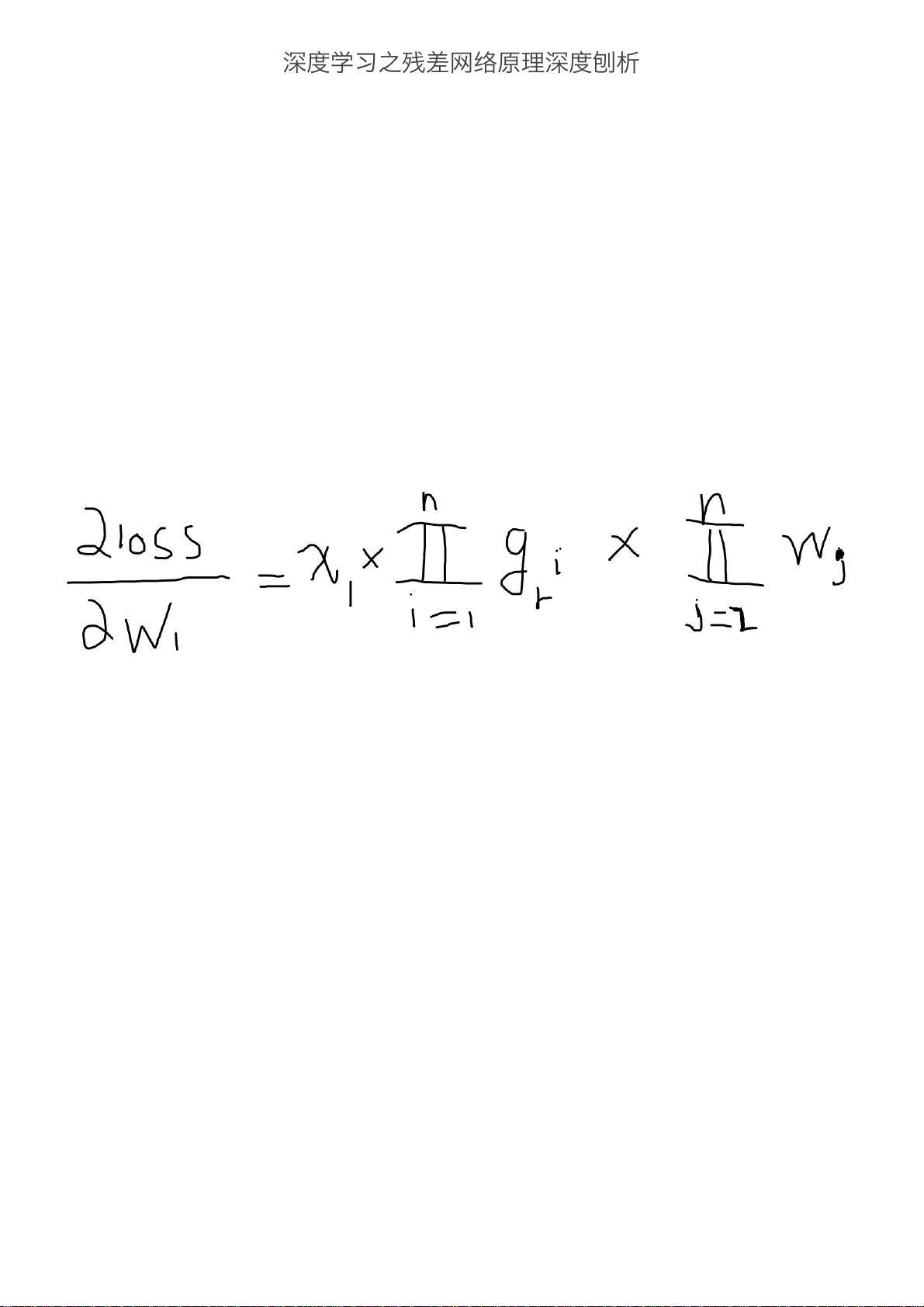

1. **梯度消失**:传统的sigmoid和tanh激活函数因其饱和特性导致梯度在反向传播过程中逐渐减小,使得深层网络的权重更新缓慢甚至停止。ReLU激活函数缓解了这个问题,因为它在正区间的导数为1,避免了梯度完全消失。然而,当网络非常深时,除了激活函数的导数外,其他链式求导项也可能导致梯度接近于零,从而再次引发梯度消失。

2. **梯度爆炸**:与梯度消失相反,如果在网络中某些参数的梯度过大,可能会导致权重更新幅度过大,破坏网络的稳定性,造成梯度爆炸。

3. **网络退化**:当网络层数增加时,即使理论上更深层次的网络应该能学到更好的特征,但实际上,额外的层可能无法学习到有效的表示,反而变成了冗余,使得网络性能下降。这种现象被称为网络退化,它不是由过拟合引起的,而是由于多余的层学习到了非恒等映射的参数。

为了解决这些问题,残差网络引入了残差块(Residual Block),其基本思想是通过直接跳过一些层,让输入信号可以直接传到输出,形如`F(x) + x`的结构,其中`F(x)`是残差学习的部分。这样,即使`F(x)`的学习效果不佳,网络仍可以学习到输入的恒等映射,从而缓解了梯度消失和网络退化问题。此外,ResNet通过批量归一化(Batch Normalization)、合适的初始化策略和残差连接的设计,有效地解决了深度网络的训练难题,使得训练上百层的网络成为可能。

残差网络的成功在于它提供了一种在深度网络中高效传播信息的方式,使得更深层次的网络可以被有效训练,从而在图像识别等领域取得了显著的性能提升。通过深入理解这些概念,我们可以更好地设计和优化深度学习模型,提高模型的准确性和泛化能力。

2019-09-30 上传

2022-04-13 上传

2021-08-18 上传

2019-12-20 上传

2021-08-27 上传

2022-12-16 上传

_webkit

- 粉丝: 31

- 资源: 1万+

最新资源

- 使用FLEX 和 Actionscript开发FLASH 游戏(二)

- Linux 那些事儿之我是U 盘

- Cache在嵌入式处理器中的使用问题

- 老友记(friends)词频统计.txt

- 使用FLEX 和 Actionscript开发FLASH 游戏(一)

- sap 增强 badi userexit customerexit

- 信息系统安全技术.doc

- Spring+Struts+Hibernate的详解课件.pdf

- WPF入门电子书--新手入门的开始

- 代码找茬游戏 PHP

- matlab统计函数

- llinux设备驱动程序(第三版)

- linux内核完全注释

- 内存DC介绍及其使用

- 难得的EXTJS中文手册

- asp 生成 html 代码