深度学习驱动的端到端图像压缩技术进展

42 浏览量

更新于2024-08-27

1

收藏 10.42MB PDF 举报

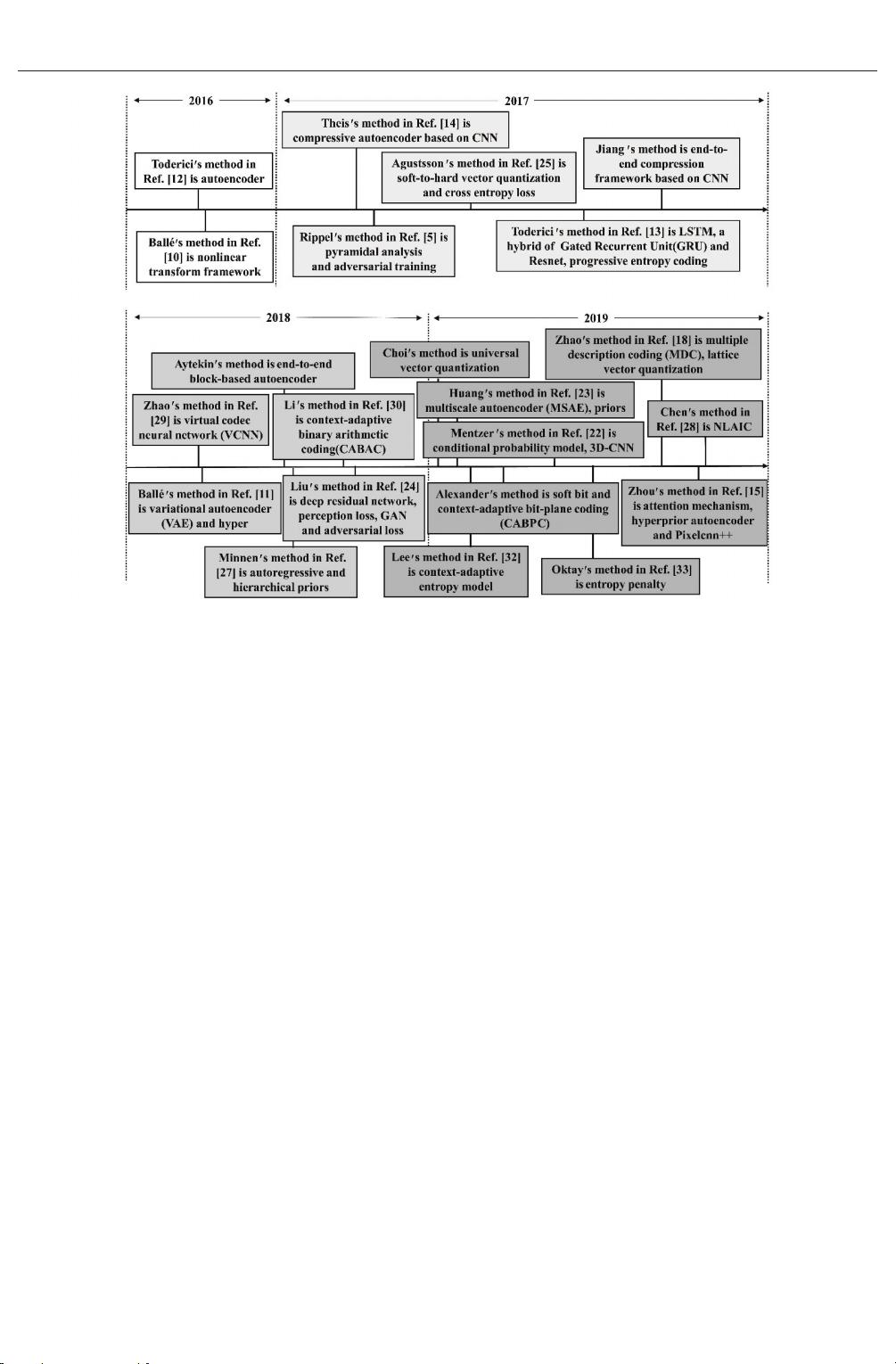

"基于端到端学习的图像编码研究及进展"

本文主要探讨了在图像大数据时代背景下,随着硬件技术的快速发展,基于深度学习的图像视频编码技术的重要性和应用。端到端学习的图像压缩框架因其在原始图像数据压缩效率上的优势,受到了学术界和工业界的广泛关注。文章系统性地概述了这个领域的核心组成部分,包括变换、量化、熵编码和损失函数的研究现状,并对相关技术的最新进展进行了详细介绍。

首先,图像压缩中的“变换”是将图像数据从空间域转换到频域的关键步骤,传统的图像压缩方法如JPEG使用离散余弦变换(DCT)。然而,基于深度学习的端到端方法可以自定义变换层,通过神经网络学习更适应数据特性的变换方式,从而提高压缩效率。

其次,“量化”是图像压缩过程中的另一个重要环节,它将变换后的系数映射到有限的数值集合中。传统的量化过程可能导致信息丢失,而深度学习方法可以学习更精细的量化策略,减少失真并优化压缩性能。

接着,熵编码是将量化后的数据进行高效编码的过程,如算术编码或哈夫曼编码。深度学习引入后,可以学习数据的概率分布,实现自适应的熵编码,进一步提升压缩比率。

再者,损失函数的选择对压缩质量有直接影响。传统的MSE(均方误差)或PSNR(峰值信噪比)可能无法完全捕捉视觉感知质量,因此,研究者们探索了诸如MS-SSIM(多尺度结构相似度)、VGG损失等深度学习相关的损失函数,以更好地模拟人类视觉系统的感知特性。

文章还对比分析了近期的一些前沿研究成果,如神经网络模型在压缩效率和重构质量方面的表现,以及不同方法在复杂性和解码速度上的权衡。这些研究不仅推动了理论上的进步,也为实际应用提供了更多可能性,例如在云计算、物联网(IoT)设备、高清视频流媒体等领域。

基于端到端学习的图像编码已经成为图像压缩领域的一个重要研究方向。未来,这一技术有望在提高压缩效率、降低带宽需求的同时,保持高质量的图像重建,对于图像大数据的存储和传输具有重大意义。随着深度学习技术的不断发展,我们期待看到更多创新的图像压缩算法,以应对日益增长的图像数据处理挑战。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-08-31 上传

2021-08-19 上传

2022-06-01 上传

2010-12-29 上传

点击了解资源详情

点击了解资源详情

抹蜜茶

- 粉丝: 303

- 资源: 936

最新资源

- Python中快速友好的MessagePack序列化库msgspec

- 大学生社团管理系统设计与实现

- 基于Netbeans和JavaFX的宿舍管理系统开发与实践

- NodeJS打造Discord机器人:kazzcord功能全解析

- 小学教学与管理一体化:校务管理系统v***

- AppDeploy neXtGen:无需代理的Windows AD集成软件自动分发

- 基于SSM和JSP技术的网上商城系统开发

- 探索ANOIRA16的GitHub托管测试网站之路

- 语音性别识别:机器学习模型的精确度提升策略

- 利用MATLAB代码让古董486电脑焕发新生

- Erlang VM上的分布式生命游戏实现与Elixir设计

- 一键下载管理 - Go to Downloads-crx插件

- Java SSM框架开发的客户关系管理系统

- 使用SQL数据库和Django开发应用程序指南

- Spring Security实战指南:详细示例与应用

- Quarkus项目测试展示柜:Cucumber与FitNesse实践