Apache Spark与多数据源整合实践

需积分: 18 41 浏览量

更新于2024-07-21

1

收藏 1000KB PDF 举报

"田毅在Apache2015中国路演中探讨了Spark与多数据源的结合在各种场景下的应用,强调了使用多个数据源的原因、Spark的多数据源方案及其在GrowingIO的实际运用。"

在大数据领域,Spark作为一种快速、通用、可扩展的计算引擎,经常需要与各种不同类型的数据源进行交互,以满足不同业务需求和应用场景。田毅的演讲重点在于解释为什么会使用多个数据源,以及Spark如何通过其DataSourcesAPI来解决多数据源带来的挑战。

首先,使用多个数据源的原因可以从三个方面理解。一是数据本身的多样性,包括结构化和非结构化数据、实时和离线数据,以及各种不同的数据格式。二是业务需求的多样性,不同业务场景可能需要将数据存储在不同地方,例如数据挖掘、实时查询、多维分析等。三是软件技术的不断发展,产生了众多专门针对特定领域的解决方案,如NoSQL数据库、存储系统、搜索引擎、MPP数据库和查询引擎等。这些因素共同推动了对多数据源的需求。

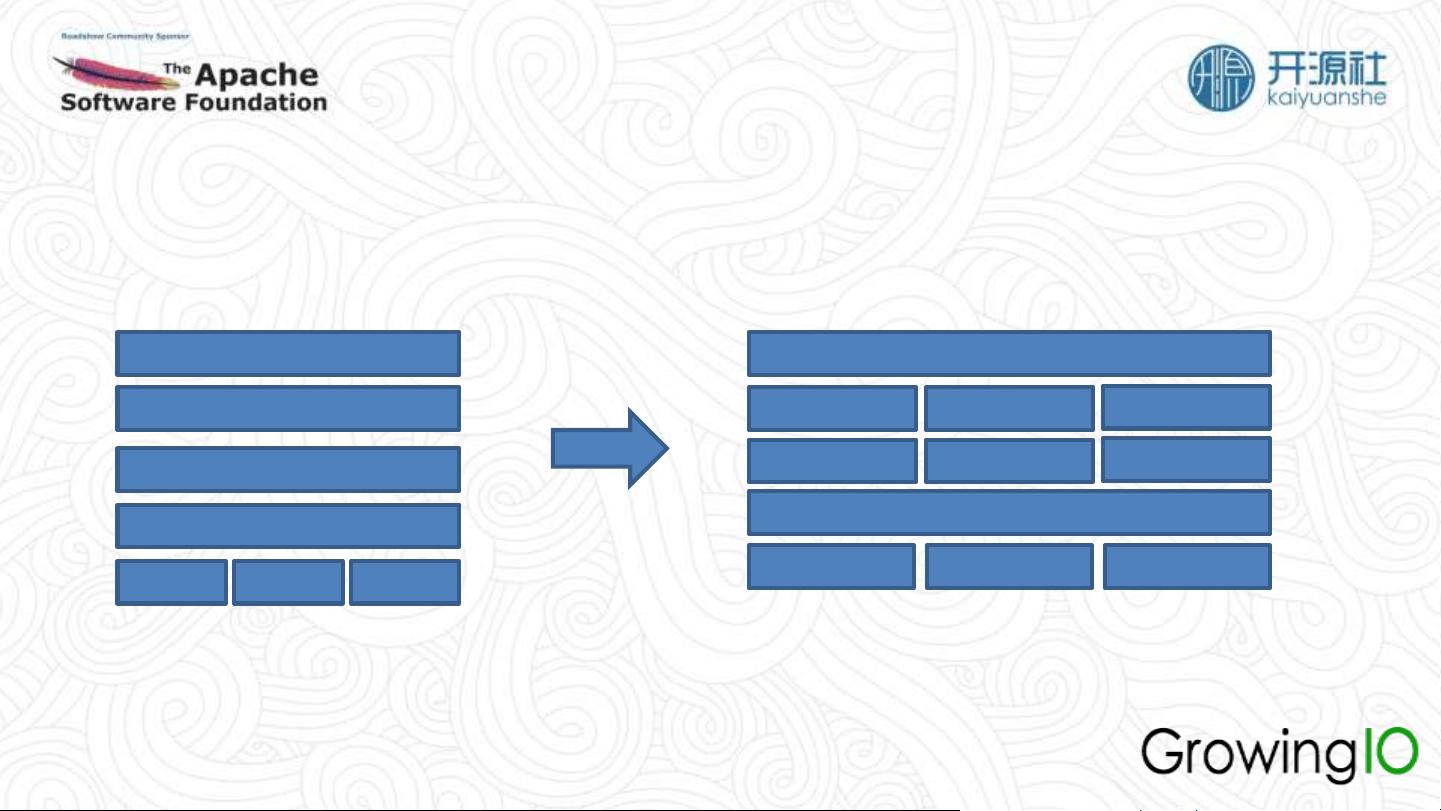

在这样的背景下,Spark引入了DataSourcesAPI,自1.2.0版本起,它为Spark提供了访问外部数据源的能力,旨在实现快速灵活的数据读写,并提高效率。面对数据类型转换的问题,SparkSQL的Catalyst优化框架提供了统一的数据类型定义,允许数据源与Catalyst之间的转换,确保数据一致性。而在提升数据处理效率方面,Spark设计了灵活的API,以适应不同数据源的特性和性能需求,从而优化数据读写速度。

在GrowingIO的实践中,这些理论知识得到了实际应用,展示了Spark如何有效整合多种数据源,满足实时分析和快速应用开发的需求。通过这样的案例,听众可以更好地理解和应用Spark的多数据源能力,解决实际工作中遇到的问题。

田毅的演讲深入剖析了Spark与多数据源的融合,揭示了这一技术在大数据处理中的重要性,以及如何通过有效的工具和方法来应对复杂的数据环境,为开发者提供了宝贵的指导。

2015-04-27 上传

2021-01-19 上传

2021-01-29 上传

2015-09-01 上传

2022-12-24 上传

2020-02-22 上传

2021-10-11 上传

点击了解资源详情

点击了解资源详情

csdn_csdn__AI

- 粉丝: 2244

- 资源: 117

最新资源

- 火炬连体网络在MNIST的2D嵌入实现示例

- Angular插件增强Application Insights JavaScript SDK功能

- 实时三维重建:InfiniTAM的ros驱动应用

- Spring与Mybatis整合的配置与实践

- Vozy前端技术测试深入体验与模板参考

- React应用实现语音转文字功能介绍

- PHPMailer-6.6.4: PHP邮件收发类库的详细介绍

- Felineboard:为猫主人设计的交互式仪表板

- PGRFileManager:功能强大的开源Ajax文件管理器

- Pytest-Html定制测试报告与源代码封装教程

- Angular开发与部署指南:从创建到测试

- BASIC-BINARY-IPC系统:进程间通信的非阻塞接口

- LTK3D: Common Lisp中的基础3D图形实现

- Timer-Counter-Lister:官方源代码及更新发布

- Galaxia REST API:面向地球问题的解决方案

- Node.js模块:随机动物实例教程与源码解析