CUDA编程入门:NVIDIA GPU计算指南

需积分: 35 175 浏览量

更新于2024-07-24

收藏 1.8MB DOC 举报

“NVIDIA CUDA编程指南”是一本针对初学者的教程,旨在介绍NVIDIA的CUDA编程技术。CUDA是NVIDIA推出的一种并行计算平台和编程模型,它允许程序员利用图形处理单元(GPU)的强大计算能力来执行通用计算任务。

在CUDA编程模型中,主要涉及以下几个核心概念:

1. **计算统一设备架构 (Compute Unified Device Architecture)**:CUDA的核心是计算统一设备架构,它将GPU视为能够执行通用计算任务的处理器,而不仅仅局限于图形渲染。CUDA将GPU的并行计算能力开放给开发者,使得CPU和GPU可以协同工作,提高整体计算效率。

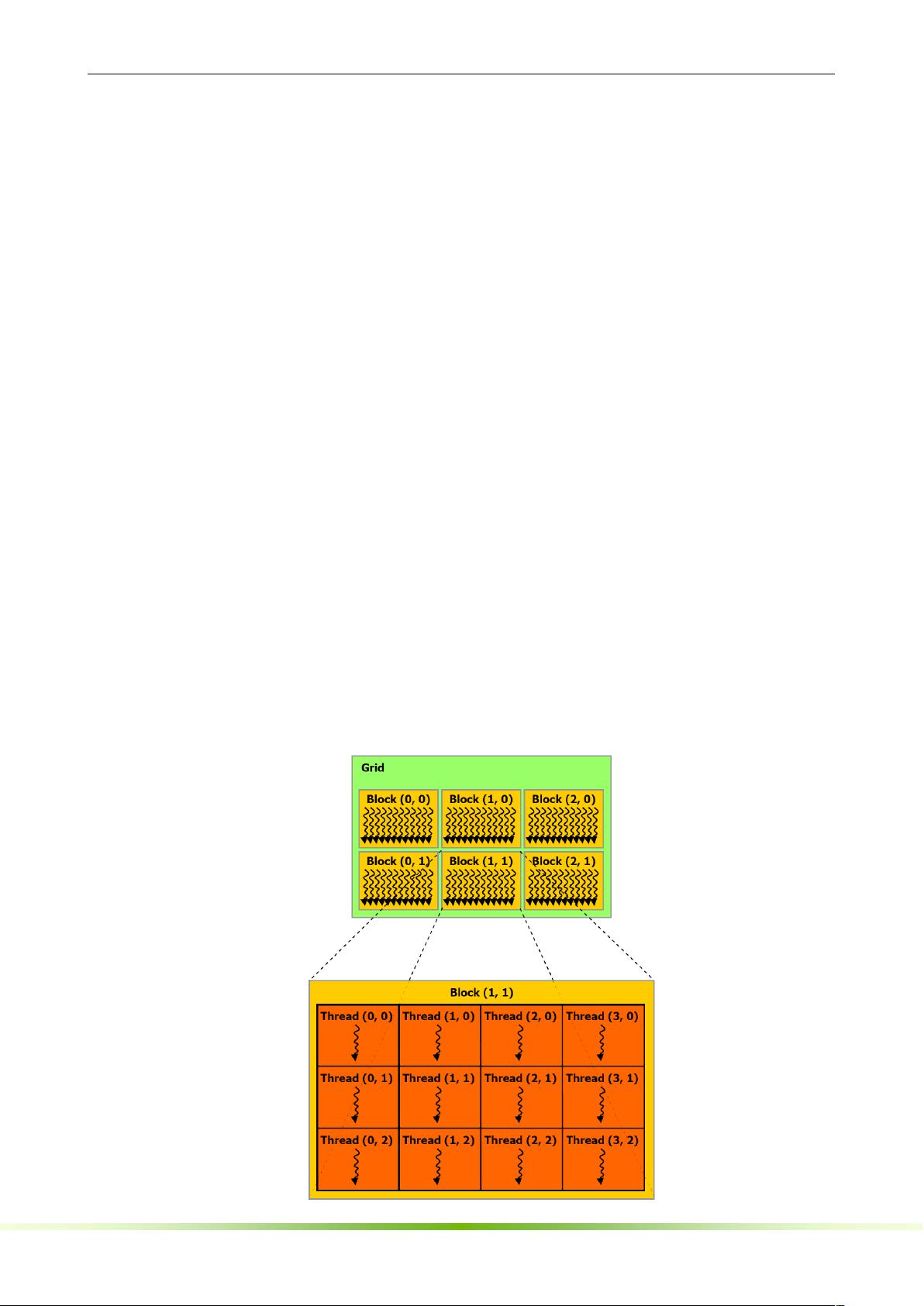

2. **线程层次结构**:CUDA中的并行计算是通过线程块和线程网格来组织的。线程块是由一组线程组成的,线程块又可以组成一个线程网格。这种分层结构允许开发者精细控制并行执行的粒度。

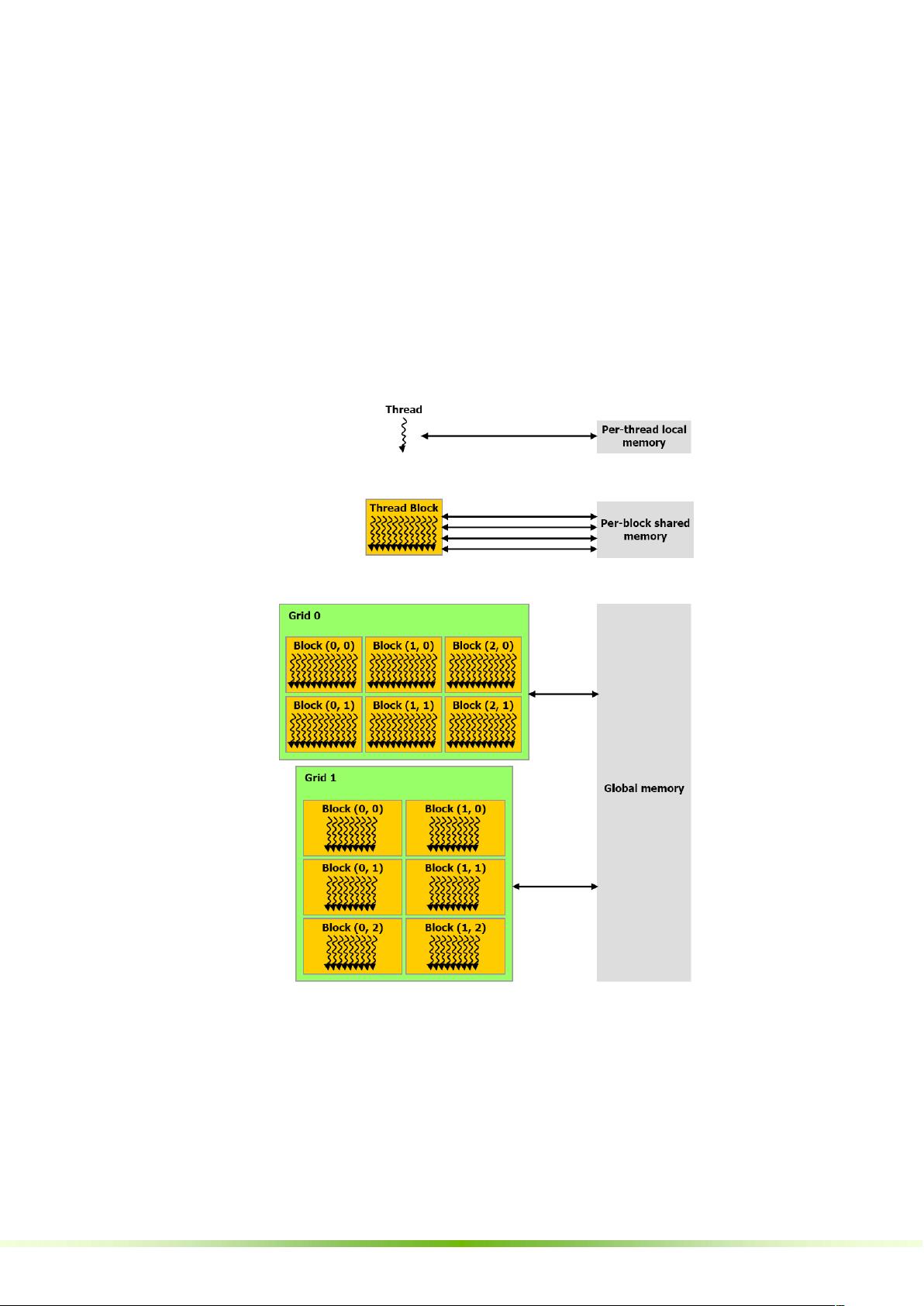

3. **存储器层次结构**:CUDA GPU具有多种存储器类型,包括全局存储器、共享存储器、常量存储器和寄存器。这些存储器有不同的访问速度和使用场景,开发者需要根据需求合理安排数据存储位置。

4. **主机和设备**:CUDA程序中,主机(CPU)和设备(GPU)可以交互。程序员可以通过CUDA API在主机和设备之间传输数据,启动和同步GPU计算。

5. **软件栈**:CUDA编程涉及到的软件栈包括编译器(如NVCC)、运行时库以及驱动API。NVCC是CUDA C/C++的编译器,它可以处理语言扩展,如设备函数、全局变量等。

6. **计算能力**:CUDA定义了“计算能力”这一概念,它代表了GPU执行特定CUDA指令的能力。不同的计算能力对应不同的硬件特性和性能。

在GPU实现部分,CUDA编程指南会详细解释:

- **SIMT多处理器**:GPU内部的运算单元采用单指令多线程(SIMT)架构,一组线程可以同时执行相同的操作,以充分利用并行性。

- **设备和多设备支持**:CUDA支持多GPU环境,允许开发者在多个设备上分配和执行计算任务。

- **模式切换**:在主机和设备之间切换执行模式是CUDA编程的一部分,这涉及到数据传输和计算任务的调度。

在应用程序编程接口(API)章节,指南涵盖:

- **C语言扩展**:CUDA扩展了C/C++语言,引入了如`__device__`、`__global__`、`__host__`等函数和变量类型限定符,用于指定函数或变量是在GPU还是CPU上执行或存储。

- **执行配置**:通过参数设定,如`gridDim`、`blockIdx`、`blockDim`和`threadIdx`,可以定义线程网格和线程块的尺寸,从而控制并行执行的范围。

- **NVCC编译选项**:如`__noinline__`和`#pragma unroll`等,用于优化代码生成。

- **通用运行时组件**:包括内置的向量类型、数学函数、计时函数和纹理支持,为开发者提供了丰富的工具集,简化了GPU编程。

通过学习CUDA编程指南,开发者可以学会如何编写高效的GPU程序,利用GPU的并行计算能力解决大规模计算问题。

2008-10-14 上传

122 浏览量

2023-06-27 上传

2023-08-13 上传

2023-11-27 上传

2023-05-22 上传

2023-08-19 上传

2023-07-08 上传

2023-08-01 上传

NorthrendSnow

- 粉丝: 122

- 资源: 24

最新资源

- 计算机人脸表情动画技术发展综述

- 关系数据库的关键字搜索技术综述:模型、架构与未来趋势

- 迭代自适应逆滤波在语音情感识别中的应用

- 概念知识树在旅游领域智能分析中的应用

- 构建is-a层次与OWL本体集成:理论与算法

- 基于语义元的相似度计算方法研究:改进与有效性验证

- 网格梯度多密度聚类算法:去噪与高效聚类

- 网格服务工作流动态调度算法PGSWA研究

- 突发事件连锁反应网络模型与应急预警分析

- BA网络上的病毒营销与网站推广仿真研究

- 离散HSMM故障预测模型:有效提升系统状态预测

- 煤矿安全评价:信息融合与可拓理论的应用

- 多维度Petri网工作流模型MD_WFN:统一建模与应用研究

- 面向过程追踪的知识安全描述方法

- 基于收益的软件过程资源调度优化策略

- 多核环境下基于数据流Java的Web服务器优化实现提升性能