RNN的BPTT原理详解:序列标注与梯度计算

需积分: 0 15 浏览量

更新于2024-08-04

收藏 1010KB DOCX 举报

RNN之BPTT原理1深入讲解

【RNN与序列标注】

循环神经网络(RNN)在序列标注问题中扮演关键角色,其任务是处理输入时间序列,例如文本中的词性标注或语音识别中的音素识别。RNN的特点在于能够保留长时记忆,使得模型能够理解输入序列中前后信息的关联。

【RNN结构与前向传播】

RNN的典型结构包括输入门、遗忘门、细胞状态和输出门等组件,这些门控制着信息在网络中的流动。前向传播通过逐时间步计算每个时刻的隐藏状态,将上一时刻的隐藏状态与当前输入结合,形成新的隐藏状态,并输出对应的标签概率分布。

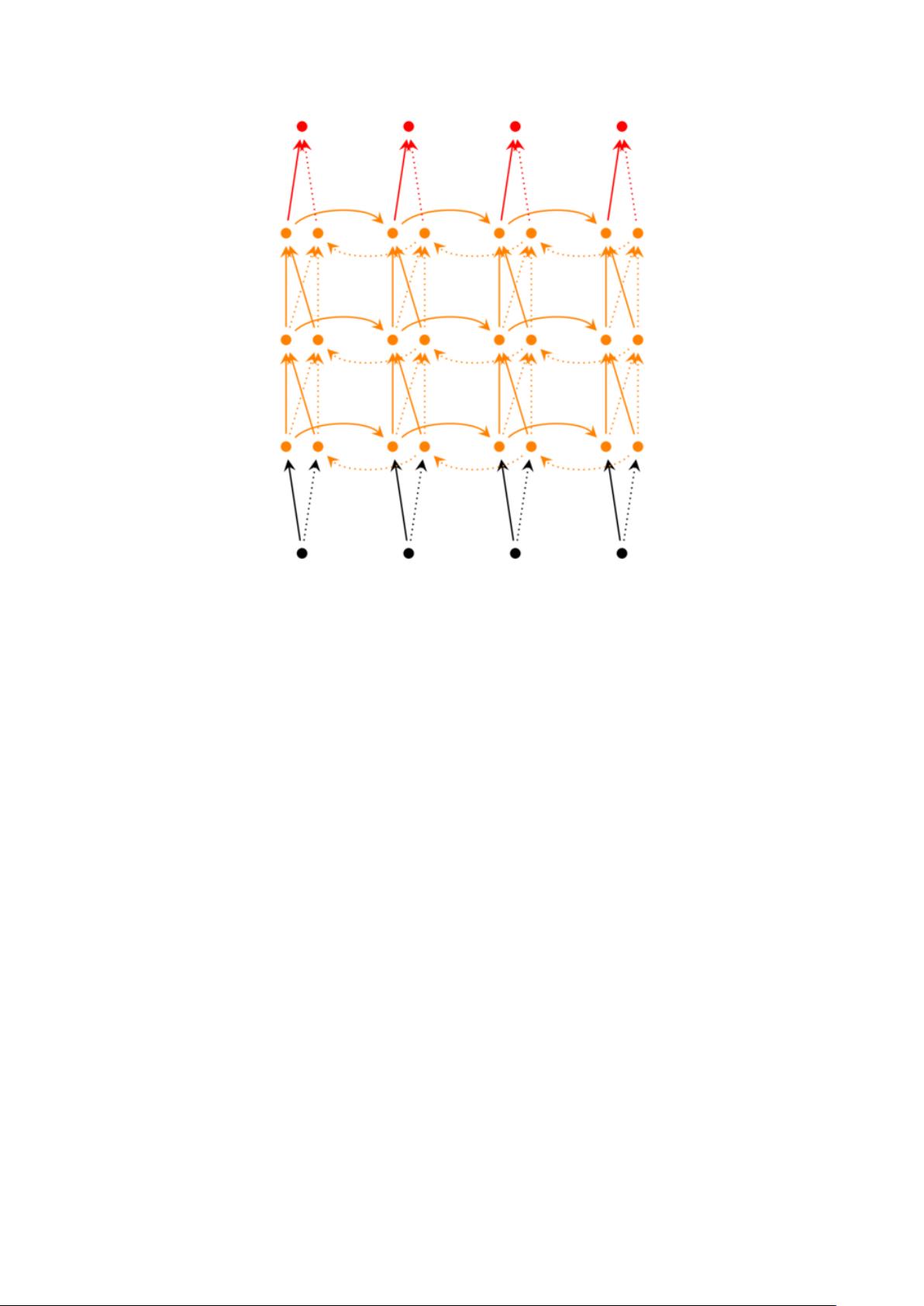

【深度RNN与参数共享】

深度RNN通过增加隐藏层来提升模型复杂度,虽然U、W、V和b共享参数,但它们对当前和后续时刻的影响需要仔细处理。BPTT(Backpropagation Through Time)技术通过时间维度反向传播梯度,求解每一步的误差贡献。

【BPTT计算与梯度更新】

BPTT的关键在于计算损失函数关于每个参数的偏导数,如V、U、W和b。这涉及到链式法则的应用,以及prod运算符对不同形状张量的乘法操作。在计算过程中,会遇到梯度消失或爆炸的问题,这取决于权重矩阵的范数和学习率的选择。

【softmax与交叉熵损失】

softmax函数用于输出层,将概率分布标准化。交叉熵损失函数作为优化目标,计算真实标签与预测概率之间的差异。求导时需考虑到softmax函数的特性,确保所有非目标类别的输出也被考虑在内,以便准确更新模型参数。

总结起来,本文详细阐述了RNN的BPTT原理,包括RNN结构、前向传播机制、深度RNN的处理方式,以及如何通过BPTT进行梯度计算和参数更新。同时,对常见的softmax函数和交叉熵损失函数进行了介绍,强调了处理序列标注问题时的注意事项,如防止梯度消失和爆炸问题。这对于理解和应用RNN在序列标注任务中至关重要。

2019-11-05 上传

2023-01-05 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-05-29 上传

2023-05-30 上传

2023-04-12 上传

2023-08-03 上传

刘璐璐璐璐璐

- 粉丝: 35

- 资源: 326

最新资源

- Hadoop生态系统与MapReduce详解

- MDS系列三相整流桥模块技术规格与特性

- MFC编程:指针与句柄获取全面解析

- LM06:多模4G高速数据模块,支持GSM至TD-LTE

- 使用Gradle与Nexus构建私有仓库

- JAVA编程规范指南:命名规则与文件样式

- EMC VNX5500 存储系统日常维护指南

- 大数据驱动的互联网用户体验深度管理策略

- 改进型Booth算法:32位浮点阵列乘法器的高速设计与算法比较

- H3CNE网络认证重点知识整理

- Linux环境下MongoDB的详细安装教程

- 压缩文法的等价变换与多余规则删除

- BRMS入门指南:JBOSS安装与基础操作详解

- Win7环境下Android开发环境配置全攻略

- SHT10 C语言程序与LCD1602显示实例及精度校准

- 反垃圾邮件技术:现状与前景