大数据平台构建与数据分析实战

下载需积分: 10 | DOCX格式 | 2.44MB |

更新于2024-07-09

| 194 浏览量 | 举报

林子雨大数据技术平台构建及其数据分析,涉及Hadoop大数据存储与运算的实训,涵盖了虚拟机配置、Hadoop伪分布式和分布式配置、HBase安装与编程、MySQL在Linux上的安装、Hive安装配置、sqoop数据采集、数据上传及Hive数据分析、数据可视化(使用R)等内容。

在大数据领域,构建一个有效的课设平台对于学习和实践至关重要。此文档详述了从零开始构建这样一个平台的过程,主要分为以下几个部分:

1. **虚拟机与Linux系统的安装**:

- 首先确认计算机支持虚拟化技术,并在BIOS中启用Intel Virtualization Technology。

- 使用Oracle VM VirtualBox创建虚拟机,配置合适的内存大小(例如3GB)和硬盘容量(如30GB),并安装Linux操作系统(如Ubuntu 16.4)。

2. **Eclipse的安装与使用**:

- 在Ubuntu系统中,通过“软件中心”安装Eclipse,这是一款广泛用于Java开发的集成开发环境,对于Hadoop相关的开发非常有用。

3. **Hadoop的安装与配置**:

- 创建Hadoop用户,便于管理Hadoop相关服务。

- 安装SSH服务,方便无密码登录,简化操作。

- 安装Java环境,Hadoop依赖Java运行,通常需要JRE和JDK。

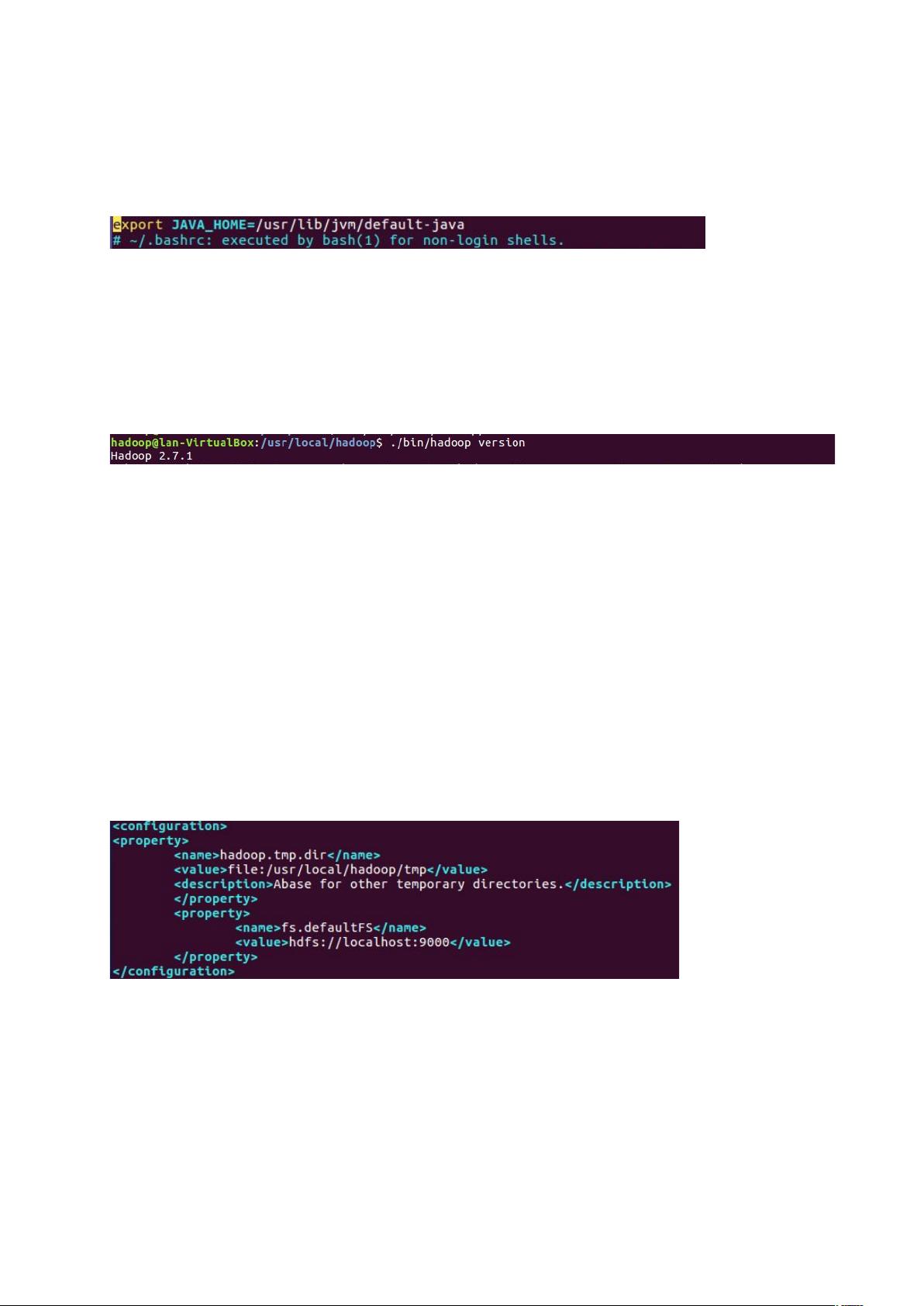

- 配置环境变量,将Java路径添加到`.bashrc`文件中。

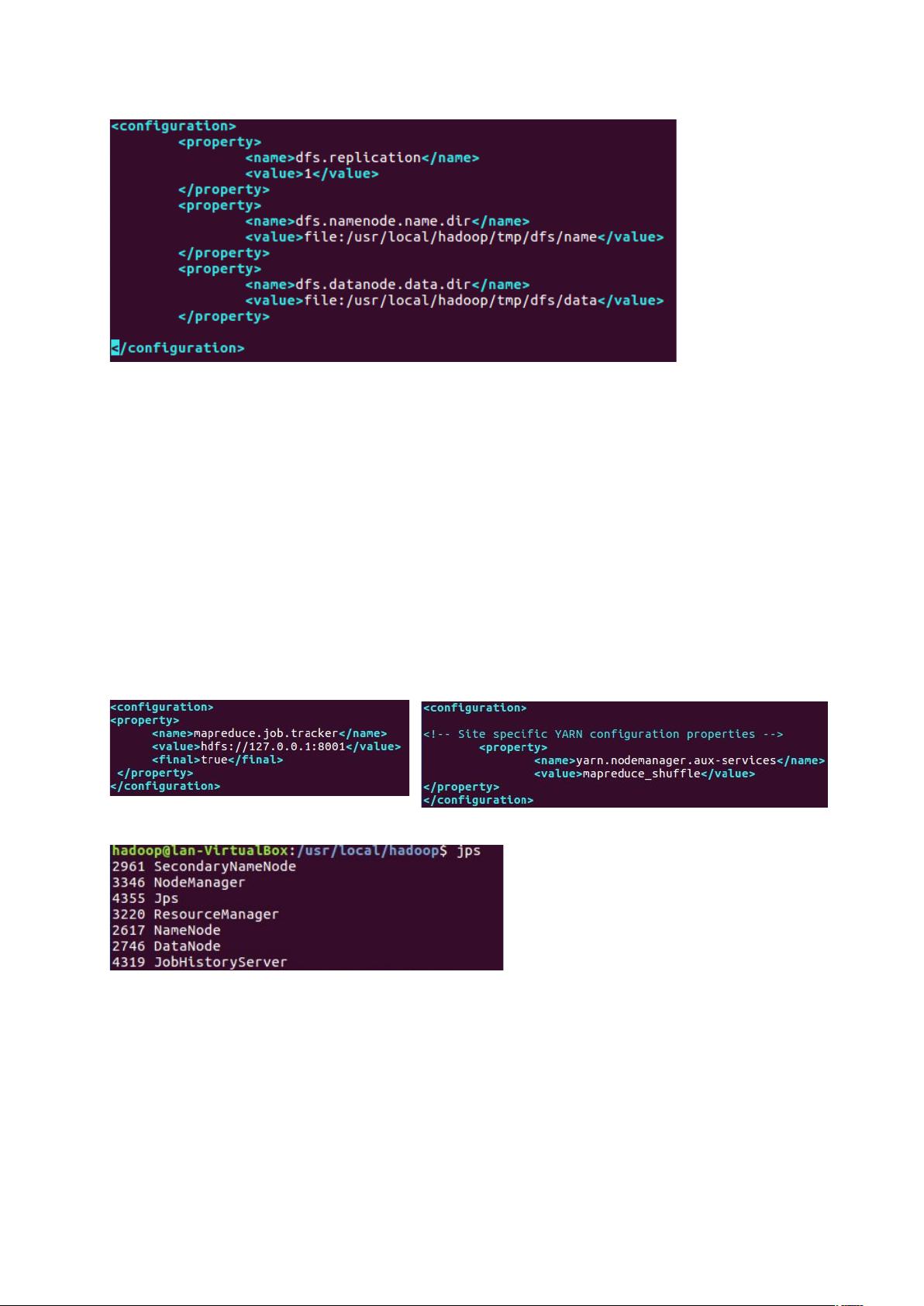

- 完成Hadoop的伪分布式配置,这是单节点模拟多节点环境,便于学习和测试。

4. **HBase的安装与编程**:

- HBase是基于Hadoop的数据存储系统,适用于非结构化数据的存储。

- 安装HBase后,可以进行基本的编程练习,理解其API和数据操作。

5. **MySQL在Linux上的安装**:

- MySQL是一个关系型数据库管理系统,常用于结构化数据的存储和管理。

6. **数据仓库Hive的安装配置**:

- Hive提供了一种基于SQL的查询语言(HQL),用于处理和分析存储在Hadoop上的大规模数据。

7. **数据采集工具sqoop的使用**:

- Sqoop用于将结构化数据从关系数据库导入到Hadoop的HDFS,或者反向导出到数据库。

8. **数据上传及Hive数据分析**:

- 将本地数据集上传至Hadoop集群,然后使用Hive进行数据清洗、转换和分析。

9. **Hive、MySQL和HBase之间的数据互导**:

- 学习如何在这些不同存储系统之间迁移数据,理解它们各自的适用场景。

10. **R的安装与数据可视化**:

- 安装R语言,它在数据科学中广泛用于统计分析和可视化。

- 利用R进行数据探索和制作可视化图表,提升数据理解能力。

通过这个实训,学生将全面了解大数据平台的构建过程,掌握数据处理的各个环节,包括数据采集、存储、处理、分析和可视化,为后续的大数据实战打下坚实的基础。

相关推荐

594 浏览量

JaredChen

- 粉丝: 555

- 资源: 23

最新资源

- 2009系统分析师考试大纲

- debian维护人员手册

- 如何成为时间管理的黑带高手—Diddlebug实战篇

- ASP_NET中的错误处理和程序优化

- HP OpenView Operations管理员参考手册

- Struts2.0详细教程

- C#应用程序打包.pdf

- CSS在IE6 IE7与FireFox下的兼容问题整理

- [Ultimate Game Design Building Game Worlds][EN].pdf

- Nokia 6120c说明书

- flash_as3_programming

- 手把手教你如何写Makefile

- Extending WebSphere Portal Session Timeout

- rmi原理-chn-pdf

- 第3章 创建型模式 创建型模式抽象了实例化过程

- 第2章 实例研究:设计一个文档编辑器