对比损失与深度学习中的Loss设计

需积分: 0 64 浏览量

更新于2024-08-03

收藏 1.9MB PDF 举报

"这篇文档是关于2023年4月9日的kaggle教程,专注于对比损失(Contrastive Loss)在设计损失函数中的应用。内容涵盖了对比损失的基本概念、定义以及在特征学习中的作用,同时也提到了一些采用了对比损失的工作论文总结。"

在机器学习和深度学习中,设计合适的损失函数对于模型训练至关重要。对比损失(Contrastive Loss)是一种在非监督学习场景中常用的损失函数,尤其在降维和特征学习任务中。它最早由Yann LeCun在2006年的研究中提出,目的是保持相似样本在降维后的相似性,同时确保不相似样本之间的差异性。

对比损失的核心思想在于衡量样本对之间的匹配程度。在无标签的数据集中,每个样本可以被视为独立的类别,例如,一张猫的图片经过不同的变换(如旋转或裁剪)仍然被认为是同一类。对比损失期望相同图片的变换版本(如A和B)在特征空间中的距离小于与其他任何图片(如Y)的距离。

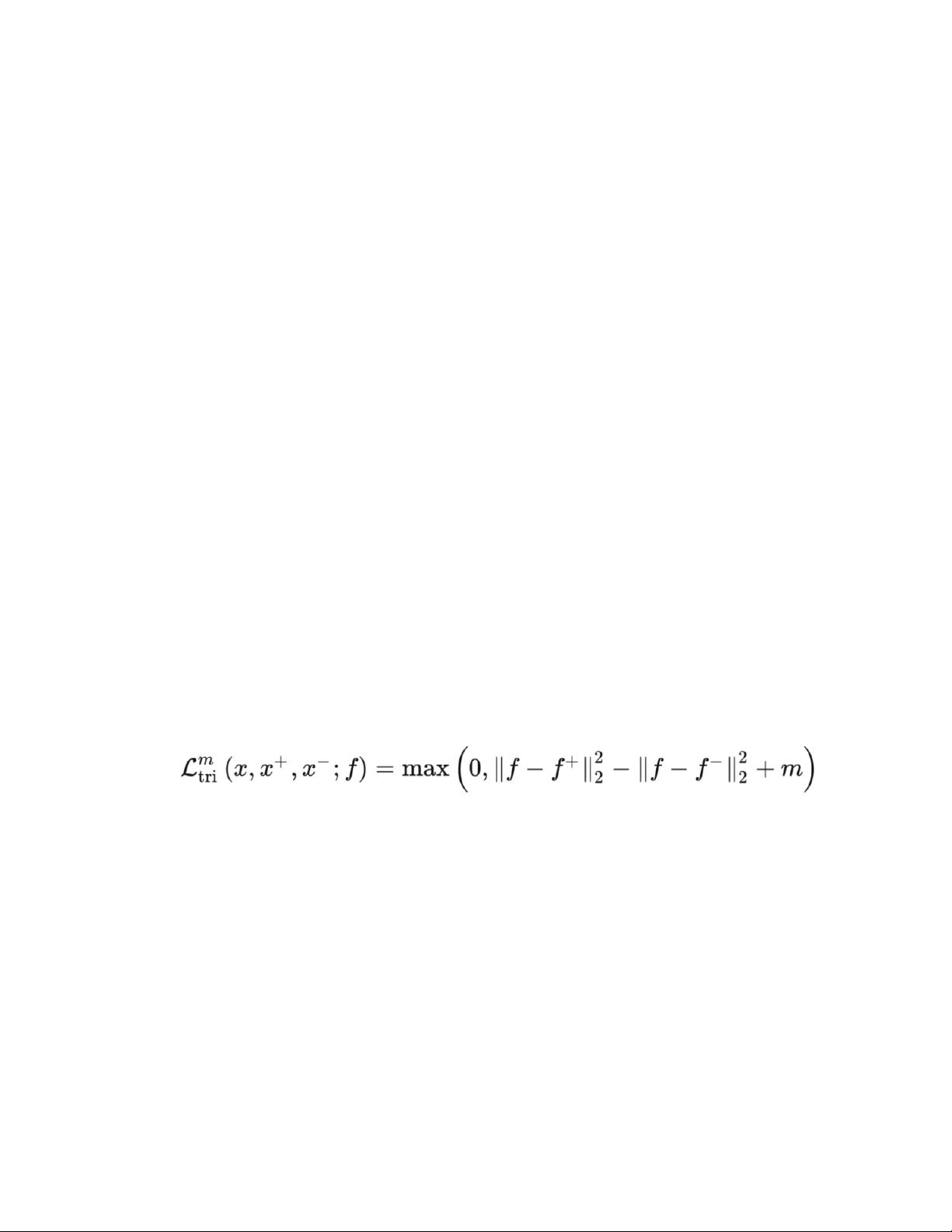

对比损失的数学定义如下:

\[ L = \frac{1}{2N}\sum_{i=1}^{N}\sum_{j=1}^{N}y_{ij}(d(f(x_i), f(x_j)))^2 + (1 - y_{ij})\max(margin - d(f(x_i), f(x_j)), 0)^2 \]

其中,\( d \) 表示特征向量的欧氏距离,\( f \) 是特征提取函数,\( N \) 是样本数量,\( y_{ij} \) 是匹配标签(1表示匹配,0表示不匹配),\( margin \) 是预设的阈值。这个损失函数鼓励模型使得匹配的样本对特征距离小,不匹配的样本对特征距离大,超过阈值的不匹配对将不会贡献损失。

对比损失在实际应用中能有效训练特征提取模型。当两个匹配样本的特征距离过大时,损失函数值增大,从而促使模型优化以减小损失;反之,不匹配样本的特征距离过小时,损失也会增大,激励模型增加它们之间的距离。

在文献中,对比损失已经被广泛应用到各种深度学习任务中,例如深度度量学习(Deep Metric Learning),这通常涉及到识别和检索任务,如人脸识别、图像检索等。通过对比损失,模型能够学习到区分性更强的特征表示,提升任务性能。

举例来说,"Improved Deep Metric Learning with Multi-class N-pair Loss"这样的论文就可能利用对比损失来改进传统的多类度量学习方法,提高模型在多类别数据上的表现。这些工作通常会提出新的损失函数形式或者优化策略,以适应特定任务的需求,进一步提升模型的泛化能力。

对比损失在AI和机器学习竞赛中,尤其是kaggle竞赛,是一个重要的工具,因为它可以帮助参赛者构建更强大的模型,特别是在处理大量未标注数据或需要特征学习的场景。理解并有效地应用对比损失,可以为竞赛方案提供有力的支持,提高解决方案的竞争力。

2021-06-05 上传

2020-07-17 上传

2023-06-09 上传

2021-02-03 上传

113 浏览量

2023-06-09 上传

2023-06-10 上传

2023-06-09 上传

白话机器学习

- 粉丝: 1w+

- 资源: 7671

最新资源

- Linux下安装Oracle92全过程

- 安规 2006-66-EC

- 中外名企面试笔试智力题大搜罗及面试方法!

- 虚拟机中Linux与主机实现共享

- 高质量C++/C 编程指南

- v512工作室_刘伟_Hibernate与Struts2和Spring组合开发

- hibernate session.doc

- hibernateDaoSupport.txt

- VIM 高级教程 (Hacking Vim A cookbook to get the most out of the latest Vim editor)

- ODBC数据源自动注册的实现.pdf

- 深入了解MFC中的文挡视结构

- Linux下访问SQL方法

- 制动器试验台的控制方法分析

- VC界面静态文本超链接设置

- 轻松实现类VC界面 轻松实现类VC界面

- C#实用功能总结.doc