机器学习中的SVD:理解与应用

需积分: 0 5 浏览量

更新于2024-06-30

收藏 843KB DOCX 举报

奇异值分解1深入解析

一、奇异值与特征值基础知识

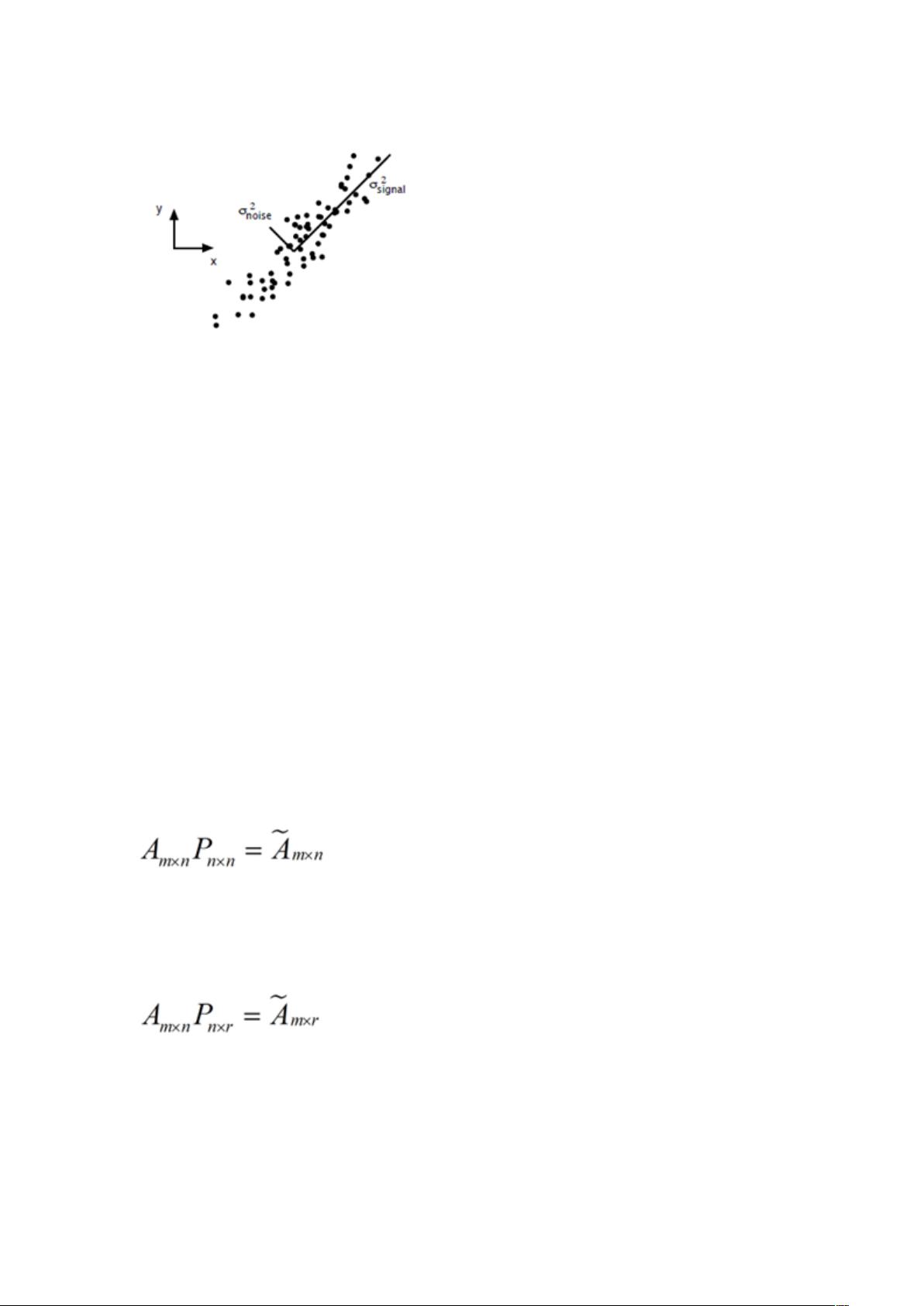

在机器学习领域,特征值分解和奇异值分解是两种广泛应用的方法,它们都是矩阵分析的核心概念。特征值分解用于揭示矩阵的本质属性,尤其是对实对称矩阵或复共轭矩阵,其特征向量提供了旋转不变的信息,而奇异值分解则更多地关注矩阵的压缩和重构能力。奇异值不仅反映了矩阵的秩和能量分布,还具有物理意义,例如在图像处理中代表数据的主要成分。

二、奇异值的计算挑战

计算奇异值并非易事,它涉及到求解一个复杂的问题,时间复杂度为O(N^3),其中N是矩阵的尺寸。尽管如此,奇异值分解的价值在于它提供了矩阵的简洁表示,即使原始数据非常庞大。通过分解为三个因子(U、S和V),数据可以被压缩到更小的维度,同时保持主要的信息特征。

应用实例

- PCA(主成分分析):PCA中,奇异值分解用于找到数据的主要方向,通过保留最大的奇异值对应的投影,可以进行特征降维,减少噪声并保持数据的最重要特征。

- 图像压缩:奇异值分解常用于无损或有损的数据压缩,通过丢弃较小的奇异值对应的系数,可以显著减小数据存储空间,同时保持视觉效果。

- LSI(潜在语义索引):在搜索引擎中,LSI利用奇异值分解来理解和表示文档之间的语义关系,提高检索的准确性和相关性。

技术局限与期望

尽管奇异值分解在理论和实践中都具有重要意义,但实际计算过程中的效率问题仍然是一个挑战。此外,国内在技术讨论方面的氛围有待提升,许多优质的深度技术文章往往被娱乐内容淹没。作者呼吁,技术从业者应该专注于自己的专业领域,提升中文技术文章的质量,共同推动行业的进步。

未来展望与学习路径

虽然本文着重介绍奇异值的特性及其应用,但对于初次接触或需要复习线性代数的人来说,可能会涉及一些基础概念。对于这部分内容,建议先回顾矩阵运算、特征值和特征向量等基础知识,然后再深入理解奇异值分解的原理和计算方法。这样能够更好地把握奇异值分解在机器学习中的实际运用价值。

2023-05-19 上传

2023-08-02 上传

2024-05-09 上传

2023-08-24 上传

2023-06-10 上传

2023-12-28 上传

点墨楼

- 粉丝: 37

- 资源: 279

最新资源

- 明日知道社区问答系统设计与实现-SSM框架java源码分享

- Unity3D粒子特效包:闪电效果体验报告

- Windows64位Python3.7安装Twisted库指南

- HTMLJS应用程序:多词典阿拉伯语词根检索

- 光纤通信课后习题答案解析及文件资源

- swdogen: 自动扫描源码生成 Swagger 文档的工具

- GD32F10系列芯片Keil IDE下载算法配置指南

- C++实现Emscripten版本的3D俄罗斯方块游戏

- 期末复习必备:全面数据结构课件资料

- WordPress媒体占位符插件:优化开发中的图像占位体验

- 完整扑克牌资源集-55张图片压缩包下载

- 开发轻量级时事通讯活动管理RESTful应用程序

- 长城特固618对讲机写频软件使用指南

- Memry粤语学习工具:开源应用助力记忆提升

- JMC 8.0.0版本发布,支持JDK 1.8及64位系统

- Python看图猜成语游戏源码发布