腾讯TDW:大规模Hadoop集群优化与实践

80 浏览量

更新于2024-08-28

收藏 371KB PDF 举报

“腾讯大规模Hadoop集群实践,包括TDW的介绍、建设原因、优化方案以及面临的挑战。”

在腾讯的大规模Hadoop集群实践中,TDW(Tencent Distributed Data Warehouse)扮演了核心角色,它是一个基于Hadoop和Hive的分布式数据仓库系统。TDW解决了传统数据仓库扩展性和可控性的难题,特别针对腾讯的海量数据和复杂计算需求进行了定制优化。集群规模庞大,拥有超过4400台服务器,总计约10万个CPU核心,存储容量达到100PB,每天处理100多万个作业,日计算量高达4PB,同时支持2000左右的作业并发执行。

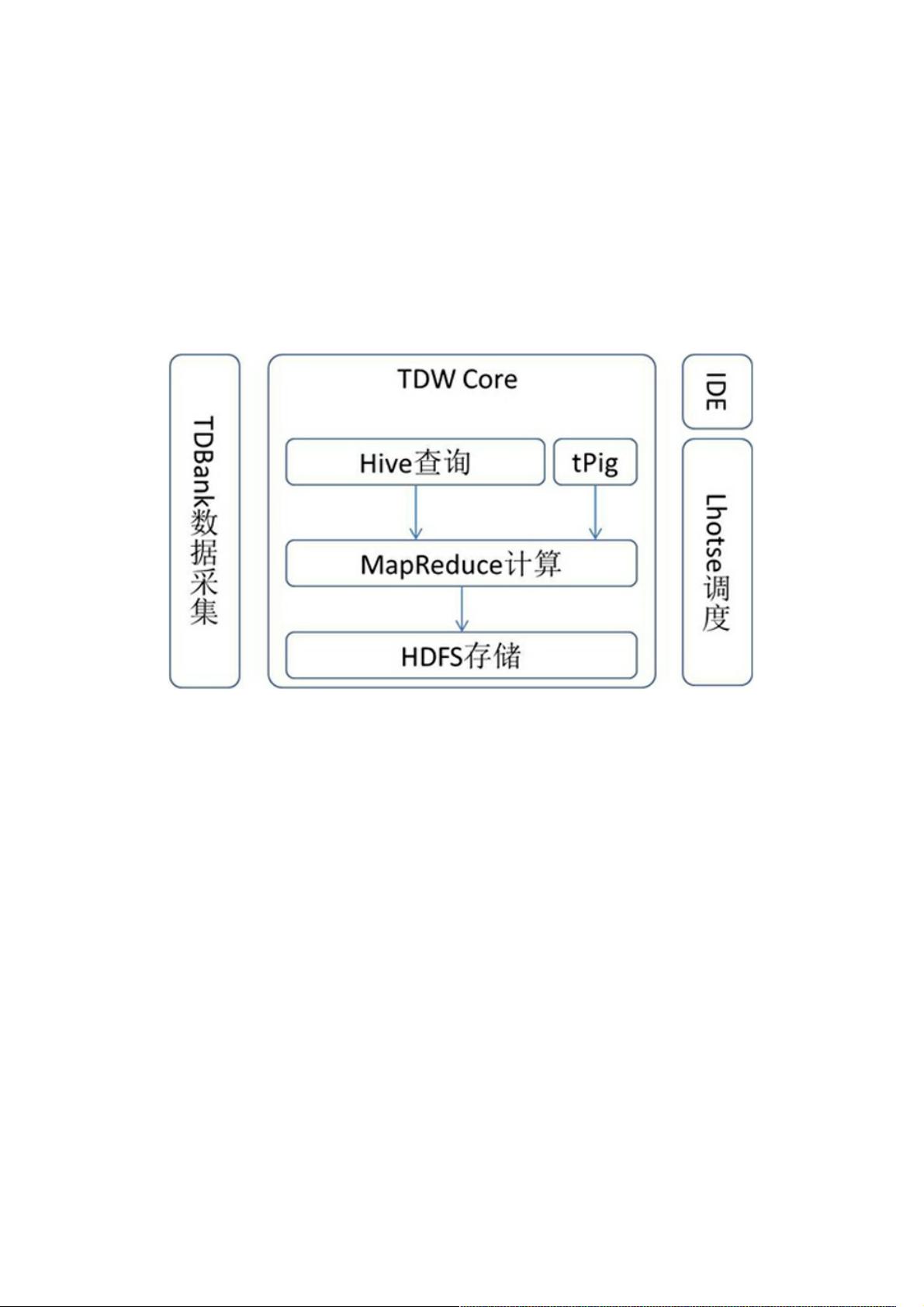

TDW由多个功能模块构成,包括Hive、MapReduce、HDFS、TDBank和Lhotse。HDFS是存储引擎,MapReduce是计算引擎,Hive则提供查询服务,TDBank负责数据的采集与接入,而Lhotse是任务调度系统,统一管理所有任务。这些模块共同协作,为腾讯的各类业务提供高效稳定的数据处理能力。

建设单个大规模Hadoop集群的主要动机有三个:首先,数据共享是关键,跨IDC或跨集群的数据访问会消耗大量网络带宽,甚至可能导致存储浪费。其次,计算资源共享能提高效率,避免某些集群资源紧张而其他集群资源闲置。最后,通过整合集群,可以减轻运营压力,降低成本,提高整体运维效率。

在面对如此大规模的集群时,TDW实施了两个关键优化策略:JobTracker的分散化和NameNode的高可用。JobTracker分散化是为了提升任务调度的效率和集群的容错能力,通过将JobTracker职责分散到多个节点,降低了单点故障的风险,同时也均衡了系统的负载。NameNode高可用则是为了保证数据存储系统的稳定性,通过设置热备NameNode,确保在主NameNode故障时能迅速切换,避免数据访问中断。

未来,腾讯将继续优化TDW,可能涉及的领域包括但不限于进一步提升集群的扩展性、提高计算效率、优化数据处理流程、增强系统监控和自动化运维能力,以及探索更先进的大数据处理技术,以应对不断增长的业务需求和数据挑战。腾讯的大规模Hadoop集群实践展现了其在大数据处理领域的领先地位和技术实力,为业界提供了宝贵的实践经验。

2014-08-20 上传

2014-05-29 上传

140 浏览量

2014-05-29 上传

点击了解资源详情

点击了解资源详情

2021-02-26 上传

点击了解资源详情

点击了解资源详情

weixin_38678498

- 粉丝: 3

- 资源: 914

最新资源

- php-microservice-cqrs-es:使用CQRS + Event SourcingPHP Microservice样板

- xMovingMap:适用于X-Plane的Android移动地图

- layout_style-it-up

- gitcommands:有用的 Git 命令

- ArpSpoof

- wetch-frontend:TFM UOC

- 毕业设计&课设-行人检测系统的MatLab代码.zip

- 睡眠教学助手:OS项目:使用互斥锁和信号灯的睡眠教学助手

- liczby_pierwsze

- Spider-Programmes:Here is a collection of my web crawler repositories.(汇聚了我的爬虫程序仓库)

- keystone:梯形飞地(QEMU + HiFive Unleashed)

- lumen-api-query-parser:基于laravel流明框架的REST-API查询解析器

- reticulate:R与Python的接口

- 客户端-服务器-聊天-对等之间:套接字编程的C#GUI应用程序,两个客户端通过同一ip和端口进行双方聊天

- LogiKM:一站式Apache Kafka集群指标监控与运维管控平台

- 毕业设计&课设-基于Matlab的物体轨迹仿真.zip