《Learning Node》第二版:服务器端开发文字版

需积分: 10 87 浏览量

更新于2024-07-19

收藏 11.85MB PDF 举报

"Learning Node:Moving to the Server 文字版 第二版"

《Learning Node:Moving to the Server》是由Shelley Powers编著的一本关于Node.js服务器开发的书籍,适用于那些想要从客户端开发转向服务器端开发的开发者。本书旨在帮助读者理解和掌握Node.js的核心概念和技术,从而能够有效地构建高性能的网络应用。

Node.js是一个基于Chrome V8引擎的JavaScript运行环境,它允许开发者使用JavaScript进行服务器端编程。Node.js以其非阻塞I/O和事件驱动的模型而著名,这使得它在处理高并发请求时表现出色,特别适合于实时应用和数据密集型的实时应用(如聊天、协作工具或流媒体服务)。

在书中,作者详细讲解了以下Node.js的知识点:

1. **基础环境搭建**:包括安装Node.js环境,了解npm(Node包管理器)以及如何创建和管理项目依赖。

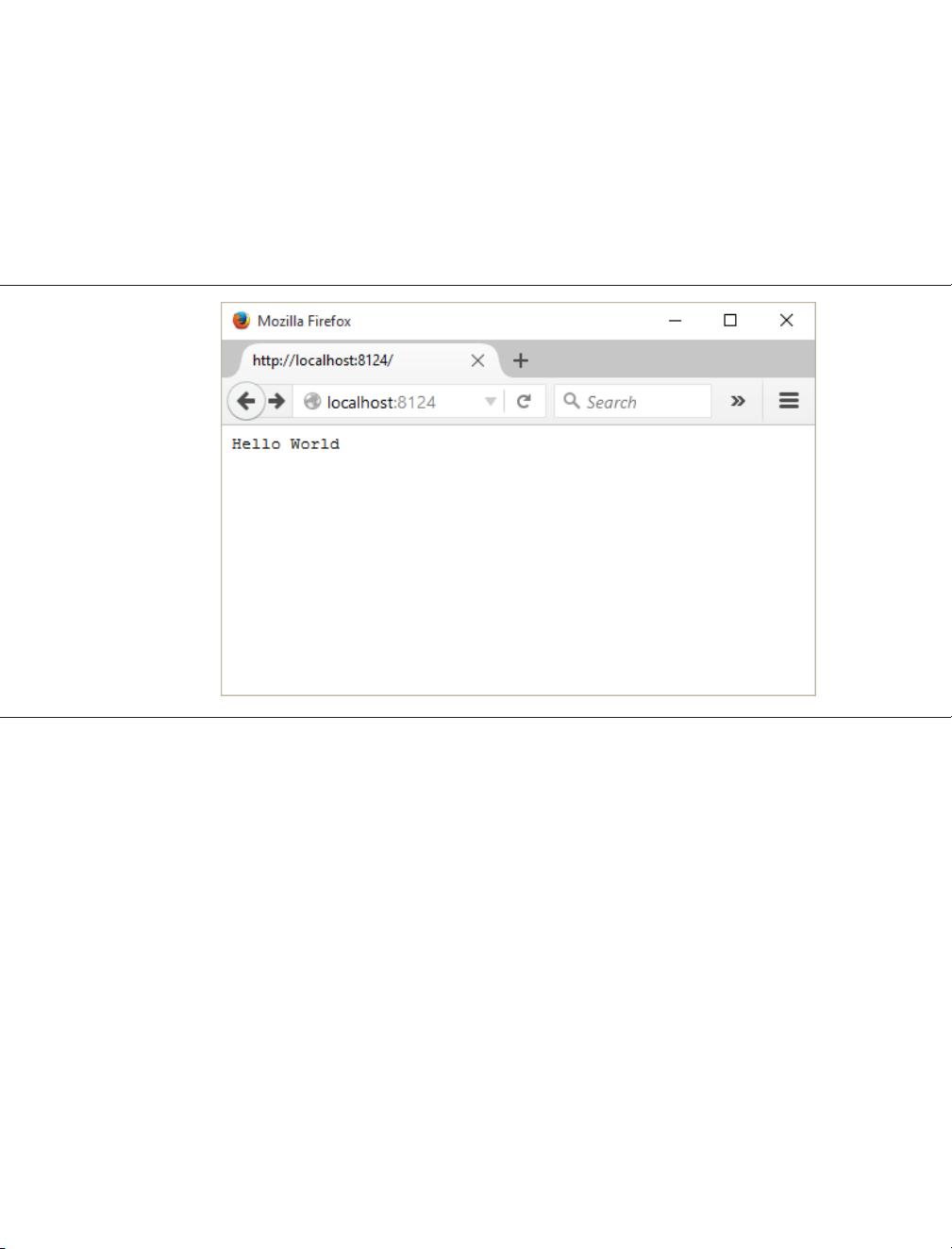

2. **核心模块**:涵盖Node.js的基础模块,如`fs`(文件系统)模块用于文件操作,`http`模块用于构建HTTP服务器,`net`模块用于TCP和UDP通信,以及`path`模块处理路径相关的任务。

3. **异步编程**:探讨Node.js的事件循环和回调函数,理解非阻塞I/O的工作原理,以及如何避免回调地狱。

4. **模块系统**:深入理解Node.js的模块系统,包括`require`和`module.exports`,以及CommonJS规范。

5. **Express框架**:介绍流行的Express框架,它是构建Web应用的快速、开放、极简的Web开发框架,它简化了路由设置、中间件使用和视图渲染。

6. **数据库集成**:讲解如何使用MongoDB或其他NoSQL数据库,以及ORM(对象关系映射)工具,如Mongoose,来与Node.js集成。

7. **错误处理**:学习如何有效地处理和报告错误,以提高应用的健壮性。

8. **测试和调试**:介绍使用Mocha、Chai等工具进行单元测试和集成测试,以及如何进行应用的调试。

9. **性能优化**:讨论如何监控和优化Node.js应用的性能,包括CPU使用率、内存管理和集群(cluster)模块的使用。

10. **安全实践**:涉及认证、授权、防止XSS和CSRF攻击,以及数据安全的最佳实践。

本书是Node.js初学者和有一定经验的开发者提升技能的良好资源,通过实际案例和练习,帮助读者将理论知识转化为实际开发能力。无论你是前端开发者希望拓宽技能范围,还是对服务器端编程感兴趣,这本书都将提供必要的指导和洞察。

2017-10-05 上传

169 浏览量

2023-09-13 上传

2023-07-22 上传

2023-03-31 上传

2023-12-12 上传

2023-04-04 上传

2023-06-09 上传

2023-05-03 上传

2023-05-16 上传

beyondcaoyong

- 粉丝: 0

- 资源: 6

最新资源

- 新型智能电加热器:触摸感应与自动温控技术

- 社区物流信息管理系统的毕业设计实现

- VB门诊管理系统设计与实现(附论文与源代码)

- 剪叉式高空作业平台稳定性研究与创新设计

- DAMA CDGA考试必备:真题模拟及章节重点解析

- TaskExplorer:全新升级的系统监控与任务管理工具

- 新型碎纸机进纸间隙调整技术解析

- 有腿移动机器人动作教学与技术存储介质的研究

- 基于遗传算法优化的RBF神经网络分析工具

- Visual Basic入门教程完整版PDF下载

- 海洋岸滩保洁与垃圾清运服务招标文件公示

- 触摸屏测量仪器与粘度测定方法

- PSO多目标优化问题求解代码详解

- 有机硅组合物及差异剥离纸或膜技术分析

- Win10快速关机技巧:去除关机阻止功能

- 创新打印机设计:速释打印头与压纸辊安装拆卸便捷性