深入理解Tensorflow分布式架构与执行机制

185 浏览量

更新于2024-08-28

收藏 305KB PDF 举报

"Tensorflow分布式原理理解"

在深入探讨TensorFlow的分布式原理之前,我们首先要明白TensorFlow的基本工作流程。TensorFlow是一种数据流图为基础的计算框架,用户通过定义计算图来构建模型。在这个过程中,计算图由一系列的操作(OPs)和节点组成,它们代表了数学运算或数据处理步骤。在实际运行时,这些图会被分解并执行在不同的设备上,如CPU或GPU。

**1. TensorFlow实现原理**

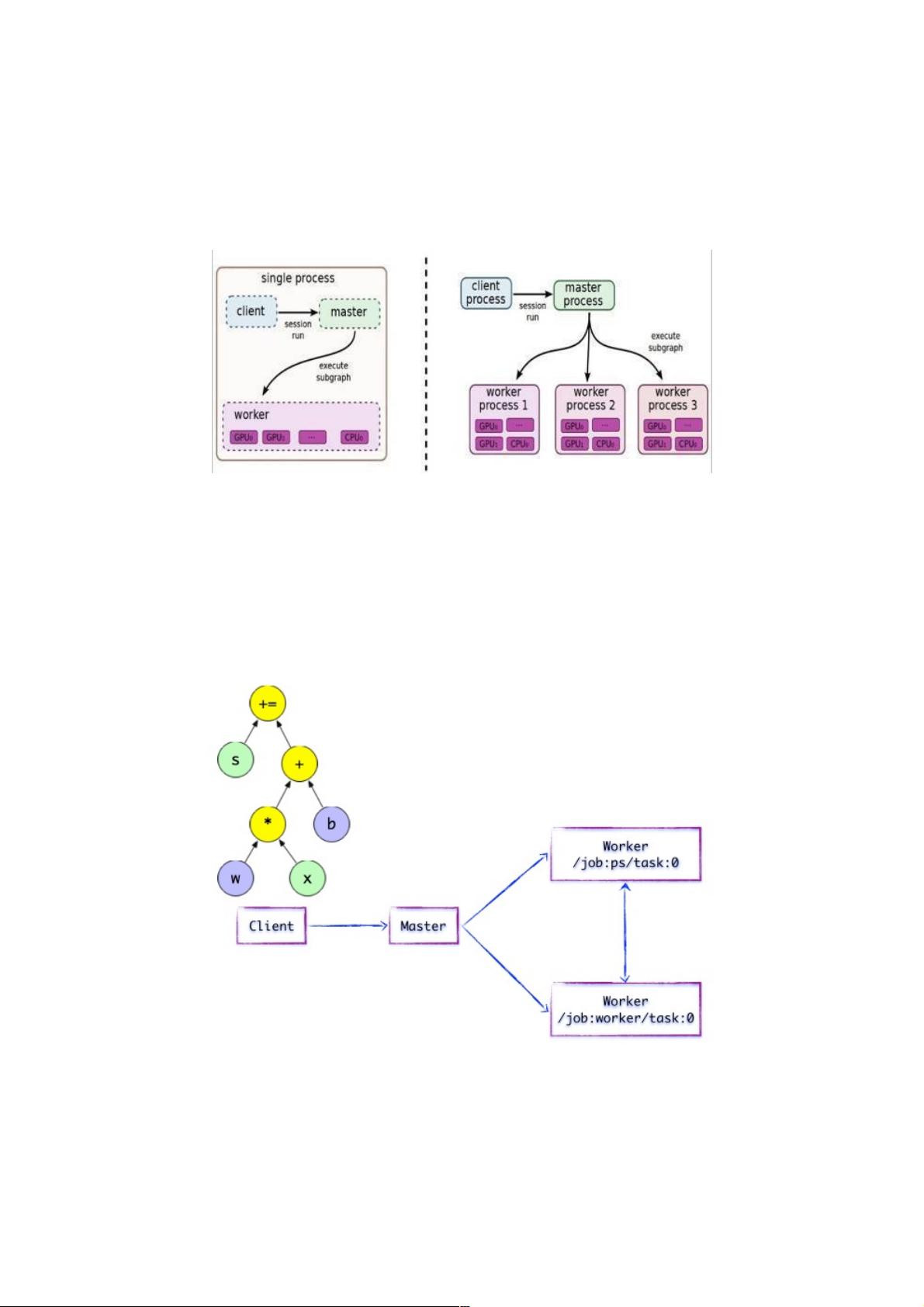

TensorFlow的核心组件包括Client、Master和Worker。Client是用户编写和运行代码的地方,它构建计算图并通过Session接口与Master通信。Master作为协调者,负责管理和调度整个计算图的执行。Worker则执行实际的计算任务,每个Worker可以连接到多台硬件设备,如CPU或GPU,管理这些设备上的计算。

在单机模式下,Client、Master和Worker都位于同一台机器的同一个进程中。而在分布式模式中,它们可以在不同的机器上运行,通过网络进行通信,这使得大规模的并行计算成为可能。

**2. 分布式计算图的执行**

在分布式环境中,Client创建的计算图被发送到DistributedMaster。DistributedMaster会根据Session.run的请求,找出需要执行的子图。这个过程通常是从计算图的输出节点反向遍历,找到所有必需的输入节点和它们的依赖。

**3. 子图拆分与分发**

DistributedMaster将找到的子图进一步拆分为更小的“子图片段”,这些片段可以分别在不同的Worker上并行执行,提高效率。每个Worker上的WorkService负责执行分配给它的“本地子图”。DistributedMaster还会缓存这些子图,以减少重复计算,提高性能。

**4. 执行图计算**

一旦子图被拆分并分发,Worker就开始执行各自的计算任务。每个Worker在自己的设备上运行子图,完成计算后,结果会被返回给DistributedMaster。Master收集所有结果,组合成最终的计算输出,然后回传给Client。

**5. 集群调度系统**

在分布式环境中,集群调度系统如Google的Parameter Server或YARN等,会负责资源分配和任务调度,确保各个Worker的有效协作和资源的高效利用。

理解TensorFlow的分布式原理对于优化大规模深度学习模型的训练至关重要。它能够帮助我们更好地理解如何利用多台机器的计算资源,以及如何设计和优化分布式训练策略,以加快模型训练速度,提升整体性能。在实际应用中,根据不同的场景和需求,可以选择合适的分布式模式,如数据并行、模型并行或混合并行,以适应不同的计算需求。

151 浏览量

107 浏览量

238 浏览量

156 浏览量

273 浏览量

107 浏览量

2022-07-11 上传

192 浏览量

点击了解资源详情

weixin_38729108

- 粉丝: 5

- 资源: 896

最新资源

- taro + vue3 开发微信小程序的模板.zip

- 微信小程序设计-美容美甲商城.zip

- ros的slam建图导航

- 微信小程序设计-守望先锋资讯小程序.zip

- C语言C++ 爱心表白代码.zip

- 微信小程序设计-和茶网.zip

- GUI PRO Kit - Sci-Fi Survival

- 微信小程序设计-托福资料(完整带Java后台).zip

- Shift - Complete Sci-Fi UI

- 阿里云DataV数据可视化.zip

- 微信小程序设计-HIAApp.zip

- 大数据工程师方向面试题库,包括Flink,Hadoop,Hbase,Hive,Kafka,Liunx,Spark,Sqoop,Z

- 微信小程序设计-零食商城.zip

- taro + vue3 开发微信小程序的模板.zip

- 微信小程序设计-熊猫签证.zip

- 微信小程序设计-仿美团外卖.zip