"RNN基本结构对比及扩展模型分析"

需积分: 0 182 浏览量

更新于2024-01-19

收藏 4.7MB PDF 举报

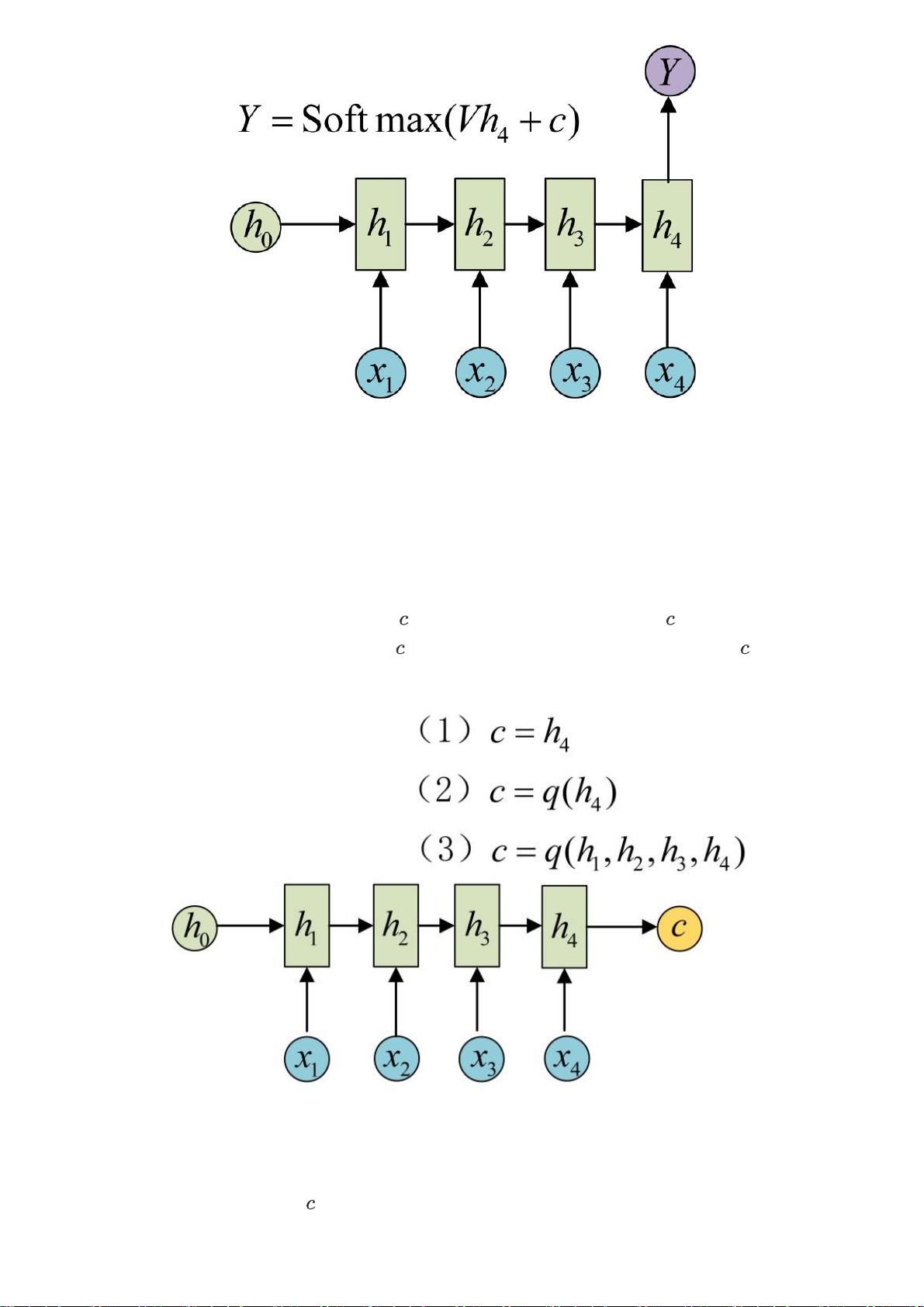

本文总结了RNN基本结构的对比、常见的RNNs扩展和改进模型,以及在文本摘要、阅读理解和语音识别等应用中的使用。首先介绍了RNN的基本结构,包括经典RNN结构、vector-to-sequence结构、sequence-to-vector结构和Encoder-Decoder结构。经典RNN结构使用隐状态对序列数据进行特征提取,并转换为输出。vector-to-sequence结构用于输入一个单独值,输出一个序列。sequence-to-vector结构用于输入一个序列,输出一个单独的值。Encoder-Decoder结构用于处理序列不等长的问题,通过编码输入数据生成上下文向量,然后根据解码器生成输出。

接着介绍了Attention机制在通用的Encoder-Decoder结构上的应用。Attention机制可以解决长序列输入时的信息损失问题。通过引入Attention机制,模型可以根据输入的不同部分动态地分配注意力权重,提高了模型的性能。

在RNN的扩展和改进模型方面,本文介绍了几种常见的模型,包括LSTM、GRU和Bidirectional RNN等。LSTM通过引入门控机制来解决传统RNN的梯度消失和梯度爆炸问题。GRU是LSTM的简化版本,减少了参数的数量,但在一些任务上性能相当。Bidirectional RNN使用了两个方向的RNN,可以捕捉到序列中过去和未来的上下文信息。

在具体应用方面,本文介绍了文本摘要、阅读理解和语音识别等任务中RNN的应用。文本摘要任务可以根据输入的文章生成相应的摘要。阅读理解任务可以根据给定的文章和问题,生成相应的答案。语音识别任务可以根据输入的语音序列信息生成相应的文字序列。

总而言之,RNN基本结构及其扩展和改进模型在序列数据处理和相关任务中具有广泛应用。通过不同结构和模型的组合和改进,可以有效地解决序列数据的建模和处理问题。

845 浏览量

143 浏览量

139 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

柏傅美

- 粉丝: 32

- 资源: 325

最新资源

- 基于Matlab和CPLEX的2变量机组组合调度程序,matlab调用cplex例题,matlab

- rotiro

- Albert-Guimaraes:Modelo dePáginaHTML CSS-特马

- ListViewWithSubListView:Xamarin.Forms具有Sub-ListView MVVM模式的可扩展ListView

- data-protection:数据保护

- opencv4.1_cache.rar

- 合闸、跳闸位置继电器的配合分析.rar

- Java面试简历项目及模板

- 行业文档-设计装置-一种折页机用齐纸桌.zip

- pid控制器代码matlab-PID_Kalman:PID_卡尔曼

- elizabethtlewis.github.io

- Matlab 基于粒子群优化算法优化支持向量机(PSO-SVM)的数据分类预测 PSO-SVM分类

- curriculum-vitae:我尝试使用vitae包制作R的简历

- Simple-ajax-domain-checker:简单的ajax域检查器

- SourceInsight_17473.zip

- Code.rar_PRED-163_matlab pred_社交网络_社交网络分析 链路预测_链路预测