数据流聚类:理论与实践

需积分: 9 147 浏览量

更新于2024-07-17

收藏 314KB PDF 举报

"Clustering Data Streams: Theory and Practice"

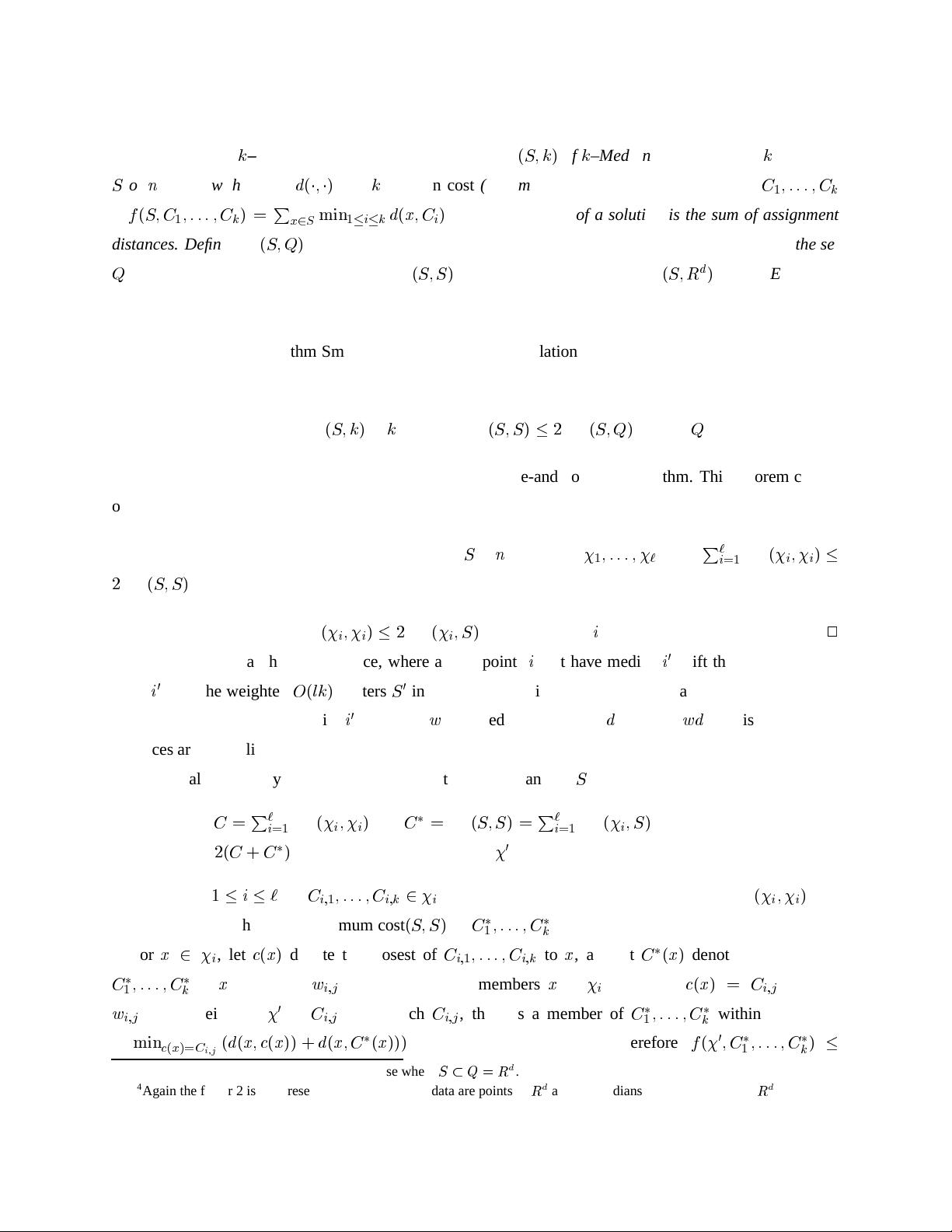

在数据科学领域,数据流聚类是一种处理不断涌入且可能无限的数据序列的技术。随着大数据的快速发展,数据流模型因其对大规模动态数据集的有效处理能力而受到广泛关注。这篇由Sudipto Guha、Adam Meyerson、Nina Mishra、Rajeev Motwani和Liadan O’Callaghan合作撰写的论文,详细探讨了数据流聚类的理论与实践。

论文中提到,数据流模型是由于各种类型的数据,如电话记录、网页文档和点击流等,其应用需求而兴起的。这种模型的一个关键特性是在有限的内存和计算资源下,能够对数据进行一次或少数几次扫描(线性扫描或通过)来完成分析。这在处理海量实时数据时尤为重要。

作者提出了一种针对数据流的聚类算法,该算法能够在处理大量数据流时保持高效性能。聚类是数据挖掘中的一个重要任务,旨在将相似的数据点分组到一起,形成所谓的“簇”。对于数据流,传统的聚类算法可能无法适应,因为它们通常假设数据可以被反复访问且内存资源充足。

论文提供的实证分析展示了该算法在合成数据流和真实数据流上的表现,证明了其在处理数据流时的有效性和适应性。通过对比和评估,作者可能展示了算法如何在处理速度、内存占用和聚类质量之间找到平衡,这对于实时数据分析和决策制定至关重要。

在介绍部分,论文定义了数据流的基本概念:一个有序的点序列(x1, ..., xn),这些点只能按顺序读取,且通常只能读取一次或少量次。这样的模型特别适用于那些需要快速响应、实时分析的场景,如网络流量监控、社交媒体分析或金融交易监控。

总结来说,这篇论文为数据流聚类提供了理论基础和实践经验,对于理解如何在资源受限的情况下处理不断变化的数据集具有重要的指导意义。它强调了在数据流环境下设计和评估聚类算法的挑战,以及解决这些挑战的方法,对于大数据分析和相关领域的研究者和从业者都极具价值。

2021-08-31 上传

2021-09-30 上传

2023-07-08 上传

2023-06-02 上传

2023-06-03 上传

2023-06-06 上传

2023-06-07 上传

2023-05-24 上传

2023-06-12 上传

2023-06-11 上传

寒沧

- 粉丝: 271

- 资源: 161

最新资源

- 多模态联合稀疏表示在视频目标跟踪中的应用

- Kubernetes资源管控与Gardener开源软件实践解析

- MPI集群监控与负载平衡策略

- 自动化PHP安全漏洞检测:静态代码分析与数据流方法

- 青苔数据CEO程永:技术生态与阿里云开放创新

- 制造业转型: HyperX引领企业上云策略

- 赵维五分享:航空工业电子采购上云实战与运维策略

- 单片机控制的LED点阵显示屏设计及其实现

- 驻云科技李俊涛:AI驱动的云上服务新趋势与挑战

- 6LoWPAN物联网边界路由器:设计与实现

- 猩便利工程师仲小玉:Terraform云资源管理最佳实践与团队协作

- 类差分度改进的互信息特征选择提升文本分类性能

- VERITAS与阿里云合作的混合云转型与数据保护方案

- 云制造中的生产线仿真模型设计与虚拟化研究

- 汪洋在PostgresChina2018分享:高可用 PostgreSQL 工具与架构设计

- 2018 PostgresChina大会:阿里云时空引擎Ganos在PostgreSQL中的创新应用与多模型存储