Spark推荐引擎:基于交替最小二乘法的音乐偏好分析与个性化推荐

需积分: 6 49 浏览量

更新于2024-09-09

收藏 1.36MB DOCX 举报

计算机综合实验主要围绕推荐引擎的大数据分析应用展开,目标是通过利用Spark和Scala技术来构建一个个性化音乐推荐系统。该系统旨在解决在互联网音乐平台中如何根据用户的行为数据,尤其是收听历史,预测用户可能喜欢的音乐家或歌曲,从而提高用户体验和平台粘性。

Spark推荐引擎项目的任务描述着重于协同过滤算法,具体使用了Spark MLlib库中的交替最小二乘法(Alternating Least Squares, ALS),这是一种用于推荐系统的矩阵分解算法。ALS能够有效地处理大规模数据,通过分析用户对不同音乐家的喜好程度,生成个性化的推荐列表。

数据集的核心组成部分包括三个文件:

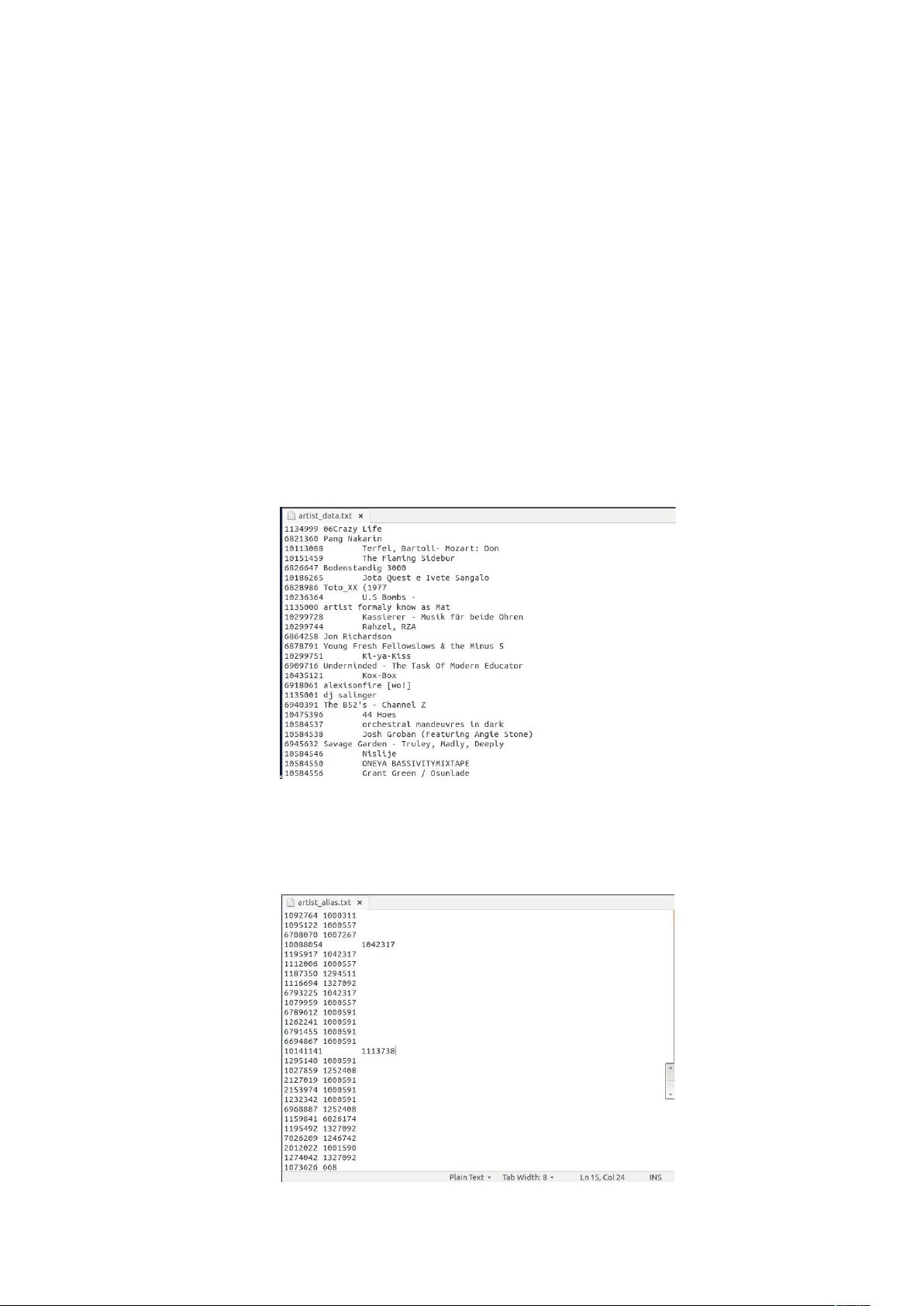

1. **artist_data.txt**:存储了音乐家的ID和名称。由于Spark MLlib要求用户和产品ID为数值型,且是32位无符号整数,因此所有超过Integer.MAX_VALUE的ID被视为无效。数据需要进行预处理,确保ID转换为合适的格式。

2. **artist_alias.txt**:这个文件用于处理拼写错误或非标准的音乐家ID,将它们映射到标准ID,以确保数据的一致性和准确性。

3. **user_artist_data.txt**:记录了用户与音乐家的交互数据,包括用户ID、音乐家ID和收听次数。这部分数据对于推荐算法至关重要,反映了用户的音乐偏好。

在数据预处理阶段,对artist_data.txt的处理尤其关键。文件中的数据格式是制表符分隔,需要通过`span()`函数解析,将每一行分割成艺术家ID和名字两部分。同时,需要处理异常情况,如没有制表符的行或意外的换行符,这可能导致解析错误。为了简化代码并避免重复解析,可以使用`flatMap()`函数将可能的异常行过滤掉,只保留有效的数据。

整个实验涉及到了数据分析的基本步骤,如数据清洗、数据转换以及使用分布式计算框架Spark进行大规模数据处理。通过实施此项目,参与者将能够深入理解推荐系统背后的理论和实践,同时增强对Spark编程和Scala语言的理解,特别是在处理大数据场景下的算法实现和优化。

点击了解资源详情

154 浏览量

137 浏览量

154 浏览量

108 浏览量

262 浏览量

178 浏览量

snowbaby1234

- 粉丝: 28

- 资源: 3

最新资源

- IA-32 Assembly Language

- DOS下常用网络相关命令解释

- GIS新引擎——“真图”数据解决方案.pdf

- 嵌入式Linux设备驱动开发.pdf

- JPA入门_PDF JPA

- 计算机网络技术 计算机网络技术

- 计算机通信技术计算机通信技术

- 初学者编程学习的文章

- BS EN 71-1-2005(+A4-2007)

- 消灭压力的高效工作方法

- 《Modeling Our World》中文版本

- Linux 上的GNOME 2.2 桌面用户指南.pdf

- Linux 系统上的GNOME 2.2 桌面管理指南.pdf

- 生化要点把一些生化要点都总结

- Linux内核完全注释-1.9.5.pdf

- 新版设计模式手册[C#]