视频Transformer:未来动作预测的注意力模型

201 浏览量

更新于2024-06-20

收藏 1.03MB PDF 举报

“视频Transformer:预测未来视频动作的注意力机制模型”

本文介绍了预期视频Transformer(AVT),这是一种基于注意力机制的端到端视频建模架构,旨在通过分析先前观察到的视频来预测未来的动作。AVT模型的独特之处在于,它不仅能够保持已观察到动作的顺序进展,还能捕捉长程依赖性,这对于预测任务至关重要。通过联合训练,模型可以预测视频序列中的下一个动作,并学习预测连续未来帧的特征。

在介绍部分,作者强调了预测人类未来行为在自动驾驶、增强现实等领域的关键作用。传统的动作识别技术已经无法满足需求,因为视觉系统需要有能力预测即将发生的动作。因此,活动预期任务逐渐受到重视,并有多个挑战基准被设立来推动这一领域的发展。

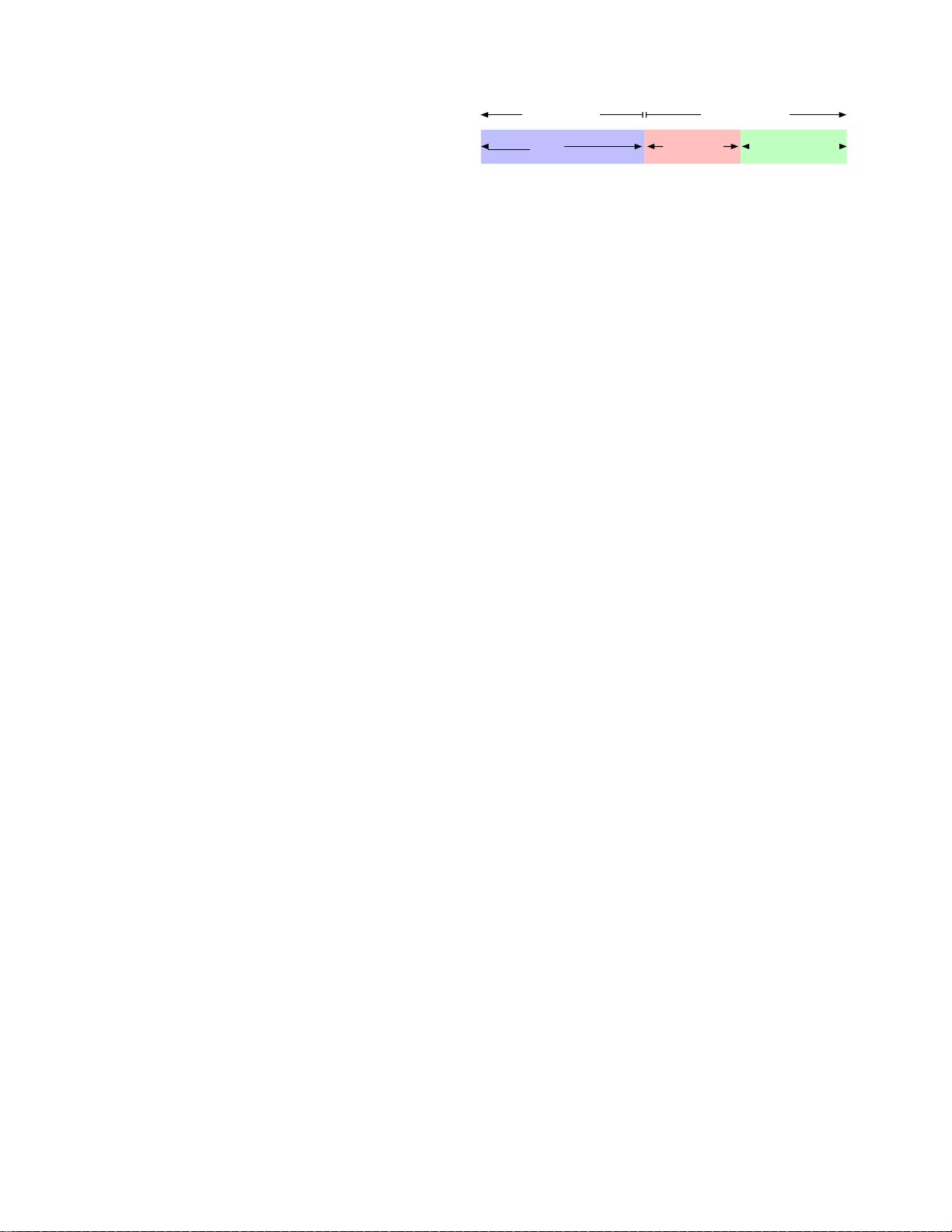

AVT模型的设计借鉴了Transformer架构,特别是其注意力机制。如图1所示,AVT首先使用空间注意力骨干对视频帧进行编码,然后通过时间注意力头部关注当前帧之前的相关帧,以预测未来动作。在示例中,模型能自发地关注手部和物体,无需额外的监督,且能聚焦于预测下一个动作所需的最关键帧。

在实验部分,AVT在四个流行的活动预期基准测试中表现出最佳性能:EpicKitchens-55、EpicKitchens-100、EGTEA Gaze+和50-Salads,并在EpicKitchens-100 CVPR'21挑战赛中赢得第一名。这些成就证明了AVT在处理复杂视觉信号和预测未来动作方面的能力。

与现有技术相比,AVT的优势在于其能够在保持时间顺序的同时,利用Transformer的注意力机制捕捉长期的上下文信息。这使得AVT在处理如行人行为预测、AR应用等场景时,能够更准确地预测未来事件,为人工智能系统提供更强大的预测能力。

视频Transformer(AVT)是一个创新的模型,它通过独特的注意力机制,有效地解决了视频中未来动作预测的挑战。其成功应用和优秀的基准测试成绩展示了该模型在实际应用中的巨大潜力,特别是在需要预测和理解人类行为的领域。

467 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

191 浏览量

点击了解资源详情

点击了解资源详情

189 浏览量

点击了解资源详情

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- 支持水平滚动视图ScrollView效果

- 51单片机 pwm波产生.zip

- 音游SDVX.zip

- pivotal-cli:用于处理 Pivotal Stories 的简单命令行工具

- 阻抗分析软件 Zview3.1最新版本.zip

- ocpp1.6.zip

- ComputerArchitecture:计算机架构项目

- habitat-challenge:栖息地挑战代码

- DecomposeText v2.2 (分解文字为图层).rar

- Five Tier-crx插件

- magedebugbar

- Lab-3A:Wireless Comms '21 Spring的代码和文档

- godot-engine.github-integration:Godot Engine插件,用于在Godot的Editor中集成本地GitHub客户端。 无需打开浏览器即可管理您的项目!

- dexter:用于响应式单页应用程序和移动 Web 应用程序的全功能框架

- 信息管理平台登录界面模板

- win-zfs:Windows中ZFS的用户模式实现