注意力机制的多模态融合:提升模型性能的新途径

发布时间: 2024-08-22 18:45:03 阅读量: 238 订阅数: 23

# 1. 注意力机制概述

注意力机制是一种神经网络技术,旨在模拟人类视觉系统对特定区域的关注能力。它通过分配权重来突出输入数据中重要的特征,从而提高模型的性能。

注意力机制的原理是通过一个查询向量和一个键向量之间的点积计算,得到一个注意力分数。该分数表示查询向量中每个元素与键向量中相应元素相关性的强度。通过对注意力分数进行softmax归一化,可以得到一个概率分布,表示每个元素在输出中的重要性。

注意力机制的类型包括自注意力机制和交叉注意力机制。自注意力机制用于处理单模态数据,而交叉注意力机制用于处理多模态数据。

# 2. 多模态融合技术

### 2.1 多模态数据的特点和挑战

多模态数据是指包含来自不同来源或类型的多个模态的信息。这些模态可以是文本、图像、音频、视频或其他形式的数据。多模态数据具有以下特点:

- **异构性:**不同模态的数据具有不同的表示形式和语义含义。例如,文本数据是离散的,而图像数据是连续的。

- **互补性:**不同模态的数据可以提供互补的信息,从而提高对数据的理解。例如,文本可以描述图像中的对象,而图像可以提供文本中未提及的视觉信息。

- **复杂性:**多模态数据的融合需要解决异构性、互补性和复杂性带来的挑战。

### 2.2 多模态融合的常见方法

多模态融合的目的是将来自不同模态的数据有效地整合在一起,以提高对数据的理解和处理能力。常见的融合方法包括:

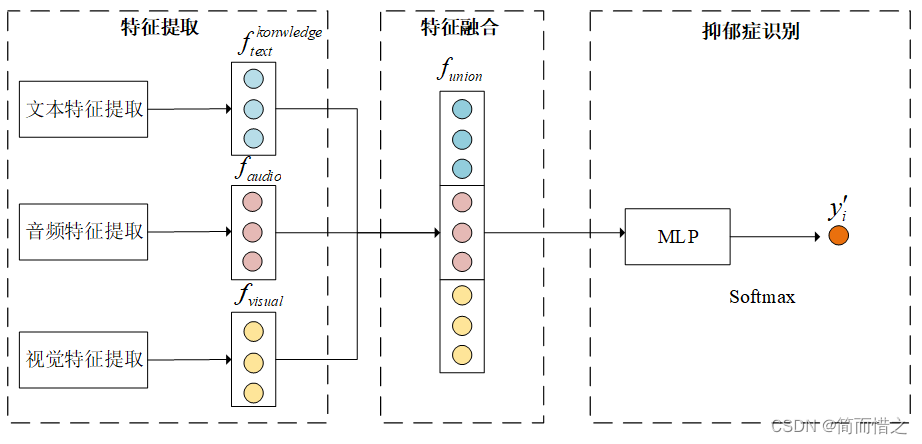

#### 2.2.1 特征级融合

特征级融合将不同模态的数据转换为统一的特征表示,然后将这些特征融合在一起。例如,文本数据可以转换为词嵌入,图像数据可以转换为视觉特征。融合后的特征可以用于训练机器学习或深度学习模型。

```python

import numpy as np

# 文本特征

text_features = np.array([[0.1, 0.2, 0.3], [0.4, 0.5, 0.6]])

# 图像特征

image_features = np.array([[0.7, 0.8, 0.9], [1.0, 1.1, 1.2]])

# 特征级融合

fused_features = np.concatenate((text_features, image_features), axis=1)

```

#### 2.2.2 决策级融合

决策级融合将不同模态的数据分别处理,然后将每个模态的预测结果进行融合。例如,文本分类器可以预测文本的类别,图像分类器可以预测图像的类别。融合后的决策可以用于最终的预测。

```python

import numpy as np

# 文本分类器

text_classifier = ...

# 图像分类器

image_classifier = ...

# 决策级融合

fused_predictions = np.argmax(text_classifier.predict(text_data)) * 0.5 + np.argmax(image_classifier.predict(image_data)) * 0.5

```

#### 2.2.3 模型级融合

模型级融合将不同模态的数据输入到一个统一的模型中,该模型可以同时处理所有模态的数据。例如,多模态 transformer 模型可以将文本、图像和音频数据作为输入,并输出一个融合后的表示。

```python

import transformers

# 多模态 transformer 模型

model = transformers.AutoModelForMultiModalImageTextAudio(...)

# 输入数据

text_input = ...

image_input = ...

audio_input = ...

# 模型级融合

outputs = model(text_input, image_input, audio_input)

```

# 3.1 注意力机制的原理和类型

注意力机制是一种神经网络技术,它允许模型关注输入数据中最重要的部分。它通过计算一个权重向量来实现,该权重向量分配给输入的不同元素。这些权重表示每个元素对最终输出的重要性。

**3.1.1 自注意力机制**

自注意力机制是一种注意力机制,它允许模型关注输入序列中的不同元素。它通过计算一个查询向量和一个键向量之间的点积来实现。查询向量是模型当前正在关注的元素,而键向量是输入序列中的所有元素。点积的结果是一个相似性分数,它表示查询向量与键向量之间的相似程度。

```python

import torch

import torch.nn as nn

class SelfAttention(nn.Module):

def __init__(self, dim):

super().__init__()

self.query = nn.Linear(dim, dim)

self.key = nn.Linear(dim, dim)

self.value = nn.Linear(dim, dim)

def forward(self, x):

# x: (batch_size, seq_len, dim)

query = self.query(x) # (batch_size, seq_len, dim)

key = self.key(x) # (batch_size, seq_len, dim)

value = self.value(x) # (batch_size, seq_len, dim)

# 计算相似性分数

scores = torch.einsum("bqd,dk->bqk", query, key) # (batch_size, seq_len, seq_len)

# 缩放分数并应用 softmax

scores = scores / sqrt(dim)

attn = torch.softmax(scores, dim=-1) # (batch_size, seq_len, seq_len)

# 加权求和

output = torch.einsum("bqk,bdv->bqd", attn, value) # (bat

```

0

0